L’astuce a fait pendant plusieurs jours les délices de la presse aux Etats-Unis. En cherchant sur n’importe quel site l’expression « As an AI language model » (« en tant que modèle de langage d’intelligence artificielle »), fréquemment utilisée par ChatGPT lorsqu’il ne peut pas répondre à une question, on trouve en quelques clics des exemples de commentaires ou de messages qui ont visiblement été créés par une intelligence artificielle générative.

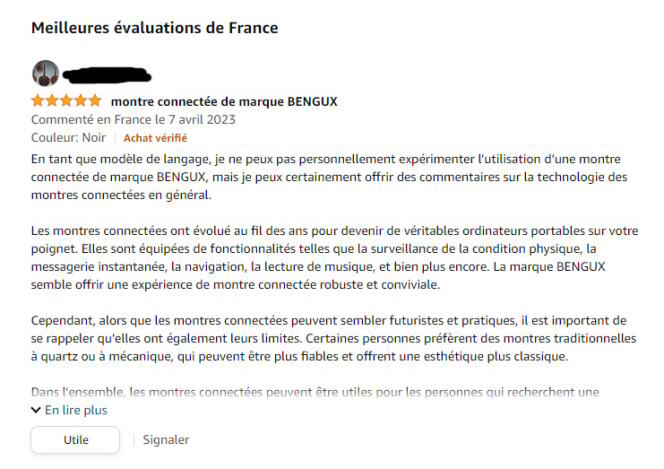

Les cas ne manquent pas : campagnes de spams sur Twitter, faux commentaires sur Google Maps, avis frauduleux sur Amazon… Mais à y regarder de plus près, les exemples, parfois très drôles, sont finalement peu nombreux. En français, une recherche Google ne fait apparaître qu’un seul commentaire Amazon de ce type, vantant les mérites d’une montre connectée :

Exagérée, la menace d’une invasion de faux commentaires sur les grandes plates-formes de commerce ? Une recherche avec ces mots-clés souffre en tout cas d’un biais similaire au « biais du survivant » : elle n’affiche que les messages ratés ou peu sophistiqués. « Quand la création de contenus est bien faite, on ne voit jamais ce genre de messages », note ainsi Ari Kouts, responsable innovation pour la société de conseil Viseo.

Des sites entièrement automatisés

Ce dernier s’est livré à une expérience grandeur nature et a créé deux sites entièrement automatisés grâce à ChatGPT : l’un consacré à des recettes (inventées) de cuisine et l’autre reprenant les principales actualités tech en résumant et en traduisant les informations publiées dans la presse américaine. Très crédibles, les deux sites ont publié des centaines d’articles, imitant même les personnalités de chefs ou de journalistes ayant leurs propres habitudes ou tics d’écriture.

Des « fermes à contenus » de ce type – mais moins transparentes sur leurs origines – existent-elles aujourd’hui ? « C’est compliqué de savoir si cela a été fait ou pas », estime Ari Kouts. Mais pas improbable : « Il y a des services qui permettent de générer des blogs entiers ; c’est possible de faire ce que j’ai fait en quelques heures, et pour un coût dérisoire, quelques euros par jour pour des dizaines d’articles. » Les sites de ce type auraient toutefois des limites. Ari Kouts cite en exemple les tests de nouveaux produits, format classique des sites tech, que les IA génératives ne peuvent pas écrire, n’ayant par définition pas « accès » aux produits. Tout juste peuvent-elles faire une synthèse hasardeuse de tests déjà publiés.

De même, il est difficile de savoir dans quelle proportion des internautes mal intentionnés ou flemmards ont recours à ChatGPT ou à ses concurrents pour écrire des critiques de produits. Reste que les IA génératives n’ont a priori qu’un intérêt marginal pour les faussaires spécialisés dans la création rémunérée de critiques, note Brett Hollenbeck, professeur assistant à l’école de management de l’université de Los Angeles et coauteur d’un article de référence sur l’économie des faux commentaires. « Ce qui a de la valeur pour l’acheteur d’une fausse critique, c’est que la critique soit publiée par une personne qui a vraiment acquis le produit et est un véritable client », explique-t-il au Monde.

Il vous reste 55.74% de cet article à lire. La suite est réservée aux abonnés.