Apple a dévoilé Private Cloud Compute, une technologie cloud présentée comme la solution à tous les problèmes de confidentialité posés par l’IA. D’après le groupe américain, cette innovation doit permettre d’interagir avec des modèles d’IA par le biais de serveurs privés sans compromettre les données personnelles de ses clients.

Après Microsoft, Google, Meta et consorts, Apple s’est lancé dans la course à l’intelligence artificielle générative. Dans le cadre de la conférence d’ouverture de la WWDC 2024, le géant de Cupertino a levé le voile sur Apple Intelligence, les premiers jalons de sa stratégie consacrée à l’IA.

Concrètement, Apple Intelligence consiste à incorporer de l’IA générative au sein de tous les systèmes d’exploitation d’Apple, comme iOS 18 ou macOS 15 Sequoia. Présente à tous les niveaux de l’OS, l’IA peut aider l’utilisateur à écrire un SMS, un mail ou une note, générer des emojis personnalisés, retoucher des images ou encore fournir des résumés textuels des appels. Sans surprise, Apple se sert aussi de l’IA pour donner un coup de fouet à Siri, l’assistant vocal de ses appareils.

À lire aussi : Le centre de contrôle d’iOS 18 est enfin personnalisable, voici comment

Des données traitées en local

Pour fonctionner, Apple Intelligence a besoin de piocher dans les données disponibles sur l’iPhone, l’iPad ou le Mac des utilisateurs. C’est grâce à ces informations que l’IA peut comprendre le contexte d’une requête et fournir une réponse précise et pertinente. Comme l’explique Apple, le nouveau Siri enrichi à l’IA générative est en « mesure de comprendre et d’agir avec le contenu des utilisateurs » au sein des applications.

Par exemple, vous pouvez demander à Siri s’il sera possible d’assister à la pièce de théâtre de votre fille. Pour vous répondre, Siri doit évidemment consulter vos informations personnelles. L’assistant va devoir se renseigner sur votre fille en consultant votre répertoire téléphonique et se rendre dans le calendrier pour chercher l’événement qui correspond. En parallèle, Siri va se renseigner au sujet de la localisation de l’événement pour pouvoir fournir un itinéraire, qui prend en charge l’évolution du trafic routier, jusque-là. Le processus brasse une belle quantité de données privées.

Conscient des inquiétudes potentielles de sa clientèle, Apple a conçu Apple Intelligence pour que le plus d’actions possible soient réalisées exclusivement en local, directement sur l’appareil. Les données sont traitées sur l’iPhone, l’iPad ou le Mac. Dans ce cas-là, aucune information n’est transmise sur des serveurs pour être traitée par l’IA. Apple indique que de « nombreux modèles » qui alimentent Apple Intelligence « fonctionnent entièrement sur l’appareil ». La majorité des requêtes les plus simples, qui nécessitent uniquement d’interagir avec des applications, peuvent être réalisées sur l’appareil. C’est pourquoi il faut impérativement disposer d’un appareil animé par une puce A17+ ou une puce M pour profiter d’Apple Intelligence. L’outil nécessite en effet une importante puissance de calcul.

Des serveurs privés pour des modèles d’IA plus grands

Néanmoins, il arrive que certaines tâches ne puissent pas être réalisées exclusivement en local. Dans certains cas, Apple Intelligence va devoir s’adresser à des modèles de langage plus performants. Afin de réaliser « des demandes plus complexes qui nécessitent plus de puissance de traitement », Apple Intelligence va convoquer des « modèles plus grands », précise Apple. L’outil va alors devoir communiquer avec des serveurs à distance. Pour protéger la confidentialité de ses clients, Apple a annoncé Private Cloud Compute. Selon Apple, cette solution permet d’utiliser l’IA dans le cloud tout en préservant les données des utilisateurs.

Apple précise que les grands modèles d’IA derrière Apple Intelligence reposent sur des serveurs privés animés par des puces conçues par Apple Silicon. Ils tournent sous un « système d’exploitation renforcé conçu pour la confidentialité », précise Apple dans un billet de blog. Ces serveurs, entièrement sous le contrôle de l’entreprise, permettant au géant californien de « s’assurer que les données ne sont jamais conservées ou exposées ». L’opération repose uniquement « sur des serveurs que nous avons créés », ce qui doit garantir la confidentialité des échanges, a expliqué Craig Federighi, vice-président de l’ingénierie logicielle chez Apple, en marge de la conférence d’ouverture, rapporte Ars Technica.

Des communications chiffrées

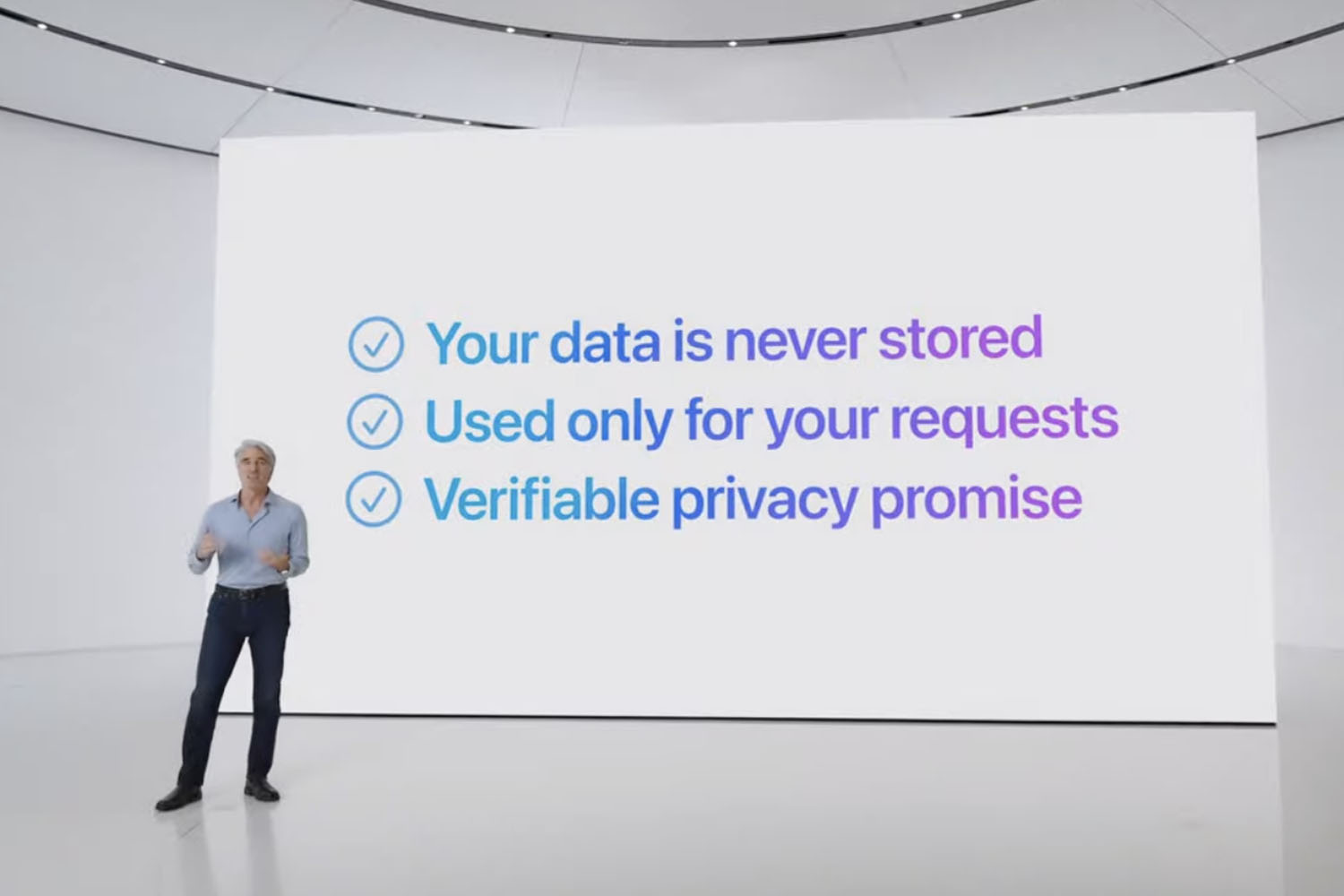

Quand Apple Intelligence reçoit une demande de la part de l’usager, le service va d’abord tenter d’y répondre en passant par les modèles disponibles en local. Si ce n’est pas possible, l’IA va contacter les serveurs d’Apple dans le cloud. Les données nécessaires sont alors traitées par les modèles qui reposent sur des serveurs privés, mais les informations ne sont pas stockées. De plus, Apple « n’envoie que les données pertinentes pour accomplir la tâche », souligne Craig Federighi. Les serveurs n’obtiennent pas un accès complet à vos données. Enfin, les données ne sont pas utilisées pour entraîner les modèles ou pour répondre ultérieurement à d’autres questions. Comme le résume Apple, « les données personnelles ne laissent aucune trace dans le système ».

« Vos données ne sont jamais stockées ou rendues accessibles à Apple », déclare Craig Federighi.

Apple ajoute que Private Cloud Compute a été conçu pour empêcher l’iPhone, l’iPad et le Mac de se connecter à un serveur dont le logiciel n’a pas été « enregistré publiquement pour inspection ». Si le logiciel ne peut pas être inspecté, la communication ne sera pas possible. Cette précaution évite les fuites de données personnelles. Confiant, Apple propose à des « experts indépendants » d’inspecter le code de ses serveurs pour prouver que toutes les communications sont effectivement chiffrées. En théorie, il n’est pas possible d’intercepter les informations échangées entre un iPhone et un serveur privé. En laissant le code accessible au public, Apple cherche à montrer patte blanche.

Le cas ChatGPT

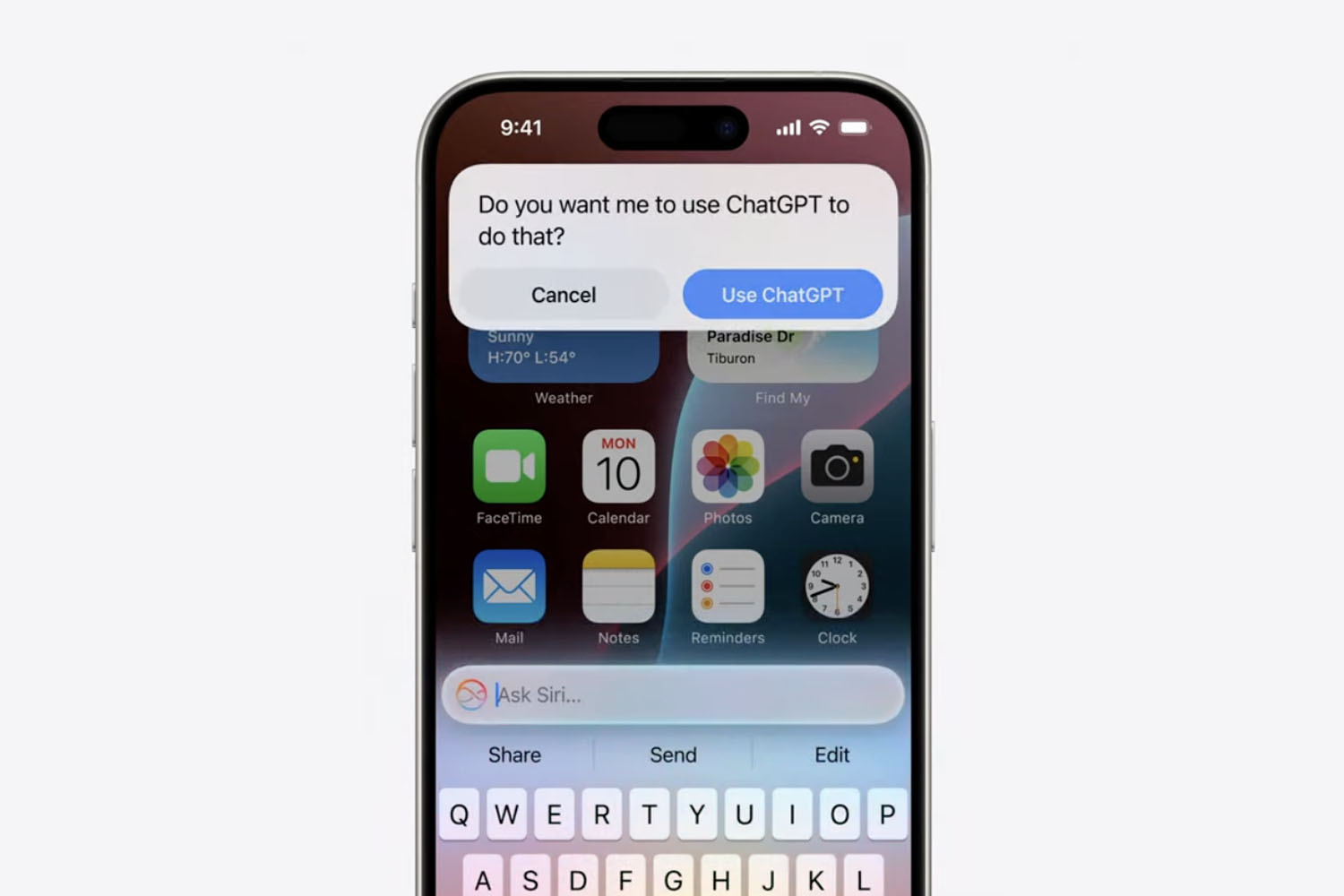

Enfin, il existe un troisième cas de figure dans la manière dont Apple Intelligence répond aux requêtes des utilisateurs. Pour les questions les plus complexes, le système proposera de vous relayer vers ChatGPT, le chatbot d’OpenAI. Dans ce cas-là, la réponse sera traitée par le modèle GPT-4o par le biais des serveurs d’OpenAI.

Avant de confier une tâche trop complexe à ChatGPT, Siri va systématiquement demander l’accord de l’utilisateur. Par ailleurs, Apple a mis en place des « protections de la vie privée » pour protéger la confidentialité de ses clients, même lorsqu’un tiers, à savoir ChatGPT, est invité dans la conversation avec Siri. Les adresses IP sont masquées. De plus, OpenAI « ne stocke pas les demandes » envoyées par les utilisateurs Apple. Il faut néanmoins que les utilisateurs accordent leur confiance à un tiers dans le processus.

? Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.