L’accouchement a duré trois ans. Et le bébé a trouvé un nom de combat : « Raptor Lake », ou les processeurs grand public Core de 13e génération d’Intel. Des puces qui reprennent la philosophie de la précédente génération Alder Lake : marier de gros cœurs Core performants (les P-Core) à une horde de cœurs CPU plus petits, mais énergétiquement plus efficaces (les E-Core). « Le challenge d’Alder Lake, qui a peut-être échappé à certains commentateurs, était non seulement l’architecture hybride. Mais aussi et surtout qu’elle est conçue pour être déclinée en 16 variantes pour PC portables et desktop allant de 9 W à 125 W », se félicite Isic Silas, vice-président du Client Computing Group d’Intel, basé en Israël. Il raconte en clin d’œil « que le siège n’était pas très chaud au début et que nous avons dû nous déplacer aux Etats-Unis pour convaincre les équipes dirigeantes ! ».

À la tête de son équipe israélienne, Isic Silas supervise non seulement le développement des P-Core qui sont cuisinés localement, mais aussi l’intégration de tous les éléments de ce SoC. Faisant de cette génération un nouveau succès made in Israël d’Intel, et aussi l’orgueil de M. Silas : « Avec une architecture peaufinée, nous sommes capables de produire des puces 10 nm supérieures en puissance brute à des puces gravées 5 nm ». Capable d’atteindre 6 GHz, Raptor Lake n’est pas une nouvelle architecture, mais un peaufinage en profondeur de l’existant.

Le gain de 15% de génération à génération s’est fait sur tous les plans : augmentation des fréquences, amélioration de la consommation et du rapport perf/Watt, ajout de nouveaux microcontrôleurs, travail sur le firmware, implémentation d’algorithmes entraînés par apprentissage machine (machine learning) pour améliorer le préchargement des instructions et les comportements des applications, etc. Le tout, sur fond du COVID qui avait déjà affecté le développement d’Alder Lake. Affecté, mais pas ralenti : « au début de la pandémie en février 2020, nous avons converti en seulement quelques jours sept salles de conférences en labos techniques opérationnels afin de continuer à opérer. Sans prendre de risque avec nos employés ».

Un nombre optimal de « gros » cœurs

Quand on lit la fiche technique des processeurs Raptor Lake déjà annoncés, un élément saute aux yeux : si le nombre de cœurs est en hausse, c’est parce qu’Intel est allé jusqu’à doubler le nombre de cœurs basses performances. Sans jamais ajouter un seul cœur hautes performances.

« Nous avons surtout travaillé la partition énergétique de nos puces », expliquent en cœur Ran Berenson et Arik Gihon, des deux « cerveaux » aux commandes du développement des puces. « Une des grosses différences entre la 12e et la 13e génération dont nous sommes fiers est la partie alimentation », expliquent les deux ingénieurs. « Pour la même consommation énergétique, les cœurs développent bien plus de puissance », se félicitent-ils. « La clé de ces progrès était d’améliorer l’énergie consommée par chaque traitement d’instruction. Et quand on regarde dans les détails, on s’aperçoit que la plupart des bonnes applications utilisent uniquement deux ou quatre threads hautes performances. Et les applications qui utilisent beaucoup de threads n’ont pas nécessairement besoin de monter très haut en fréquence », continuent les deux experts.

A lire aussi : Core 13e génération Raptor Lake : comment Intel veut reprendre sa couronne de roi des PC (sept 2022)

On pourrait ici pointer du doigt que les approches d’Intel et AMD varient notamment à cause de la taille très différente de leurs cœurs. Les P-Core hautes performances d’Intel sont vraiment gros, les cœurs d’AMD sont tous de taille moyenne, les E-cœurs d’Intel sont vraiment petits. Ici, chaque approche a ses forces et faiblesses. Si AMD peut déployer plus de « gros » cœurs qu’Intel, les cœurs basse consommation d’Intel lui permettent de composer, avec ses deux cœurs différents, un plus grand nombre de puces. Il lui suffit de panacher ses cœurs selon la puissance – et la consommation énergétique – cible.

x86 n’est pas une faiblesse et se nourrit des autres architectures

Tous les ans, on lit qu’ARM est le futur et que x86 est mort. Intel et AMD ne peuvent évidemment pas être de cet avis, mais pour une fois nous avons eu accès aux ingénieurs à la source de la microarchitecture. Ils ont pu nous répondre sur l’impact négatif que x86 et ses éléments de rétrocompatibilité auraient sur les performances. « Nous nous posons la question à chaque génération », répond posément Adi Yoaz, le directeur de l’architecture Core. « Tout est affaire de puissance par surface de puce. La question étant, est-ce que cette compatibilité nous handicape beaucoup ? Combien devons-nous ‘’payer’’ pour cela ? Selon nos estimations, cela pourrait aller de 5% et jusqu’à 10% de pertes de puissance. Mais en moyenne, c’est généralement plus proche des 5%. Et nous avons plein de techniques pour contourner ces limitations », rassure l’ingénieur. Et son collègue Ran Berenson partage ce point de vue : « Au final, il nous serait plus difficile de nous débarrasser de ces anciennes instructions que de les conserver ».

A lire aussi : Alder Lake, « la plus grosse évolution du x86 depuis dix ans » : Intel dévoile les entrailles des prochains processeurs Core (août 2021)

Quant au rapport que le champion des instructions x86 entretient avec ARM et RISC V, la réalité est qu’elles s’influencent beaucoup les unes les autres. Repoussant gentiment l’idée d’un départ de zéro de x86, Adi Yoaz explique posément que « le monde des semi-conducteurs s’influence. Et sachez que si nous apportons beaucoup aux autres architectures, nous nous inspirons aussi d’elles, comme pour les instructions à taille fixe. Ou pour la taille des registres. Personne n’est en vase clos dans ce monde », assure l’ingénieur.

Une affaire de chimie et de coopération

Interrogé à propos de l’impact des avancées de la chimie et des nodes industriels de miniaturisation dans la conception logique des puces, Adi Yoaz est catégorique « C’est absolument critique. La connexion que nous entretenons avec nos collègues qui travaillent sur la chimie et les matériaux, ainsi que ceux du process (la finesse de fabrication, ndlr) est fondamentale. Tous ces éléments influencent directement les designs des puces », explique-t-il.

Avant d’ajouter que si une poignée d’ingénieurs a dans ses mains la conception du brouillon de la puce, dès que le travail est lancé, le flux de travail est énormément distribué. Non seulement entre les différents spécialistes, mais surtout entre les différents sites d’Intel. « Les nouveaux P-Core ‘’Raptor Cove’’ et le pilotage de l’assemblage du SoC ont été faits ici, en Israël. Mais Intel est une entreprise globale et tout le monde a participé : les E-Core ont été développés à Austin (Texas) et le GPU à Folsom (Californie) », détaille-t-il.

Tick-Tock is back (non, pas le réseau social)

Avant même que vous ingurgitiez des heures de vidéos verticales sur Tik-Tok, le monde des processeurs battait déjà au rythme des Tick et des Tock d’Intel. Une dynamique de lancement de processeurs qui correspondait à une alternance entre le lancement d’une nouvelle architecture (tock) et le passage à une finesse de gravure plus fine (tick). Le passage du 22 nm au 14 nm et l’arrivée de l’architecture Skylake a fait voler cette dynamique en éclat avec de simples « refresh » entre 2015 et 2020. Depuis son arrivée à la tête d’Intel, son nouveau PDG, Pat Gelsinger, (artisan de nombre de processeurs dans les années 80/90) a décidé de renouer avec le modèle tick-tock ou tout du moins avec une plus grande fréquence d’exécution. En allant même jusqu’à engager son entreprise sur cinq améliorations de la finesse de gravure (Intel 7, Intel 4, Intel 3, Intel 20A et Intel 18A) en quatre ans !

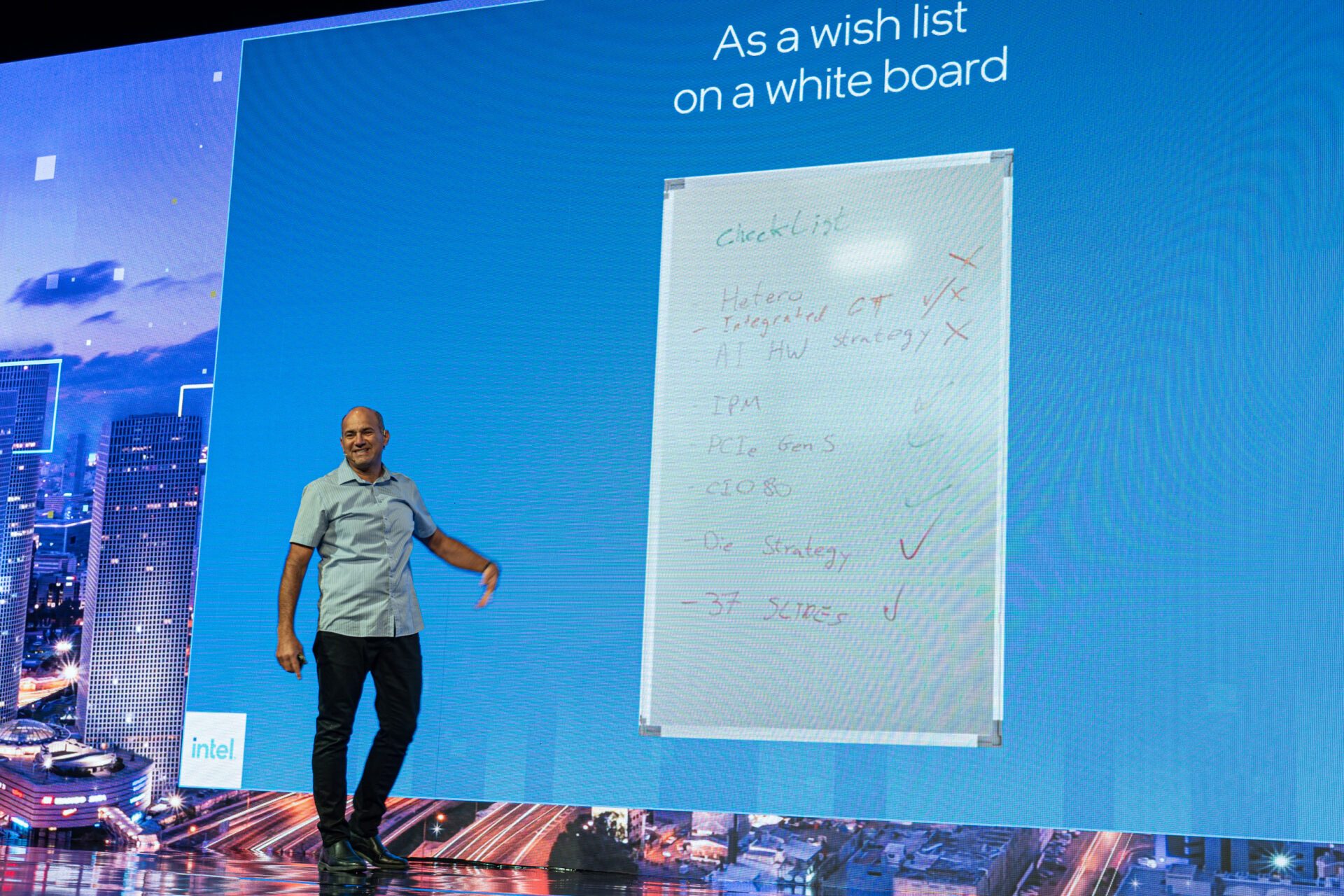

Cette pression de l’accélération des cycles de développement chère à Pat Gelsinger, les équipes de développement la ressentent. Car tout cela prend du temps. « Le cycle de développement d’un produit prend en gros trois ans. Mais pour Raptor Lake, nous avons mis seulement 30 mois », s’enorgueillit Isic Silas. Il parle de l’effet boule de neige qui s’est déroulé les six premiers mois : « Au tout début, il y a dix personnes au maximum sur le projet. Six mois après, ce sont des dizaines de milliers de personnes qui sont impliquées ! ». Un des éléments qui a permis à Raptor Lake d’aller plus vite qu’Alder Lake provient d’un partenaire extérieur : Microsoft. « Quand nous définissons les produits, nous parlons à nos clients et partenaires. Windows 10 ne prenait pas en charge les architectures hétérogènes de cœurs. Nous avons parlé avec Microsoft, qui l’a intégré dans Windows 11 ». L’arrivée de Raptor Lake a donc pu se faire plus rapidement.

Un futur de chiplets (et des défis à surmonter)

Comme AMD avec ses « chiplets », Intel va bientôt assembler des SoC avec des briques hétérogènes – une approche que la société de Santa Clara appelle la disagregation. Une démarche qui vise surtout à limiter la montée du prix des puces liée à l’augmentation des coûts de la miniaturisation. Concrètement, il s’agit d’améliorer des rendements en utilisant de petits morceaux de puces – une très grande puce d’une surface N coûte plus cher à produire que quatre puces occupant la même surface totale.

Intel devrait passer à cette technologie pour la 14e génération « Meteor Lake ». Mais alors que pour les analystes extérieurs, dont nous sommes modestement, cette partition reste la panacée, dans les faits cette fragmentation en plusieurs puces a des limites. « Le premier défi est de trouver l’équilibre parfait entre les éléments », explique Adi Yoaz. « Cela va plus loin que le rapport performances par Watt. C’est un rapport plus complexe perf/énergie/surface/coût. Et s’il y a des avantages à couper des morceaux de puces, il y a aussi des coûts dans les techniques d’assemblage telles que Foveros chez nous », explique l’ingénieur. Il considère cependant bien que la technologie représente une pièce du futur des puces. Au même titre que « l’ajout d’accélérateurs, que ce soit pour la vidéo, la blockchain, le chiffrement, etc. ». Dans un contexte où Intel est à la chasse aux optimisations, les ingénieurs d’Intel n’ont donc pas fini de se retrousser les manches pour en mettre toujours plus dans leurs puces. Pour aller plus vite. Toujours plus vite.