Et si, en matière d’intelligence artificielle générative, l’événement le plus important n’était pas la sortie, en novembre 2022, de la désormais célèbre machine parlante de l’entreprise américaine OpenAI, ChatGPT ? En tout cas, ce qui s’est passé le 24 février secoue tout autant la planète informatique. Ce jour-là, Meta, société mère de Facebook, annonçait la sortie d’un drôle d’animal, baptisé « LLaMA ». Comme GPT-3, l’une des briques avec lesquelles est bâti ChatGPT, ce programme est un modèle de langue, c’est-à-dire qu’il est capable de générer des phrases sensées, de répondre à des questions, de traduire, de résumer des textes…

Deux « détails » font qu’en quelques semaines un tas d’autres camélidés numériques sont sortis, tirant la langue à ChatGPT, c’est-à-dire faisant aussi bien que lui : Vicuna, Alpaca, Vigogne, Dromadary… D’abord, LLaMA occupe moins de mémoire, il est plus « petit » que GPT-3, entre 2,6 et 26 fois, selon les versions, pour des performances comparables, voire meilleures.

D’autre part, il est open source. Meta a, en effet, publié les détails de la recette de son algorithme, mais aussi, sous conditions, les quantités précises d’ingrédients à utiliser, sans lesquels la recette ne sert pas à grand-chose. Les modèles de langues appartiennent, en effet, à la catégorie de l’apprentissage machine. Les détails de leurs paramètres sont ajustés en fonction d’une tâche très répétitive consistant à prévoir le mot suivant dans une phrase. Cette phase d’entraînement aboutit, comme le ferait un tireur d’élite modifiant sa mire, à l’ajustement non pas d’un ou de deux paramètres mais de milliards, les fameuses quantités d’ingrédients pour la recette.

OpenAI garde jalousement ces informations appelées « poids » de ses GPT-3 et 4. Tout comme Apple, Amazon ou Google. Meta les réservait seulement à des fins de recherche. Mais, dès le 3 mars, une semaine après l’annonce de LLaMA, ses poids se retrouvent en ligne sur un forum et déclenchent un engouement hors norme. L’entreprise Hugging Face recense désormais plus d’une trentaine de dérivés des différentes versions du modèle de Meta, mais aussi d’autres comme ceux de l’association EleutherAI, GPT-J, ou du Technology Innovation Institute des Emirats arabes unis, Falcon.

Moins gourmands en calcul

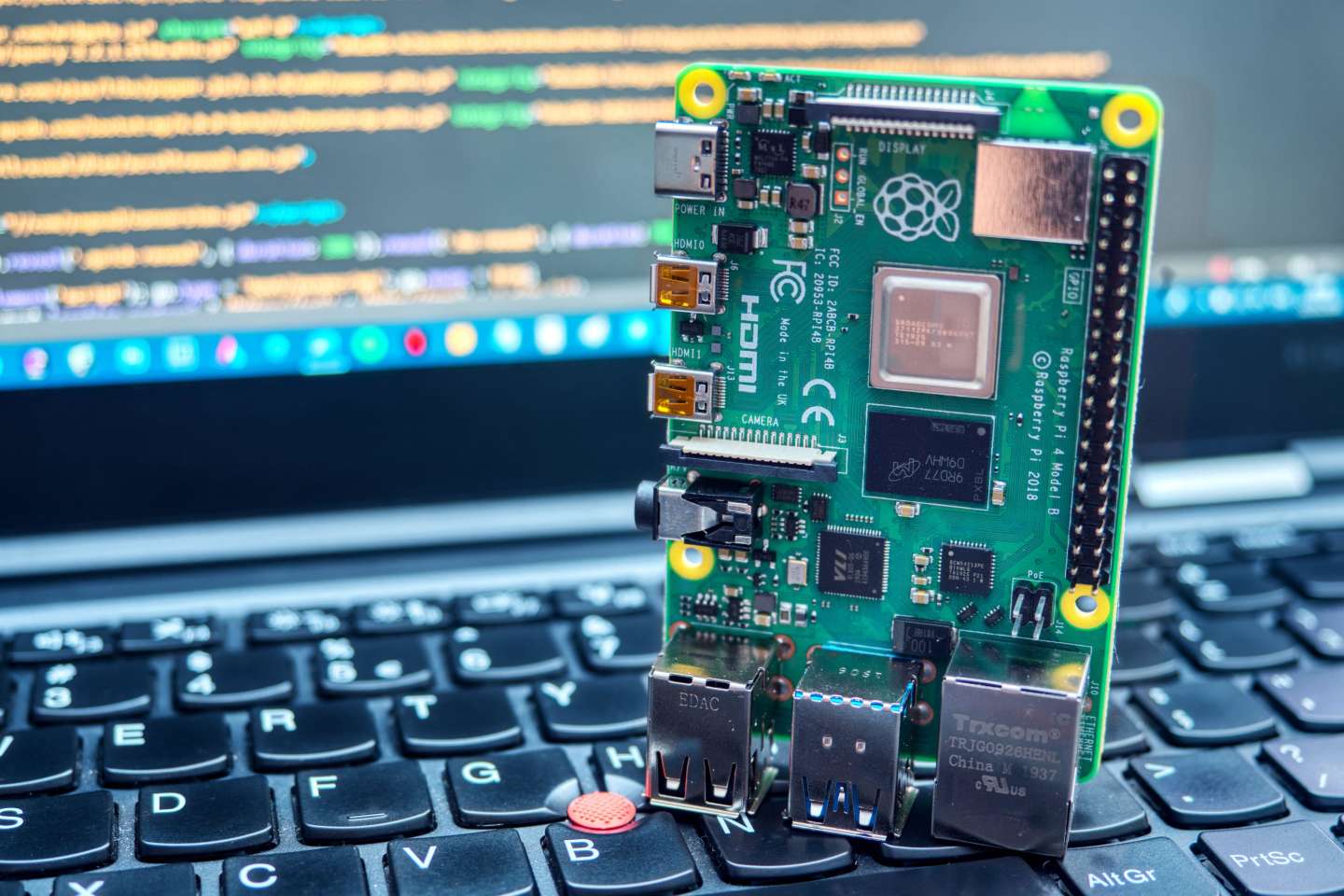

Or la taille change tout ou presque. Plus « petits », avec quelques milliards de paramètres contre plusieurs centaines de milliards, ces programmes sont moins gourmands en calcul pour les utiliser. Un informaticien, Artem Andreenko, a même fait des démonstrations dès le 12 mars sur un ordinateur RaspberryPi, microscopique machine, vedette des bricoleurs. Plus utile, l’entreprise Nomic propose aussitôt un logiciel, Gpt4All, qui permet d’installer plusieurs des modèles dérivés de Llama sur son ordinateur de bureau. Cette capacité à exécuter hors ligne le programme lève les réticences à utiliser les agents conversationnels, aujourd’hui essentiellement en ligne.

Il vous reste 62.99% de cet article à lire. La suite est réservée aux abonnés.