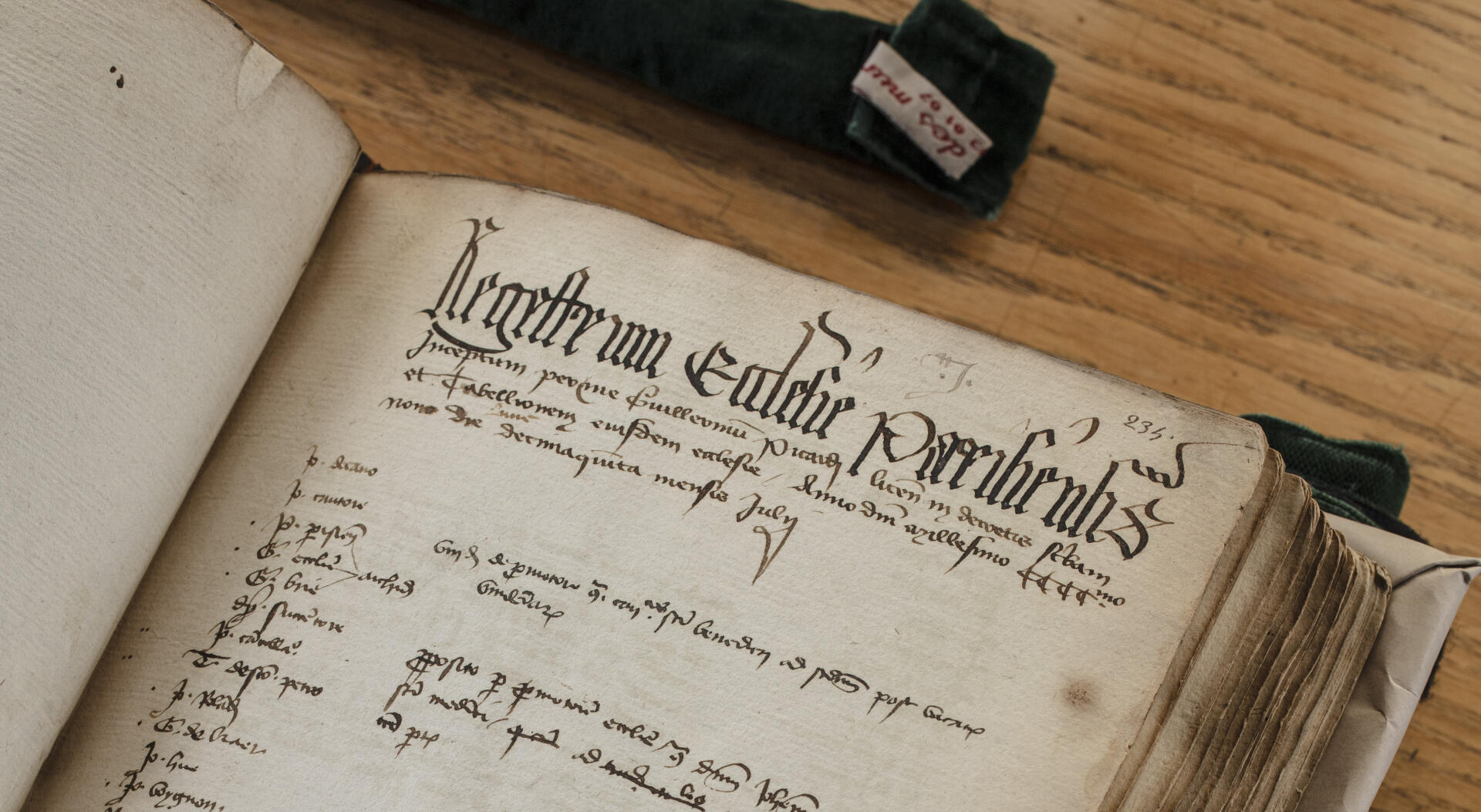

« Registre de l’église de Paris, commencé par moi, Guillaume Picard, licencié en droit, scribe et tabellion de ladite église. L’an du seigneur 1409, jeudi 15 juillet. » Il y a quelque chose d’émouvant à regarder, précautionneusement ouvert sur une table des Archives nationales, les empattements gothiques sur l’épais manuscrit tenu il y a six siècles par ce chanoine de Notre-Dame. Cela ressemble, en latin, à une compilation de comptes rendus de séances telles qu’on les tiendrait aujourd’hui. Avec le détail des décisions prises et la liste des chanoines émargeant pour ces « conseils d’administration du chapitre », selon les termes amusés de l’historien Darwin Smith.

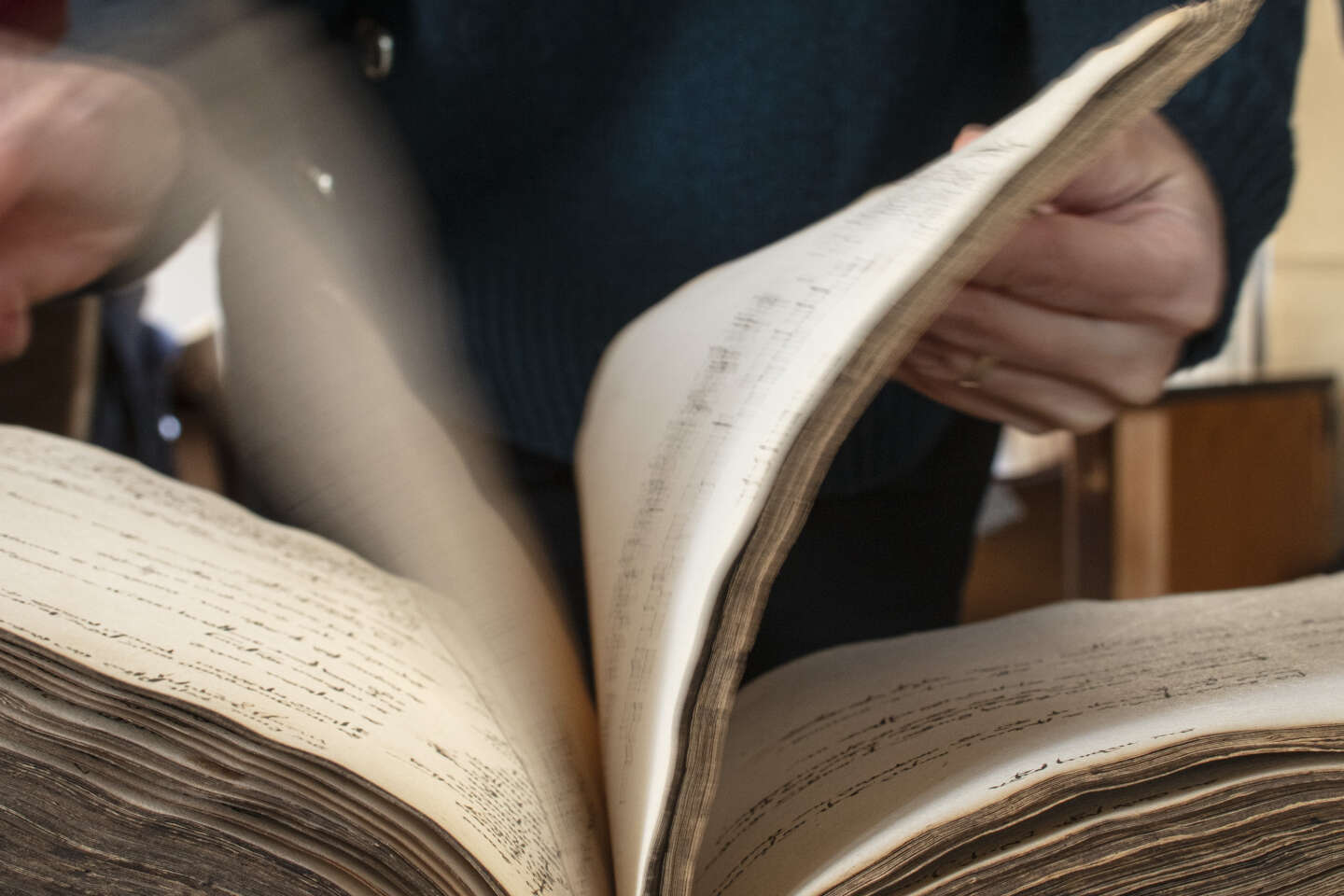

Au total, 170 volumes d’actes ont ainsi été récupérés après la Révolution, en 1790, par les Archives nationales. Une mine pour la recherche. Seulement, déchiffrer pattes de mouche, abréviations, papier ou parchemin taché relevait jusqu’ici d’un travail chronophage pour paléographe. En remettant Notre-Dame de Paris sous la lumière des projecteurs, l’incendie d’avril 2019 a changé la donne et offert aux historiens un saut spatio-temporel : un programme d’intelligence artificielle est aujourd’hui capable de déchiffrer ces actes avec un taux d’exactitude variant de 88 % à 94 % selon les registres, affirment les concepteurs.

Coordonné au Laboratoire de médiévistique occidentale de Paris (LaMOP) de la Sorbonne par Julie Claustre (aujourd’hui professeure des universités à Paris-Cité) et Darwin Smith, directeur de recherche émérite, le projet appelé « e-NDP » s’est pour l’instant concentré sur les vingt-six premiers volumes, dont les 14 600 pages courent de 1326 à 1504, soit la période médiévale au sens classique du terme.

Première étape de ce programme expérimental, restaurer. Taches, humidité, usure du temps… Huit volumes ont nécessité d’être repris. Deuxième étape, numériser. Enfin, il a fallu « entraîner » la machine, selon des techniques désormais classiques de HTR (handwritten text recognition, « décryptage de texte manuscrit »), mais adaptées à ces textes proprement dits. Parce que l’écriture change au fil du temps, selon les chanoines et les époques.

Obtenir un algorithme fiable

Au début, on sent que les notes sont prises pendant les réunions. Ensuite les comptes rendus sont clairement recopiés au propre, plus réguliers, sans ratures. Isoler physiquement les différentes parties de chaque page, faire le tri visuel entre les listes de chanoines, les textes juxtaposés et les annotations dans la marge. Il a fallu s’y reprendre à huit fois, avec une quinzaine d’historiens pour vérifier les résultats obtenus sur différents extraits, afin de corriger le tir (on dit fine tuner en langage d’expert) et obtenir un algorithme suffisamment fiable. Résultat : « Cinq millions de mots dans lesquels on peut faire de la fouille structurée. C’est prodigieux !, s’enthousiasme Julie Claustre. Désormais, on sait que ça fonctionne, on peut suivre des personnes, des fonctions. On peut aussi aller chercher de façon précise sur un mot ou un thème. »

Il vous reste 65% de cet article à lire. La suite est réservée aux abonnés.