Et si la révolution quantique arrivait plus vite qu’on ne soupçonne ? Alors que des poids lourds de l’électronique comme Intel, à qui nous avons récemment parlé, prennent gants et pincettes en faisant bien attention de tout mettre au conditionnel, il est un acteur qui semble ne jamais douter : IBM. La preuve : tout récemment, le géant américain annonçait avoir vendu le premier ordinateur quantique entièrement dédié à la rechercher médicale. Loin d’être une vente sur étagère – les ordinateurs quantiques ne sont pas encore en passe de devenir des produits de série – il s’agit surtout, entre la Cleveland Clinic et IBM d’un partenariat scientifique. Une deal où les différents corps de métiers de la médecine vont pouvoir penser, concevoir et utiliser des logiciels utilisant la puissance (promise !) de la machine quantique. Mais, après la première vente de machine à un institut de recherche allemand en 2021, cette seconde vente est encore plus proche du premier pas de cette technologie dans le monde “réel”.

Ce qu’il y a d’étonnant dans la stratégie d’IBM, c’est le côté « force tranquille implacable ». Depuis plusieurs années maintenant, IBM publie et met à jour sa feuille de route technique, et n’a pas une seule fois failli à un lancement produit. Ponte de la division quantique d’IBM, Jay Gambetta incarne parfaitement cette feuille de route. L’homme est doux, agréable, presque timide – notamment face à l’appareil photo qui va lui tirer le portrait ! – mais il se montre rapidement plus volubile et assuré dès qu’on lui oppose les doutes de ses concurrents. Car si le scientifique reconnaît que le chemin reste pavé de difficultés, le confronter aux points de vue des concurrents lui fait se redresser imperceptiblement. Toujours calme, l’homme est alors plus droit, son ton toujours aussi posé mais le débit s’accélère et le regard est plus intense. IBM est sûr de lui, et Jay Gambetta aussi.

Changer de méthode pour avancer plus vite

« En 2016, j’en avais assez d’entendre mes collègues se demander s’ils pouvaient expérimenter telle ou telle chose », explique l’homme posément. « Ce qui manquait à la mise en œuvre plus rapide de l’ordinateur quantique c’était la méthode : d’abord on publiait [des articles scientifiques, NDLR], puis on implémentait. C’était une mauvaise façon de faire. Nous avons donc changé notre fusil d’épaule. Et plutôt que de rester focalisés sur le nombre de qubits, nous sommes passés à l’identification du matériel et des technologies dont nous aurions besoin pour avancer dans tous les autres domaines. Et nous avons commencé à les développer », continue-t-il.

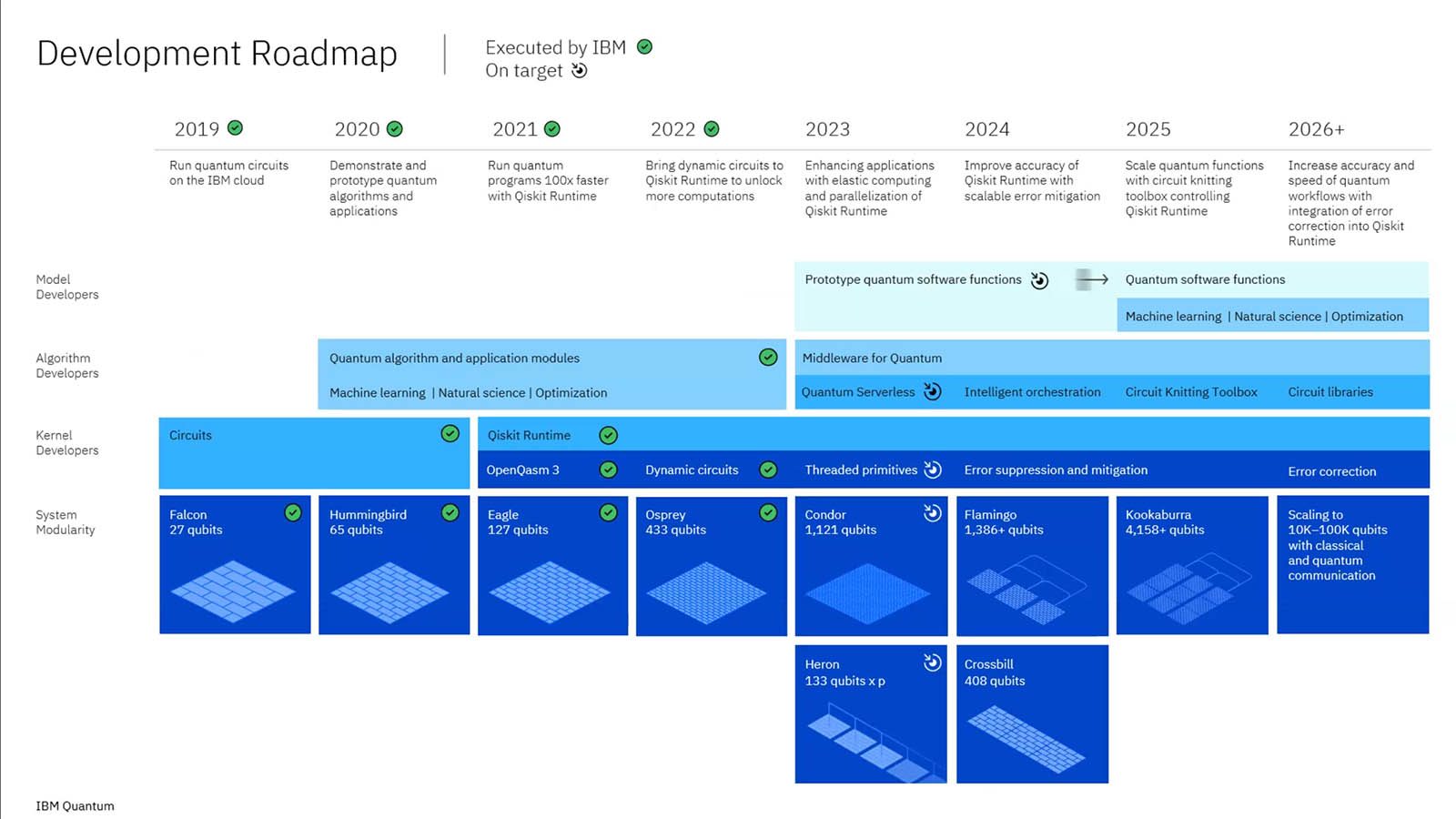

La démarche semble, sur le papier, simple : un problème, une technologie, une implémentation concrète. Pour construire et lancer la machine, néanmoins, « chaque challenge nécessitait le développement d’une technologie et nous en avons fait un processeur différent. Le multiplexage ? C’était Humming bird. Le multiwiring ? C’était Eagle. Et avec à chaque fois des nouveaux processeurs qui implémentent des développements qui ont lieu en parallèle ». Pour Jay Gambetta, cette approche fut décisive. Car elle a permis à IBM de tenir son calendrier. Une chose nouvelle, voire assez épatante, pour un champ de travail aussi proche de la science fondamentale.

Une feuille de route (jusqu’ici) sans failles

L’ordinateur quantique est une technologie intangible pour le grand public. Alors que la technique nous échappe à cause de sa trop grande complexité technique et physique, le « quand » est LA question qui anime tous les spectateurs de cette technologie. Et IBM semble être le seul acteur à avoir un calendrier clair grâce à une réussite majeure : ces dernières années, les ingénieurs de l’entreprise ont joué la partition de leur feuille de route sans aucune fausse note. « Jusqu’ici nous avons très bien réussi », se félicite J. Gambetta.

Une réussite qu’il impute autant à la manière de procéder aux développements qu’au patrimoine de l’entreprise. « Les gars de l’équipe d’IBM semi [la division semiconducteurs d’IBM, NDLR] m’ont beaucoup influencé dans mon travail », explique-t-il. Et ces « gars » sont loin d’être des manchots. Si IBM a laissé à d’autres le développement même des processeurs ou encore la production en volume, l’Américain reste le roi de la R&D sur la miniaturisation des circuits. Oui, si TSMC et Samsung gravent leur puces en 3 nm, c’est grâce à des brevets et des ingénieurs d’IBM. Lesquels faisaient déjà la démonstration du 2 nm en 2021 !

A lire aussi : IBM grave la première puce en 2 nm de l’histoire… et Intel pourrait bien en profiter (mai 2021)

Ensuite, il y a l’organisation même de l’unité quantique qui permet d’avancer vite. « Le monde du quantique est encore bien moins spécialisé que celui des semi-conducteurs classiques où recherche, développement et production sont très séparés. Dans le quantique, ces trois domaines fonctionnent encore de concert ».

Pour IBM, les supraconducteurs ont l’avantage

IBM semble ne rien faire comme les autres. Sa feuille de route est hyper précise et ambitieuse, l’entreprise veut tout faire seule quand le reste de la compétition se focalise sur des éléments spécifiques. Et surtout, l’Américain base toujours ses processeurs sur les matériaux supraconducteurs alors que le reste de l’industrie se tourne de plus en plus vers le spin. Et prend le contre-pied en assurant que son choix est le plus moderne.

« Dans les applications quantiques, les technologies à base de spin sont bien arrivées après. Mais en fait, quand on compare le silicium et les supraconducteurs, c’est cette dernière technologie qui est la plus récente, la plus moderne : le silicium est là depuis des décennies ! ». Et pour IBM c’est bien le supraconducteur qui aura l’avantage. « Dans mon équipe, il a des gens qui viennent initialement du monde du spin. Et ce n’est pas pour rien qu’ils ont rejoint notre équipe », assure Jay Gambetta.

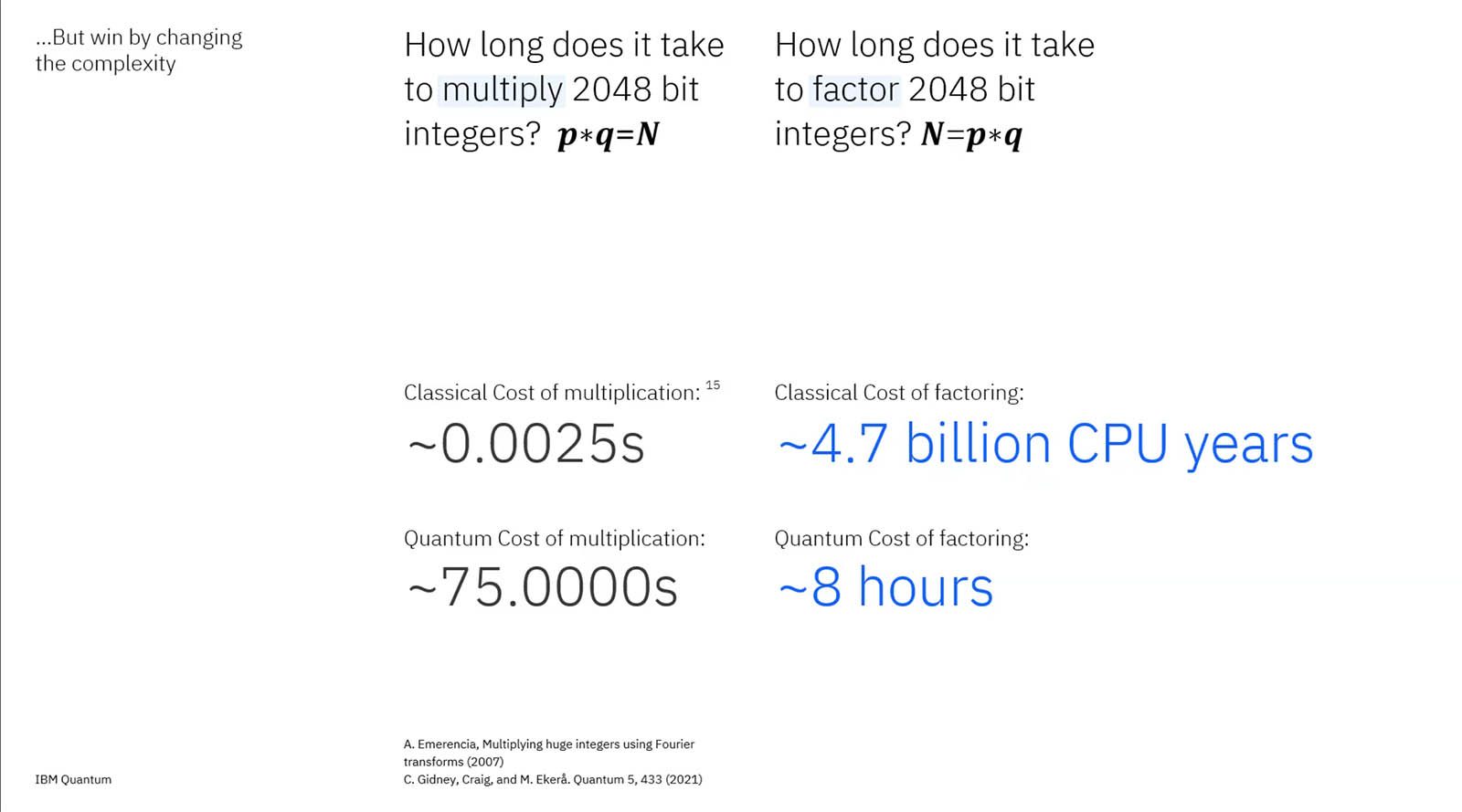

« Il faut identifier les bonnes technologies et vérifier qu’elles répondent bien à trois critères : la montée en volume (scaling), la qualité des qubits et la vitesse. Le silicium répond bien au premier critère, c’est ce pourquoi le reste de l’industrie s’en empare. Mais la vitesse reste à démontrer et en matière de qualité, ce n’est pas du tout ça. C’est d’ailleurs pour cela que la plupart des acteurs qui se concentrent dessus affichent des besoins de centaines de milliers voire de millions de qubits avant d’être efficace », assure le chercheur. Car il faut savoir que cette histoire de « qualité » d’un qubit est absolument fondamentale pour les calculs : plus vous agrégez de qubits pour développer de puissance, plus ce « château de cartes » a de risque de s’effondrer. Et avec lui, le résultat de votre calcul.

IBM a fait un choix de technologie mais aussi d’organisation spatiale de ses circuits. Quand les autres jouent la carte du silicium classique en deux dimensions, IBM conçoit ses puces en trois dimensions, et met en avant l’importance temporelle dans les calculs. « Ce qui compte pour un ordinateur quantique c’est non seulement le nombre de qubits, mais aussi la longueur des instructions mémoire. En simplifié, l’un représente l’espace et l’autre le temps. » En gros : au lieu d’avoir des millions de qubits qui s’expriment de manière stable pendant une fraction de seconde, le calcul quantique déploie mieux sa puissance quand les qubits sont organisés en couches capables de maintenir le calcul le plus longtemps possible en mémoire sans faire d’erreur. Dans ce domaine, Jay Gambetta est sûr qu’IBM a de l’avance. « Seul les qubits à base de supraconducteurs permettent cela. Et nos codes de mitigation et de correction d’erreur sont les meilleurs ». Tellement bons, que chez IBM, ça fleure bon la révolution… qui ne se fera pas sans aide extérieure.

Les scientifiques des autres disciplines doivent s’impliquer

IBM conçoit les processeurs, les machines, les différentes couches logicielles, développe sa solution comme un service cloud et signe déjà les premiers contrats. Pourtant, aussi puissant le géant soit-il, il reste impuissant pour assurer une chose : rendre la machine vraiment utile. Son fonctionnement fondamentalement différent oblige à tout revoir, tout repenser notamment les logiciels et algorithmiques. Des domaines pour lesquels IBM a besoin de spécialistes.

Et par spécialistes, on parle ici non pas des différents corps de métier impliqués dans la construction de la machine quantique elle-même. Mais de scientifiques des différents champs de la science « Notre problème à l’heure actuelle est que le quantique a besoin de l’apport des scientifiques de chaque domaine. Des experts en biologie, en chimie ou en physique des hautes énergies qui réalisent une cartographie de leurs problèmes. Le travail à réaliser est de créer, traduire et adapter des algorithmes du monde classique pour des circuits quantiques », explique J Gambetta.

A lire aussi : IBM a mis 20 ans à nous protéger d’une menace quantique qui n’existe pas encore (juillet 2022)

Le scientifique s’empresse d’ajouter que « l’ordinateur quantique, seul, n’arrivera à rien. En plus de la réécriture voire de la réinvention d’un monde logiciel, il va aussi falloir savoir intégrer le processeur quantique (QPU) dans un circuit de calcul plus global. Car pour certains problèmes, l’ordinateur quantique est complètement nul. Il aura toujours besoin des CPU et GPU pour de nombreux calculs. » Ne serait-ce pour que nous puissions exploiter les résultats de calculs qui sont, à l’échelle atomique, plus une forme de probabilité magique à déchiffrer que les résultats catégoriques que nous donnent aujourd’hui nos processeurs binaires. « Là aussi, il s’agit d’un énorme chantier : il va falloir que toute l’industrie apprenne à découper les problèmes en sous-problèmes où les calculs seront effectués par les bons composants ». La tâche semble titanesque pour le néophyte que nous sommes. Pourtant, Jay Gambetta est tranquille, jamais arrogant, jamais dans le prêche. Son regard est intensément braqué sur un horizon clair. Et proche : 2024.

2024, l’année de la révélation ?

L’ordinateur quantique ne devrait jamais devenir un produit de masse. Il sera un super outil acheté (ou loué) à la fois par les grands centres de données ou par des supers clients. Le grand public et les TPE/PME pourraient l’utiliser dans le futur, sans doute de manière indirecte, via le cloud. IBM a donc moins besoin de convaincre le grand public de son utilité que ses clients « corporate ». Des clients qui sont, pour l’Américain, les vrais héros que l’entreprise compte mettre en avant.

A lire aussi : IBM promet les premiers supercalculateurs quantiques commerciaux pour 2025 (mai 2022)

« En 2024 nous pensons atteindre les 100 qubits sur 100 couches – le fameux 100×100. Un niveau de puissance de calcul tel qu’aucun supercalculateur classique ne pourra simuler les résultats. Mais nous ne serons pas au cœur des annonces. Nous espérons que cette grande étape sera mise en lumière par nos partenaires. Que ce soit dans les domaines de la chimie ou de la physique, ce sont les spécialistes de ces domaines qui auront des annonces à faire au travers de la puissance de notre solution quantique », promet J. Gambetta.

Mais quelle foi donner à de telles promesses ? Surtout que l’Américain a derrière lui des échecs. En février dernier, nous interrogions les dirigeants de Huawei France qui nous avouaient respecter IBM pour sa recherche et son esprit visionnaire. Tout en critiquant vertement son exécution ! Confronté à cette remarque, Jay Gambetta ne cède pas un pouce. « L’exécution, c’est au contraire l’obsession de notre PDG. Et je crois que entre le respect de notre feuille de route passée et la clarté de nos plans pour le futur, nos réussites parlent pour nous », lâche posément le scientifique. Ajoutant que « d’autres annonces arrivent déjà dans le courant de l’année ». Toujours tranquille, toujours calme, mais diablement assuré.