L’architecture Hopper a marqué un tournant pour Nvidia en lui permettant de devenir l’un des acteurs dominants de l’essor rapide des intelligences artificielles et de la révolution de l’IA générative.

Le GPU H100 s’est imposé comme une référence et est commandé par dizaines de milliers d’unités, malgré son tarif élevé, par tous les grands groupes high-tech s’intéressant de près ou de loin à l’IA.

Forte de ce succès qui a permis une progression vertigineuse de ses revenus et une valorisation qui a dépassé les 2000 milliards de dollars en début d’année, Nvidia ne s’arrête pas en si bon chemin et profite de son événement GTC 2024 pour dévoiler sa nouvelle architecture Blackwell et un premier GPU B200 qui promet d’aller encore plus loin en matière de performances, ainsi qu’un GPU B100 représenté par un seul die.

GPU B200 Blackwell, le passage au dual die

Comme précédemment, l’architecture Blackwell est d’abord présentée sous l’angle professionnel et les usages en datacenters avant d’être adaptée plus tard (fin 2024 ou début 2025) aux besoins des cartes graphiques gaming.

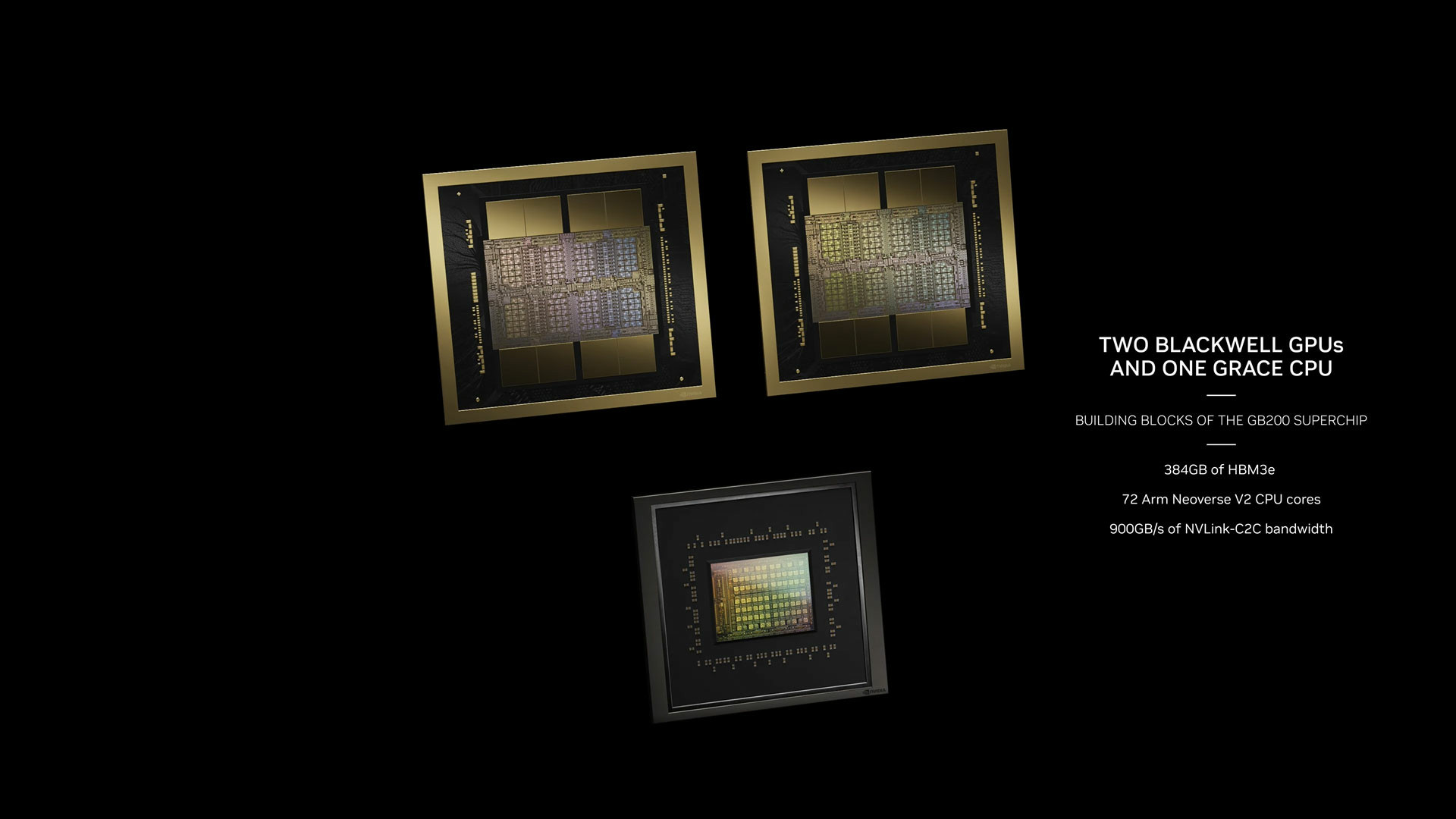

Cette première apparition officielle de l’architecture Blackwell et du GPU B200 a donc tout à voir avec l’intelligence artificielle. Le nouveau GPU combine 208 milliards de transistors, soit beaucoup plus que les 80 milliards du GPU H100 mais avec une astuce : là où H100 (et H200) était monolithique, B200 est constitué de deux dies rassemblés par un lien d’interconnexion, une première pour ce type de produit.

Le nouveau GPU est gravé en 4 nm chez TSMC selon un procédé 4NP pas si différent du procédé 4N utilisé pour Ada Lovelace et qui explique sans doute la nécessité d’augmenter fortement le nombre de transistors pour améliorer les peformances.

On pensait que Blackwell serait l’occasion pour Nvidia de basculer sur la gravure en 3 nm mais ce n’est finalement pas le cas, au moins pour cette génération de GPU présentée avec le lancement de la nouvelle architecture.

Jusqu’à 20 petaflops en FP4

Or, explique Tom’s Hardware, le GPU H100 occupait déjà presque toute la surface possible pour fabriquer une puce en 4 nm. Pour B200, la seule solution était donc de produire deux puces et de les lier ensemble.

Chaque die du GPU B200 intègre 4 modules mémoire HBM3e de 24 Go, assurant une bande passante de 1 To/s chacun avec un bus mémoire 1024-bit. Nvidia revendique pour son nouveau GPU Blackwell une capacité de traitement de 20 petaflops mais en passant par un nouveau format FP4 que ne possède pas H100 et permis par l’arrivée d’une deuxième génération de Transformer Engine sur Blackwell.

Sur la même précision FP8 que le H100, la capacité de traitement est ramenée à 10 petaflops, soit 2,5 fois mieux que les 4 pétaflops de ce dernier…mais avec 2 puces au lieu d’une.

Grace Blackwell, la nouvelle superpuce ARM

Il faudra compter 700W pour faire fonctionner un GPU B100 et 1000W pour un GPU B200. La rumeur du seuil des 1000W était donc avérée et il faudra de solides solutions de refroidissement pour les accompagner.

Toute cette puissance de traitement supérieure pourra être utilisée pour alimenter de grands modèles de langage (LLM) et des modèles fondateurs d’IA de grande taille, ce qui ne fera sans doute pas les affaires de leur impact environnemental, sujet sur lequel tout le monde reste très discret. Il ne faudrait pas gâcher la fête.

Nvidia annonce en parallèle une superpuce Grace Blackwell GB200 combinant un CPU ARM Grace et deux GPU B200 en remplacement de Grace Hopper et qui est annoncée avec un TDP de 2700W, ainsi qu’un système HGX B200 pouvant accueillir 8 GPU B200 Blackwell associés à un CPU x86 et le système DGX B200 avec 8 GPU B200 et 2 processeurs Intel Xeon taillé pour gérer une IA en entreprise et extensible en DGX SuperPOD pour en faire un supercalculateur.