Après quelques minutes en immersion dans Echo VR, un jeu de sport en réalité virtuelle, on entend notre première insulte. Dans la salle d’accueil, destinée aux personnes n’ayant pas encore lancé de partie, un joueur hurle sur un autre au micro. Il lui suggère, d’abord, de lui « sucer l’anus », avant d’enchaîner sur des injures racistes. Notre guide, un habitué d’Echo VR, nous le promet : d’habitude, ce n’est pas si terrible. De notre côté, on a du mal à déterminer s’il s’agit d’une plaisanterie entre copains ou si l’on vient d’assister à une véritable agression.

En octobre 2021, Mark Zuckerberg, fondateur et PDG de Facebook, a annoncé que le but de son entreprise, rebaptisée pour l’occasion Meta (en grec ancien, « au-delà de, après »), serait désormais de créer un « métavers », un monde immersif et persistant dans lequel les internautes, équipés de casques de réalité virtuelle, pourraient évoluer grâce à des avatars en 3D. Une annonce qui a aussi mis en lumière les projets d’autres plates-formes, développant déjà leurs propres « métavers ».

Elle a également relancé une crainte : celle des agressions, notamment sexuelles, en réalité virtuelle. Andrew Bosworth, directeur technique de Meta, reconnaît lui-même que le harcèlement dans un métavers est « une menace existentielle » pour les ambitions de son entreprise, d’après un mémo confidentiel révélé en novembre par le Financial Times. Il a aussi admis qu’une modération à grande échelle était « pratiquement impossible ».

« Le choc est le même que dans la vraie vie »

Ces questions ne sont, pourtant, pas neuves. Les exemples d’agression sexuelle dans des mondes immersifs, qu’il s’agisse ou non d’expériences en réalité virtuelle, sont nombreux. En 2016, une utilisatrice du jeu de tir QuiVR racontait dans un post de blog avoir subi des attouchements à la poitrine par un autre joueur. Et dès 1993, un article du journaliste américain Julian Dibbel, « A Rape in Cyberspace » (« Un viol dans le cyberespace »), décrivait comment un membre d’un « MOO » (Multi-user dimension Object Oriented), une communauté en ligne reposant sur des échanges textuels, avait forcé d’autres joueurs et joueuses à des simulations d’actes sexuels.

Plus largement, d’après une récente étude de l’institut Ipsos, 41 % des Français (et 81 % des 18-24 ans) ont déjà été victimes de violence en ligne. « En un sens, le harcèlement dans les métavers est motivé par les mêmes facteurs que celui qu’on constate sur d’autres plates-formes : on se sent déconnecté des conséquences de nos actions, explique Katherine Cross, chercheuse américaine en sciences de l’information à l’université de Washington, spécialisée dans le harcèlement en ligne. Mais il existe une différence fondamentale, qui peut rendre cette expérience bien pire : la réalité virtuelle est conçue pour nous faire croire que ce que nous vivons est vrai. »

La réalité virtuelle, par sa nature immersive, rend la présence des autres joueurs étonnamment tangible, et parfois intimidante, selon les situations. Ce sentiment peut être aggravé selon l’attachement que l’on ressent à l’égard de son avatar, souvent censé nous représenter. On a beau savoir que l’univers est factice, l’émotion ressentie, elle, peut être bien réelle. Ainsi, les victimes d’agressions sexuelles dans des métavers témoignent de leur malaise, voire d’un traumatisme. « Le choc que j’ai ressenti était similaire à celui d’autres agressions que j’ai subies dans la vraie vie », racontait l’une d’entre elles au Guardian en 2016.

Modérer des gestes

La modération des métavers est au carrefour d’enjeux divers. Les défis ne sont pas les mêmes dans les zones publiques – comme les salons d’accueil – que dans des communautés fermées, qui disposent souvent de modérateurs volontaires. Et, au contrôle du contenu produit par les internautes (textes ou images, comme sur un réseau social classique), s’ajoute celui des discussions tenues à l’oral et des comportements physiques. « Dans un métavers, la toxicité prend plein de formes différentes. Il y a le sujet de la voix. Comment repérer une insulte ? Ou si une personne très jeune discute avec d’autres plus âgées ? », détaille Charles Cohen, PDG de Bodyguard, entreprise française spécialisée dans les outils automatiques de modération pour les particuliers et les entreprises. « Et puis, il y a les gestes. Si un avatar en suit un autre, est-ce par jeu, ou s’agit-il de harcèlement ? »

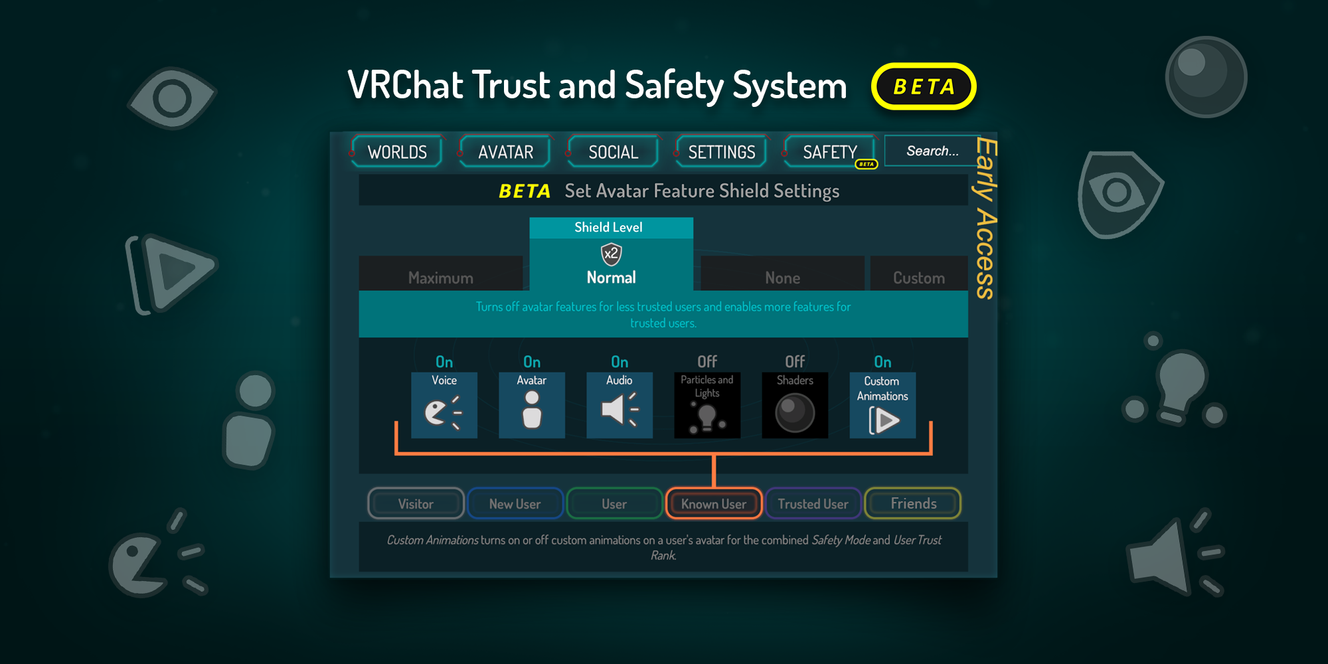

A défaut de pouvoir contrôler ce genre d’attitudes en direct, la plupart des plates-formes proposent une panoplie d’outils pour améliorer l’expérience des internautes : activer une frontière invisible autour de son corps virtuel, moduler la tessiture de sa voix (si une femme veut se faire passer pour un homme), réduire les autres avatars à des petites boules flottantes… On peut aussi signaler les actions problématiques, comme sur un réseau social, mais encore faut-il avoir enregistré une vidéo à apporter comme preuve.

L’autre sujet crucial est celui du design. Comment construit-on un univers virtuel qui empêcherait les abus en amont ? Des métavers proposent des avatars sans jambes (évitant ainsi des postures sexuelles), proscrivent certains gestes avec les mains virtuelles (sur la version de base de VRChat, on peut lever son pouce en l’air, mais pas son majeur), prévoient des zones où un avatar devient aussitôt invisible aux yeux des autres, que ce soit pour se protéger ou faire une pause.

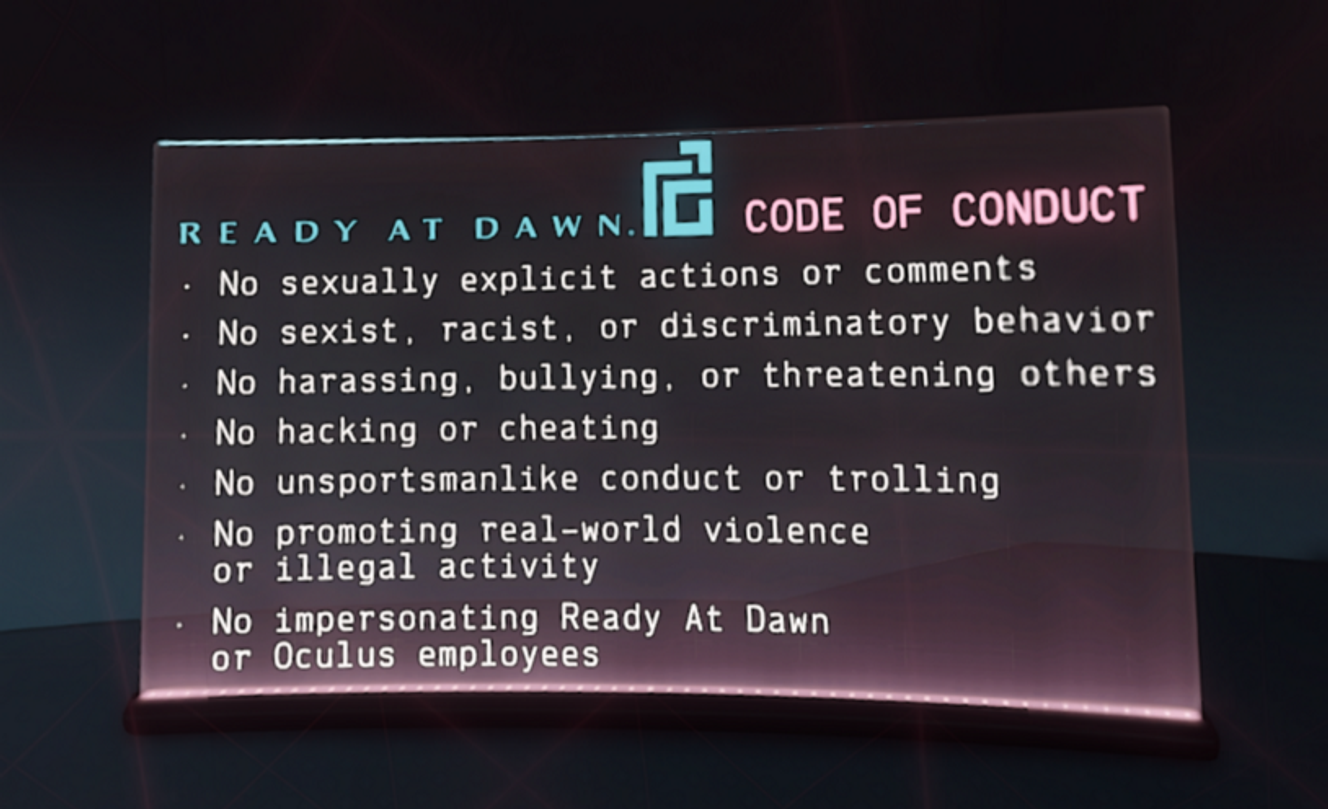

Beaucoup de mondes virtuels choisissent aussi de rappeler leurs règles de manière peu subtile, au travers de posters ou d’avertissements qui s’affichent pendant les temps de chargement. Comme si, en marchant dans la rue, des panneaux nous rappelaient sans cesse qu’il est interdit de gifler autrui.

Qui est responsable ?

« Dans n’importe quel environnement ou jeu, il y a des règles explicites et implicites », explique Martin Buthaud, doctorant en philosophie à l’université de Rouen (laboratoire Equipe de recherche interdisciplinaire sur les aires culturelles), qui travaille sur les métavers. « Cela vaut aussi pour les métavers. Est-ce qu’on veut expliciter toutes les règles sous-jacentes et bâtir des mondes aux allures autoritaires ? Ou est-ce que l’on part du principe que les internautes savent déjà comment se comporter, au risque d’avoir des problèmes ? C’est un équilibre délicat. »

Comme en témoigne l’exemple de cette testeuse d’Horizon Worlds, dévoilé dans la presse fin 2021, qui a été victime d’un attouchement sexuel par un autre avatar. Au moment de son agression, elle n’a pas su déployer la « safe zone », une fonctionnalité qui permet en théorie à un utilisateur de disparaître aux yeux des autres.

Cette situation démontre que les plates-formes ne peuvent pas toujours se décharger de leurs responsabilités sur les internautes. Elle pose aussi des questions complexes : comment répartir les torts entre l’agresseur, qui s’est mal comporté, et la plate-forme, dont les outils n’ont pas protégé ? Doit-on faire évoluer les lois encadrant la haine en ligne et les responsabilités des réseaux sociaux pour prendre en compte la dimension physique de l’agression d’un avatar virtuel ? Et surtout, comment éduquer les joueurs en amont, pour qu’ils cessent ces violences ?

La modération est, depuis longtemps, une épine dans le pied des grandes entreprises du Web, accusées de ne pas assez investir pour la sécurité des internautes, et d’avoir conçu des plates-formes impossibles à contrôler. Les métavers, parfois décrits comme notre futur en ligne, pourraient-ils être l’occasion de faire les choses correctement, dès le commencement ? Ou, au contraire, est-on déjà en train de reproduire les erreurs du passé ? « La modération est souvent utilisée comme un pansement pour régler les problèmes structurels des plates-formes, regrette Katherine Cross. On doit construire des métavers qui prennent en compte les abus potentiels dès la première ligne de code. Mais, pour des grosses entreprises comme Meta, malheureusement, la modération restera probablement un sujet auquel on réfléchira après coup. Comme cela a toujours été. »