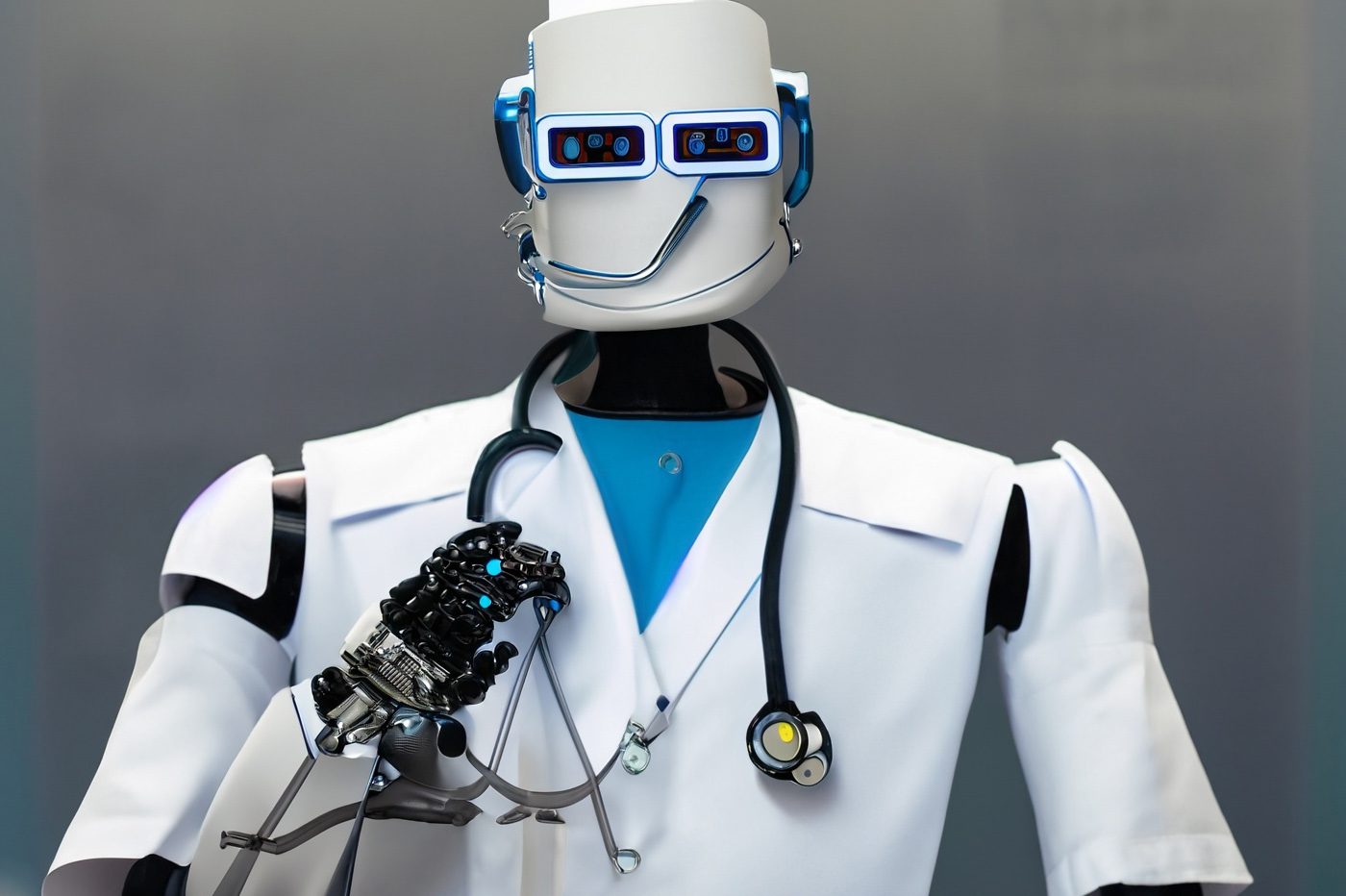

ChatGPT-4, la dernière mise à jour de l’intelligence artificielle développée par OpenAI, est-elle déjà capable de remplacer les médecins ? C’est l’épineuse question posée par le livre « The AI Revolution in Medicine ».

Coécrit par le docteur Isaac Kohane, informaticien et médecin à Harvard, avec l’aide de la journaliste Carey Goldberg et de Peter Lee, vice-président de la recherche chez Microsoft, l’ouvrage s’intéresse à l’impact de l’intelligence artificielle sur la médecine.

Dans le cadre de ses recherches, le chercheur en biomédecine a mis à l’épreuve les capacités de GPT-4, la dernière mise à jour du modèle de langage GPT, qui anime ChatGPT. Annoncé en mars, GPT-4 est uniquement accessible aux abonnés de l’offre payante ChatGPT Plus pour le moment. Le médecin précise avoir obtenu un « accès précoce » à l’IA pour mener à bien ses expériences.

A lire aussi : Le pire de ChatGPT – des chercheurs ont poussé l’IA au-delà de ses limites

ChatGPT a passé une licence médicale

Pour tester les limites de l’IA, Isaac Kohane a posé à ChatGPT 4 des questions issues de l’United States Medical Licensing Examination, le programme d’examen qui aboutit à l’obtention d’un permis médical aux États-Unis. Ce programme en trois étapes donne le droit d’exercer une profession médicale sur le sol américain. Il évalue les connaissances couvrant la plupart des disciplines médicales, allant de la biochimie au raisonnement diagnostique. Toutes les facultés de médecine américaines font passer l’examen à leurs étudiants au cours de leur cursus. La première étape est passée après environ deux ans d’études, la seconde au bout de quatre ans, et la troisième est requise pour devenir médecin.

Premier constat : GPT-4 est parvenu à répondre correctement à 90 % des questions du programme. Le modèle de langage s’est montré bien plus efficace que GPT-3.5, la précédente version de l’IA. Mise à l’épreuve en février, l’IA avait obtenu un score moyen de 60 %, ce qui est tout de même considéré comme passable. Dans le détail, le robot a obtenu un score situé entre 52,4 % et 75 %. La mise à jour GPT-4 a considérablement amélioré les résultats du chatbot. Il fait même mieux que certains médecins, ajoute le président du département d’informatique biomédicale de la Harvard Medical School.

Comme l’explique le chercheur dans son livre, ChatGPT se distingue aussi par ses fonctionnalités annexes. Lors du test, le chatbot a notamment tiré son épingle du jeu grâce à ses talents de traducteur. Il a pu traduire des informations données par un patient qui parlait en portugais. L’IA a également répondu au malade avec des explications claires et faciles à comprendre. Le robot conversationnel est en mesure d’aider les médecins à communiquer avec leurs patients, en évitant le jargon technique par exemple.

ChatGPT peut imiter les médecins

Néanmoins, ChatGPT 4, comme ses prédécesseurs, n’est pas capable de comprendre des informations et notions médicales. Il se contente de générer des réponses en fonction des données disponibles. Pour l’auteur de « The AI Revolution in Medicine », le chatbot peut imiter la manière dont les médecins établissent leur diagnostic avec succès.

Pour arriver à cette conclusion, le docteur Isaac Kohane a soumis plusieurs cas à l’intelligence artificielle générative, dont celui d’un bébé rencontré quelques années plus tôt. Sur base d’une poignée d’informations, comme une échographie et le niveau d’hormones, le chatbot a diagnostiqué une hyperplasie congénitale des surrénales, une maladie endocrinienne rare. L’auteur de l’ouvrage était parvenu à la même conclusion en prenant le cas en charge.

Malheureusement, ChatGPT est encore loin d’être infaillible. Lors des expériences menées par Kohane, ChatGPT a multiplié les erreurs de calcul ou les approximations, dont les conséquences pourraient évidemment être désastreuses. Comme toutes les IA génératives, le chatbot peut parfois raconter n’importe quoi avec un aplomb surprenant. Il arrive que ChatGPT se mette à « halluciner », c’est-à-dire à inventer des réponses, s’il manque de données. GPT-4 n’y échappe pas, bien qu’OpenAI affirme avoir réduit le risque d’hallucinations avec ce modèle.

À ce stade, il ne faut pas prendre tout ce que raconte l’IA pour argent comptant. Si vous posez des questions liées à la santé au chatbot, on vous conseille de confirmer la véracité de toutes les réponses sur la toile et auprès de votre médecin. Dans son livre, le docteur Isaac Kohane recommande de vérifier les propos de GPT-4 à l’aide de… GPT-4. En ouvrant une nouvelle conversation, le modèle linguistique va évaluer son raisonnement avec un regard neuf et repérer les éventuelles erreurs.

« De presque n’importe quelle manière, du diagnostic aux dossiers médicaux en passant par les essais cliniques, l’impact sera si large et profond que nous pensons que nous devons commencer à nous battre maintenant pour l’optimiser », peut-on lire dans « The AI Revolution in Medicine ».

En prenant des précautions, ChatGPT peut servir d’assistant aux médecins, conclut le docteur Isaac Kohane. Dans le livre, il imagine d’ailleurs comment des professionnels de la santé pourraient se servir de l’agent conversationnel pour déterminer le mal dont souffre un patient. Entre les mains d’un docteur, qu’il s’agisse d’un expert ou d’un résident de première année, ChatGPT est un outil inestimable… pour peu que celui-ci conserve son esprit critique.

Source :

Business Insider