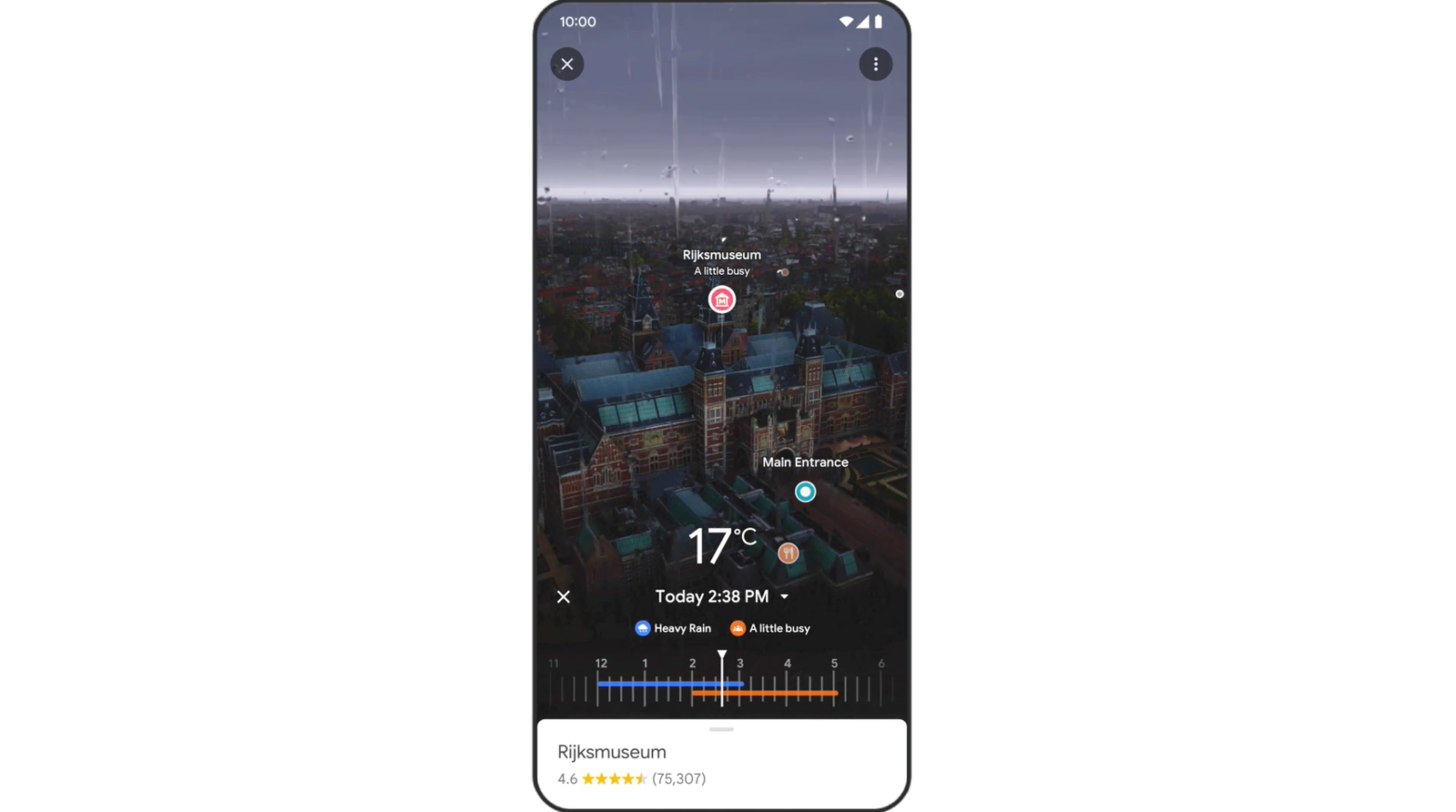

Si vous avez déjà cherché un restaurant sur Google Maps, vous avez peut-être une idée du menu et du décor. Mais il peut être difficile d’anticiper ce que sera l’expérience globale de votre sortie. Y aura-t-il trop de monde à votre arrivée ? L’éclairage crée-t-il la bonne ambiance ?

C’est à ce genre de questions que Google tente de répondre avec sa nouvelle fonctionnalité de « vue immersive » dans Google Maps. Cette nouvelle fonctionnalité, annoncée l’année dernière, est lancée mardi à Londres, Los Angeles, New York, San Francisco et Tokyo. Dans les mois à venir, elle sera lancée dans d’autres villes.

Grâce à l’IA, la fonctionnalité fusionne des milliards d’images Street View et aériennes, créant ainsi une « vue immersive » du monde. Elle utilise les champs de radiance neuronaux (NeRF), une technique d’IA utilisée pour créer des images 3D à partir de photos ordinaires. L’utilisateur peut ainsi se faire une idée de l’éclairage d’un lieu, de la texture des matériaux ou des éléments de contexte, comme ce qui se trouve en arrière-plan.

Image : Google

Du neuf pour Lens

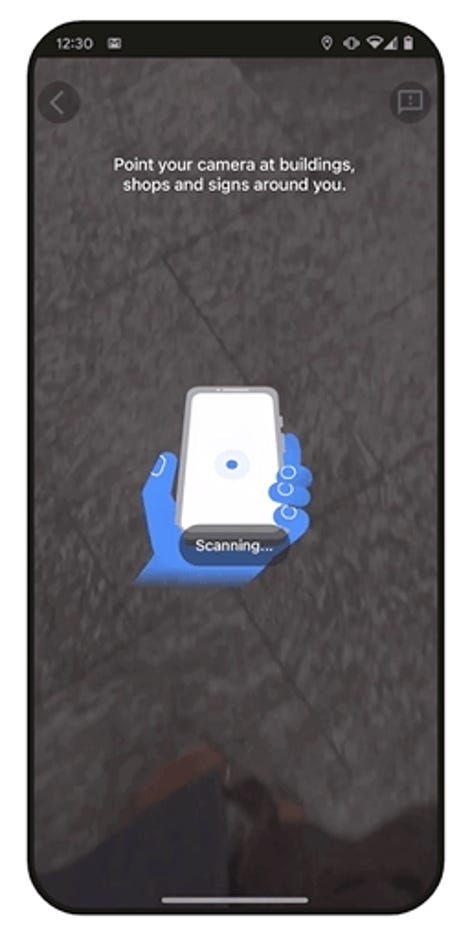

Google va aussi bientôt étendre la Recherche avec Live View dans Maps à d’autres endroits en Europe, notamment Barcelone, Madrid et Dublin. En outre, la fonctionnalité Indoor Live View s’étend à plus de 1 000 nouveaux aéroports, gares et centres commerciaux dans diverses villes, dont Londres, Paris, Berlin, Madrid, Barcelone, Prague, Francfort, Tokyo, Sydney, Melbourne, São Paulo et Taipei.

Maps s’enrichit également de nouvelles fonctionnalités pour les conducteurs de véhicules électriques. La plateforme vous indiquera les lieux qui disposent de bornes de recharge sur place et vous aidera à trouver des chargeurs de 150 kilowatts ou plus.

Google intensifie également les façons dont vous pouvez explorer le monde avec Lens, l’outil alimenté par l’IA qui permet aux gens d’effectuer une recherche d’images à partir de leur appareil photo ou de leurs photos. Lancé pour la première fois en 2017, les gens utilisent déjà Lens plus de 10 milliards de fois par mois, a déclaré Google.

Plus de contexte pour Google Traduction

Grâce à la recherche multiple avec Lens, les gens peuvent effectuer des recherches en utilisant du texte et des images en même temps. Il y a quelques mois seulement, Google a lancé « multisearch near me » pour prendre une photo de quelque chose (comme un repas spécifique) et le trouver près de là où vous êtes. Dans les mois à venir, Google a déclaré qu’il déploierait « multisearch near me » dans toutes les langues et tous les pays où Lens est disponible.

La recherche multiple s’étend également aux images sur le Web sur mobile. En outre, Google propose une fonction de « recherche sur votre écran » avec Lens sur Android. Les utilisateurs pourront rechercher des photos ou des vidéos sur leur écran, quelle que soit l’application ou le site Web qu’ils utilisent, sans quitter l’application.

Google Translate fait également l’objet d’une mise à jour. Entre autres choses, le géant technologique a annoncé mercredi que l’outil fournira davantage de contexte pour les traductions. Par exemple, il vous indiquera si des mots ou des phrases ont plusieurs significations et vous aidera à trouver la meilleure traduction. Cette mise à jour sera disponible en anglais, français, allemand, japonais et espagnol dans les semaines à venir.

Source : « ZDNet.com »