Image : Google

Google a ouvert son application mobile AI Test Kitchen afin de permettre à chacun d’acquérir une expérience pratique limitée de ses dernières avancées en matière d’IA, comme son modèle conversationnel LaMDA (Language Model for Dialogue Applications).

Google a annoncé AI Test Kitchen en mai, en même temps que la deuxième version de LaMDA, et permet maintenant au public de tester certaines parties de ce qu’il pense être l’avenir de l’interaction homme-machine.

AI Test Kitchen est « destiné à vous donner une idée de ce que cela pourrait être d’avoir LaMDA entre les mains », avait alors déclaré Sunday Pichai, PDG de Google.

Dans un premier temps, elle sera accessible à de petits groupes aux États-Unis. L’application Android est disponible dès maintenant, tandis que l’application iOS est prévue « dans les semaines à venir ».

Mise en garde : des contenus inappropriés peuvent filtrer

Lors de l’inscription, l’utilisateur doit accepter certaines conditions, notamment « Je n’inclurai pas d’informations personnelles sur moi-même ou sur d’autres personnes dans mes interactions avec ces démos ».

À l’instar de Meta, qui a récemment présenté en avant-première publique son modèle d’intelligence artificielle pour chatbot, BlenderBot 3, Google prévient également que ses premières versions de LaMDA « peuvent afficher des contenus inexacts ou inappropriés ». Meta a prévenu lors de l’ouverture de BlenderBot 3 que le chatbot pourrait « oublier » qu’il s’agit d’un robot et « dire des choses dont nous ne sommes pas fiers ».

Les deux entreprises reconnaissent que leur IA peut occasionnellement être considérée comme politiquement incorrecte, comme l’a fait le chatbot Tay de Microsoft en 2016 après que le public l’a alimenté avec ses commentaires désagréables. Et comme Meta, Google affirme que LaMDA a subi des « améliorations clés en matière de sécurité » pour éviter qu’il ne donne des réponses inexactes et offensantes.

Mais contrairement à Meta, Google semble adopter une approche plus restrictive, en fixant des limites à la manière dont le public peut communiquer avec lui. Jusqu’à présent, Google n’a exposé LaMDA qu’aux Googlers. Son ouverture au public pourrait permettre à Google d’accélérer le rythme de l’amélioration de la qualité des réponses.

Simulation de dialogues

Google publie AI Test Kitchen sous la forme d’un ensemble de démonstrations. La première, « Imagine it », vous permet de nommer un lieu, à la suite de quoi l’IA vous propose des pistes pour « explorer votre imagination ».

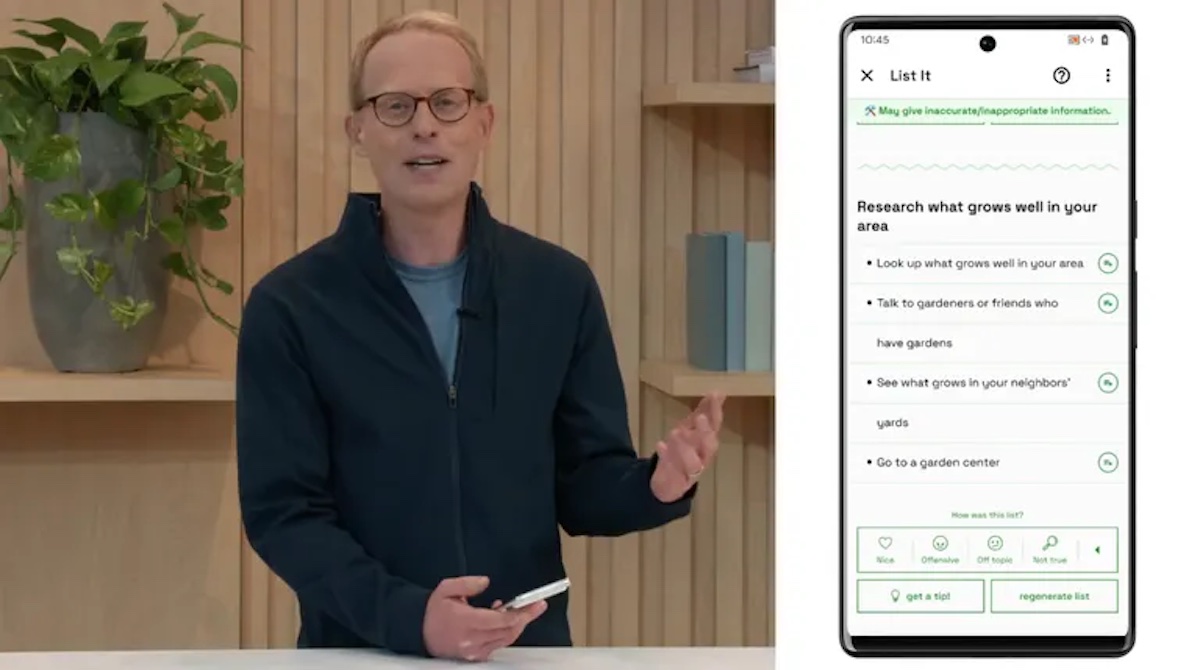

La deuxième démo, « List it », vous permet de « partager un objectif ou un sujet » que LaMDA tente ensuite de décomposer en une liste de sous-tâches utiles.

La troisième démo, « Talk about it (Dogs edition) », semble être le test le plus libre, bien que limité aux questions canines : « Vous pouvez avoir une conversation amusante et ouverte sur les chiens, et uniquement sur les chiens, ce qui permet d’explorer la capacité de LaMDA à rester dans le sujet même si vous essayez de vous en écarter », explique Google.

LaMDA et BlenderBot 3 recherchent les meilleures performances dans les modèles de langage qui simulent le dialogue entre un ordinateur et des humains.

LaMDA est un grand modèle de langage de 137 milliards de paramètres, tandis que le BlenderBot 3 de Meta est un « modèle de dialogue de 175 milliards de paramètres capable de converser dans un domaine ouvert avec un accès à l’internet et une mémoire à long terme ».

Les tests internes de Google ont été axés sur l’amélioration de la sécurité de l’IA. Google affirme avoir effectué des tests contradictoires pour trouver de nouvelles failles dans le modèle et a recruté une « équipe rouge », composée d’experts en attaques, qui a « découvert des résultats supplémentaires nuisibles, mais subtils » selon Tris Warkentin de Google Research et Josh Woodward de Labs at Google.

Une exposition au public à double tranchant

Bien que Google veuille garantir la sécurité et éviter que son IA ne dise des choses honteuses, Google peut également tirer profit du fait de la mettre dans la nature pour qu’elle fasse l’expérience de la parole humaine qu’elle ne peut pas prédire. Tout un dilemme.

Google souligne plusieurs limites dont a souffert Tay de Microsoft lorsqu’elle a été exposée au public. « Le modèle peut mal comprendre l’intention derrière les termes d’identité et parfois ne pas produire de réponse lorsqu’ils sont utilisés parce qu’il a du mal à différencier les invites bénignes et adverses. Il peut également produire des réponses nuisibles ou toxiques en se basant sur des biais dans ses données de formation, générant des réponses qui stéréotypent et déforment les personnes en fonction de leur sexe ou de leur origine culturelle. Ces domaines, et d’autres encore, font l’objet de recherches actives », déclarent Tris Warkentin et Josh Woodward.

Google affirme que les protections qu’il a ajoutées jusqu’à présent ont rendu son IA plus sûre, mais n’ont pas éliminé les risques. Les protections comprennent le filtrage des mots ou des phrases qui violent ses règles, lesquelles « interdisent aux utilisateurs de générer sciemment du contenu sexuellement explicite, haineux ou offensant, violent, dangereux ou illégal, ou divulguant des informations personnelles. »

Par ailleurs, les utilisateurs ne doivent pas s’attendre à ce que Google supprime tout ce qui est dit lors de la réalisation de la démo de LaMDA.

« Je pourrai supprimer mes données pendant l’utilisation d’une démo particulière, mais une fois que j’aurai quitté la démo, mes données seront stockées d’une manière telle que Google ne pourra pas dire qui les a fournies et ne pourra plus répondre à aucune demande de suppression », peut-on lire dans le formulaire de consentement.

Source : ZDNet.com