Avec l’accélérateur IA de ses futures puces Core de 14e génération « Meteor Lake », Intel veut faire la différence et rapatrier une partie des calculs dans nos PC. Mais il va falloir que l’écosystème logiciel prenne ce type de puce en charge.

Intel a profité du Computex de Taipei pour distiller quelques informations à propos de sa future génération de processeurs pour PC grand public, les Core de 14e génération dite « Meteor Lake ». Alors que l’IA est en train de révolutionner le monde des centres de données – et de faire la fortune de Nvidia – Intel a (enfin !) décidé d’intégrer un élément dédié à ce type de calculs dans ses puces. Mis à part Apple, avec le NPU de ses puces M1 et M2, côté PC l’accélération des algorithmes entrainés par les IA a du retard. D’un côté, il y a les (très) rares PC fonctionnant avec les puces Snapdragon de Qualcomm, qui ont un NPU Hexagon mais peu ou pas de prise en charge logicielle. De l’autre, il y a les puces AMD et Intel qui jonglent avec les CPU et GPU et quelques rares unités dédiées pour accélérer quelques opérations (floutage webcam, réduction de bruit du micro).

Lire aussi : Intel promet un bond en avant sur l’IA pour ses processeurs Core de 14e génération (août 2022)

Cette situation devrait donc commencer à bouger à la fin de l’année avec l’arrivée de la 14e génération de processeurs Core. Une génération de puces critiques pour Intel. Du point de vue business d’une part, puisque le géant a dévissé en bourse et cédé du terrain à son concurrent AMD dans de nombreux domaines (processeurs professionnels pour centres de données, processeurs mobiles pour PC, etc.). Mais aussi d’un point de vue technologique, comme nous vous en avons déjà parlé : tout dans cette génération de puces sera nouveau. De la partie des cœurs CPU, en passant par un tout nouveau GPU ou encore une nouvelle méthode de fabrication. En effet, jusqu’à présent Intel faisait de la résistance en concevant ses puces d’un seul bloc (conception dite monolithique) quand AMD produit ses puces en petits morceaux appelés « chiplets » (conception désagrégée). Au milieu de ces nouveautés, il faudra donc compter sur un nouveau morceau de puce en charge d’accélérer les algorithmes dits IA. Une nouvelle puce dans la puce, mais qui un petit historique chez Intel…

Un processeur de vision recyclé en puce IA

Si cela fait déjà un moment qu’Intel met en avant les capacités d’accélération de certains algorithmes par ses SoC (CPU, GPU, etc.), la 14e génération de puces « Core » qui devrait arriver en fin d’année sera donc la première à intégrer une puce 100% dédiée à cette tâche. Une puce qui ne tombe pas du ciel : il s’agit à la base d’un processeur de vision ou VPU qu’Intel a hérité du rachat de Movidius en 2016. Une entreprise qui avait développé un processeur dédié à la vision qui est devenue la gamme Myriad chez Intel et dont nous vous avons déjà parlé dans les usages spatiaux

Un peu silencieux sur le sujet ces dernières années, le géant des semi-conducteurs a donc sauté le pas de l’intégration de son VPU dans un processeur classique. « Il s’agit de la 3e génération de puces de ce type, mais elle n’a plus grand-chose à voir avec les premières itérations », nous prévient John Rayfield Vice-Président de l’IA sur les produits grand public d’Intel. Alors que la puce était autonome et intégrait différentes unités comme un cœur petit CPU ARM, la puce IA qui sera intégrée dans les processeurs Core sera très différente. « Il n’y a plus rien qui soit spécifique à la vision. Il s’agit en gros d’un accélérateur d’inférence compatible avec la plupart des frameworks IA tels que OpenVINO, ONNX, Web Neural Network API, DirectML. », explique l’ingénieur. Qui n’y va pas par quatre chemins « Les IA vont changer notre façon d’utiliser les ordinateurs ».

S’affranchir (partiellement) du cloud

Et il n’a pas tort : Microsoft va intégrer ChatGPT dans sa suite Office et tous les domaines, du texte en passant par le son ou la vidéo vont être transformés par ces IA dites génératives. « Mais ces tâches ne sont pas gratuites, ni sans limites », explique le quinquagénaire. « Une requête ChatGPT coûte en fait aux alentours de 6 cents selon nos calculs », poursuit John Rayfield. « Ensuite, il peut y avoir à termes des soucis majeurs de vie privée, puisque toutes ces applications sont exécutées dans le cloud ». De là à dire que la future puce d’Intel – qui ne devrait plus avoir l’étique VPU dans sa version définitive nous a-t-on assuré – va exécuter de gros LLM (large language model) de manière locale il n’y a qu’un pas qu’il ne faut pas faire. « Nous croyons à un développement hybride des IA, avec certaines exploitées dans le cloud et d’autres de manière locale », développe J. Rayfield.

« Si certaines applications ont besoin de puissance, d’autres ont besoin de respecter la vie privée. Et pour cela, rien de mieux que l’exécution locale », assure-t-il. Parmi ces applications, il met en avant « tous les outils de visioconférence qui interagissent avec notre image et le son ». Ainsi, le VPU d’Intel prendra en charge la réduction de bruit, le suivi des sujets ou encore le floutage. Avec un bénéfice important : la conservation de l’énergie. « Notre VPU développe jusqu’à x10 plus de puissance sur ce genre d’applications tout en consommant 1/5e de l’énergie nécessaire à d’autres types de processeurs ».

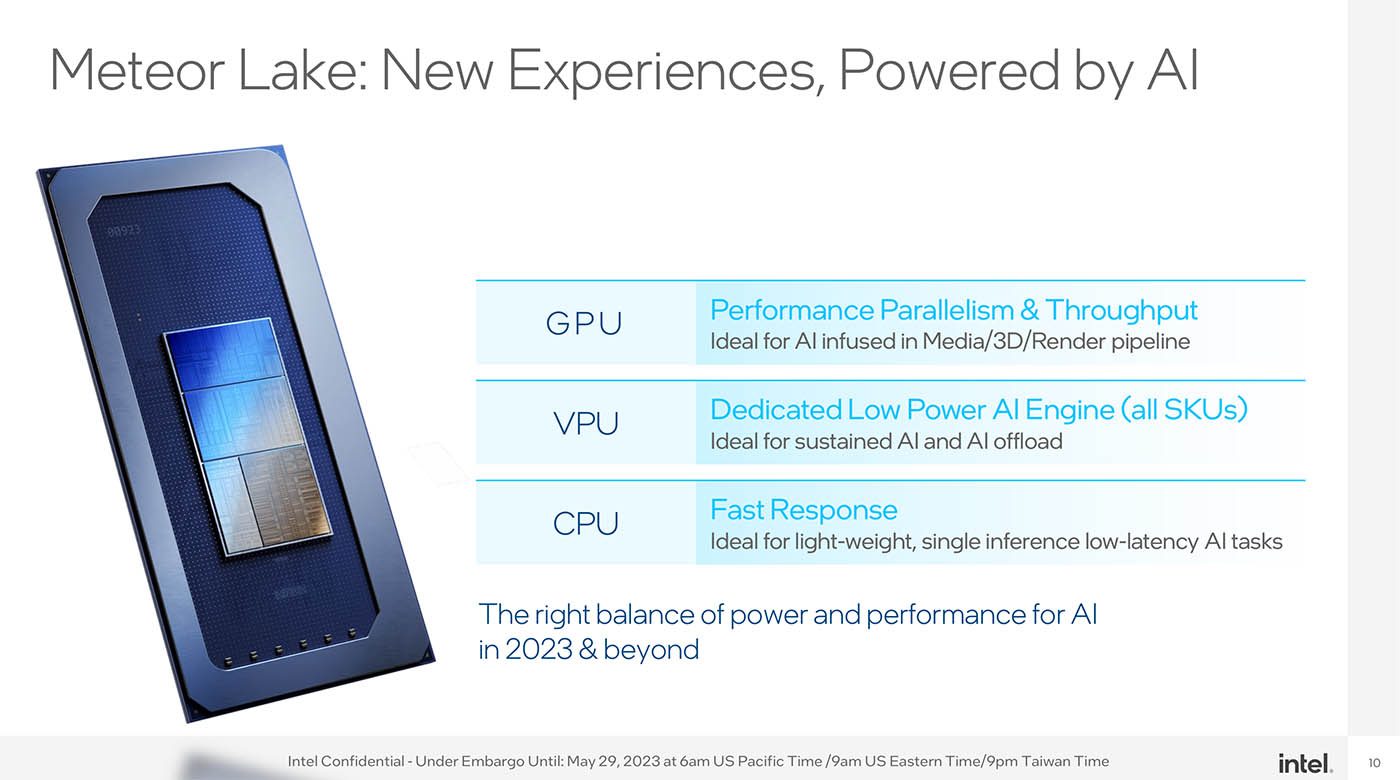

Pour autant, J. Rayfield n’écarte pas les CPU et GPU : « Le VPU trouve tout son sens dans les applications IA en tâche de fond, qui consomment de l’énergie pendant de longues périodes. Mais il peut fonctionner de concert ou être relayé par les GPU et CPU quand la machine a besoin de pics de puissance ».

La question de l’accélération IA dans le PC

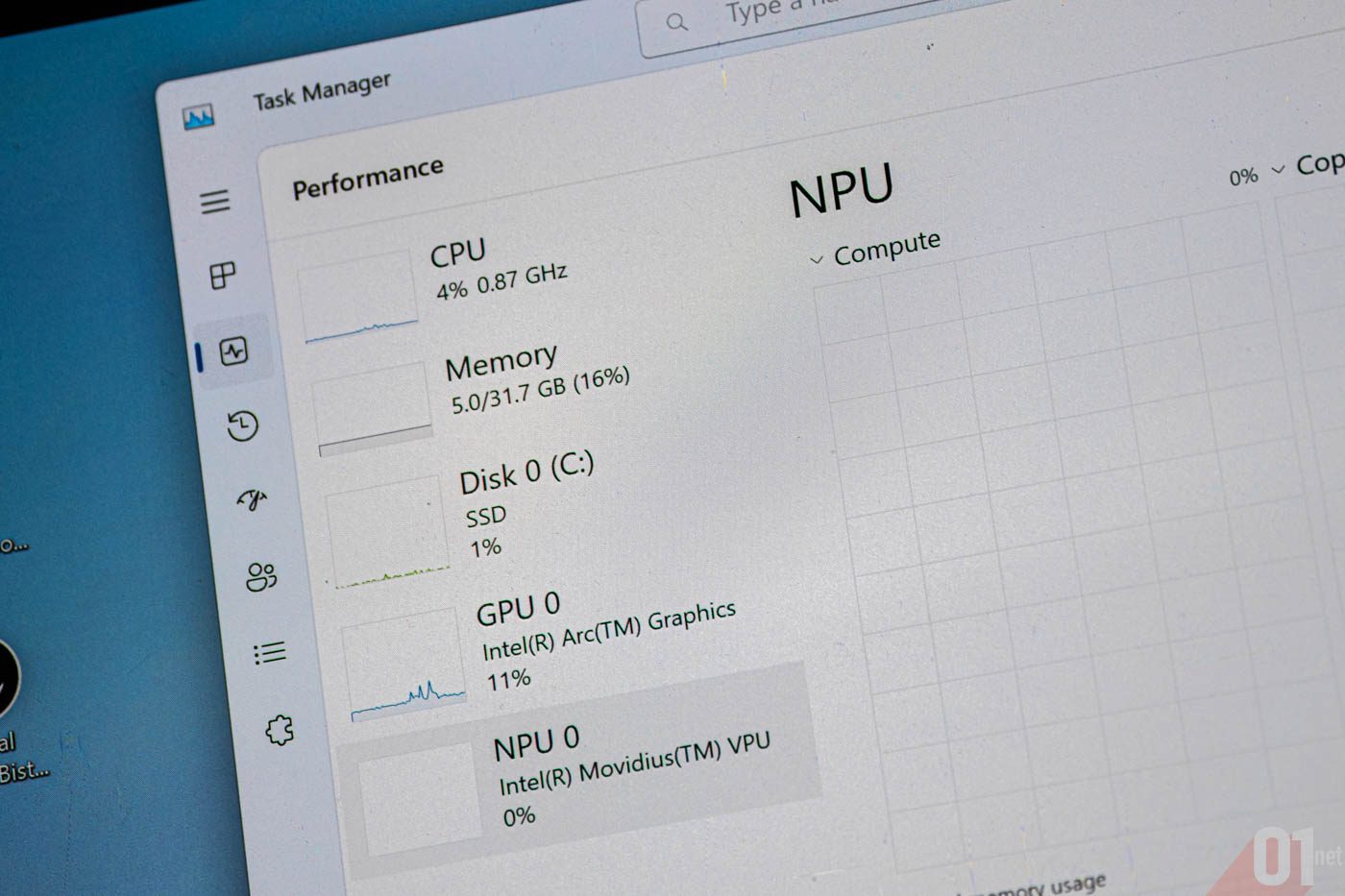

Lors de la présentation sous embargo, Intel nous a présenté deux prototypes intégrant des puces Meteor Lake et fait la démonstration locale des taux d’occupation des différents éléments (CPU, GPU, VPU) avec l’outil webcam de Windows 11 ainsi qu’un rendu de Stable Diffusion local effectué par le logiciel open-source The Gimp. Cela étant, il reste à voir comment les éditeurs logiciels vont s’emparer de ce type de puce IA – AMD a annoncé avoir intégré un tel type d’élément dans une puce de sa série mobile de Ryzen 7000, mais sans donner aucun détail, ni application type. Car hormis les cas susmentionnés, aucun autre type d’application n’utilise, à l’heure actuelle, ce type d’accélération sur PC. Quant aux smartphones, ou ces « NPU » sont généralisés depuis belle lurette, ils sont pour l’essentiel utilisés pour l’imagerie (traitement de l’image en photo/vidéo) ou pour les assistants vocaux (traduction ou retranscription texte/audio en temps réel). Ou pour gérer les tâches de fonds afin de limiter la consommation énergétique.

Si on ne peut que se réjouir que nos PC s’apprêtent à recevoir des NPU de série, il reste désormais à l’écosystème informatique de s’en emparer pour trouver des usages pertinents. Ce que reconnaît J. Rayfield : « Affirmer que 25% de la solution vient du matériel et 75% du logiciel est loin d’être une exagération. L’écosystème est clé, en IA comme dans les autres domaines », reconnaît-il. Ce qui risque de prendre du temps.