La montée en puissance des modèles d’intelligence artificielle passe par la multiplication des accélérateurs IA et, à ce petit jeu, le groupe Nvidia, premier à explorer ce segment, a connu un succès foudroyant.

La firme est incontournable et les géants de l’IA s’arrachent ses composants. A peine lancés, les accélérateurs IA avec architecture Blackwell font déjà l’objet d’une très forte demande.

Le marché potentiel est si vaste que d’autres acteurs peuvent s’y inviter sans même gêner Nvidia. La firme AMD l’a bien compris et a commencé à développer une gamme d’accélérateurs IA Instinct MI300 en cherchant à jouer le rôle de fournisseur alternatif.

L’accélérateur IA MI325X pour fin 2024

La stratégie est payante et AMD peut se permettre d’étendre sa gamme et de préparer l’avenir. L’entreprise annonce ainsi la disponibilité de l’accélérateur IA Instinct MI325X sous architecture CDNA 3 (l’équivalent de RDNA 3 mais en version pro) qui avait été officialisé en juin dernier.

Embarquant 153 milliards de transistors, gravé en 5 nm et doté de 256 Go de la récente mémoire rapide HBM3E, il offre une bande passante de 6 To/s et offre des capacités de traitement de 2,6 petaflops en précision FP8 / 1,3 petaflops en FP16, le tout avec une consommation d’énergie de 1000W.

Le composant vient compléter l’offre d’AMD en passant à la mémoire HBM3E, assurant ainsi une augmentation des performances d’un tiers par rapport au MI300X, ce qui le met à peu près au niveau du concurrent Nvidia H200.

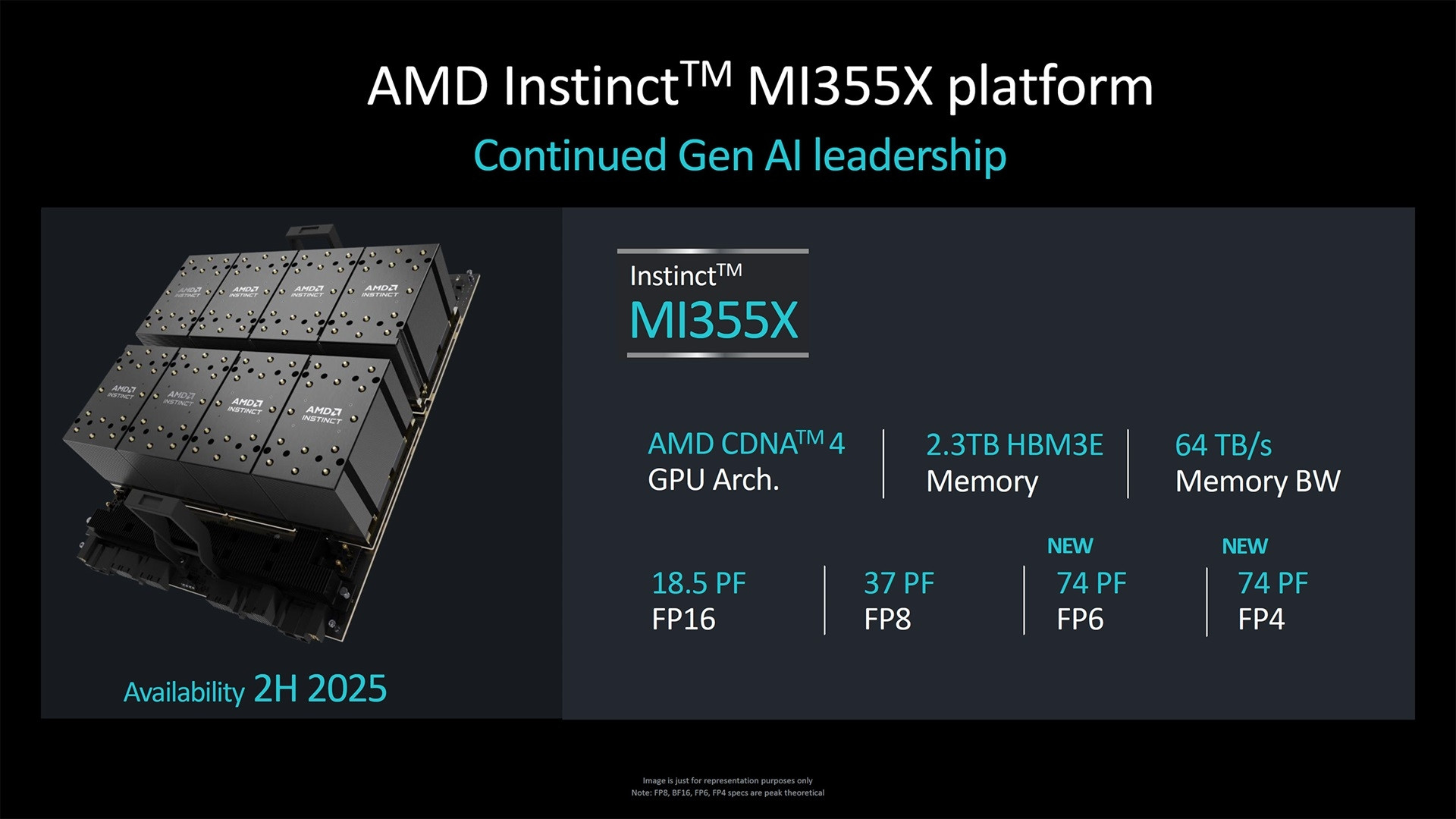

A plus long terme, AMD pose les bases de la génération suivante. La firme a détaillé un futur accélérateur Instinct MI355X qui passera à l’architecture CDNA 4 mais ne sera pas lancé avant fin 2025, en attendant un passage à une série Instinct MI400 quelque part en 2026.

Une première réponse à Blackwell fin 2025

Le maintien dans la série MI3xx suggère une évolution modérée avant une progression plus marquée via les MI400. L’accélérateur IA MI355X profitera d’une gravure en 3 nm et exploitera aussi la mémoire rapide HBM3E.

Il est annoncé avec 4,6 petaflops de capacité de traitement en précision FP8 et apporte le support des précisions FP4 et FP6, ce qui devrait le mettre au niveau du GPU B200 Blackwell de Nvidia.

Le composant MI355X embarquera 288 Go de mémoire et pourra fournir une bande passante de 8 To/s. AMD n’a pas évoqué les tarifs de ses nouveaux accélérateurs IA mais les résultats financiers parlent d’eux-mêmes avec déjà de solides revenus générés grâce à cette activité.