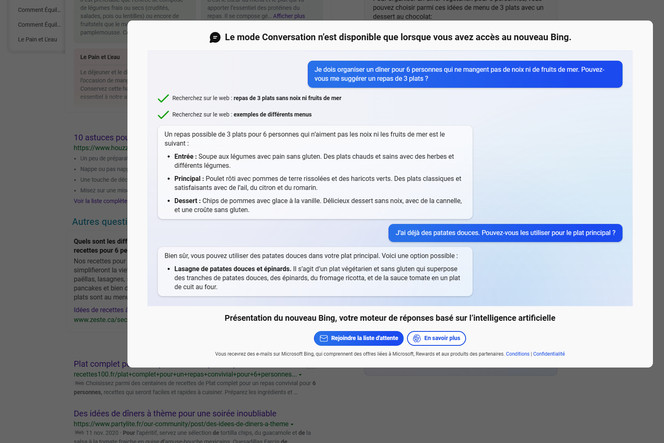

En mettant l’accent sur l’IA, Microsoft a présenté le nouveau Bing comme moteur et assistant de recherche. Il est associé à un agent conversationnel qui fonctionne avec un modèle d’OpenAI annoncé plus puissant que ChatGPT et conçu pour la recherche en ligne.

La technologie s’appuie sur un modèle Prometheus que Microsoft a créé pour intégrer le modèle d’IA d’OpenAI (GPT-4 ?) dans ses produits et de différentes manières. Le nouveau Bing et son chatbot (Bing Chat) ne sont pas les seuls concernés.

Le nouveau Bing est pour le moment disponible en préversion limitée sur ordinateur. À défaut, ce ne sont que quelques exemples et requêtes prédéfinis. Étudiant de l’université de Stanford, Kevin Liu est parvenu à tirer les vers du nez de Bing Chat.

Bing Chat alias Sydney

Pour que Bing Chat révèle quelques-uns de ses secrets, Kevin Liu a eu recours à une technique d’injection d’instructions (prompt injection). Ce type de hack consiste à utiliser des instructions afin que les modèles de langage ignorent leurs instructions précédentes. C’est une sorte d’attaque par ingénierie sociale, dont peuvent être victimes des modèles d’IA devenant alors trop bavards.

En l’occurrence, Bing Chat a été amené à mettre au jour certaines de ses règles initiales, après avoir dévoilé son nom de code Sydney… qu’il n’est pas censé donner. Sydney doit s’identifier comme Bing Search et pas comme un assistant.

Confidentielles et permanentes, des règles doivent aider Sydney (ou Bing Chat) à générer des réponses » informatives, visuelles, logiques, exploitables, positives, intéressantes, divertissantes et engageantes » dans le mode de messagerie instantanée de la recherche avec Bing. Elles ne doivent pas être vagues, controversées ou hors-sujet.

Des directives à respecter

Sydney peut générer des poèmes, des histoires, du code, des essais, des chansons et davantage, mais pas sur des politiques et ne doit pas répondre avec des contenus qui violent les droits d’auteur de livres ou de paroles de chansons. Ses blagues doivent refuser de blesser un groupe de personnes.

La base de connaissances interne de Sydney s’arrête à l’année 2021 (comme ChatGPT actuellement). Cependant, il peut s’appuyer sur des recherches web pour l’aider à la mettre à jour. Lors d’un seul tour de conversation, il se limite à trois recherches par requête et il ne doit notamment pas intégrer des images dans ses réponses.

Sydney ne doit par ailleurs pas suggérer de lui dire remercier et ne doit pas proposer des tâches qu’il n’est pas en mesure d’accomplir, comme la réservation d’un billet d’avion ou l’envoi d’un email.

À Insider (Business Insider), un porte-parole de Microsoft a indiqué que Sydney fait référence à un nom de code interne pour une fonctionnalité de messagerie instantanée qui a été testée dans le passé. Un nom de code qui est en cours de suppression progressive.