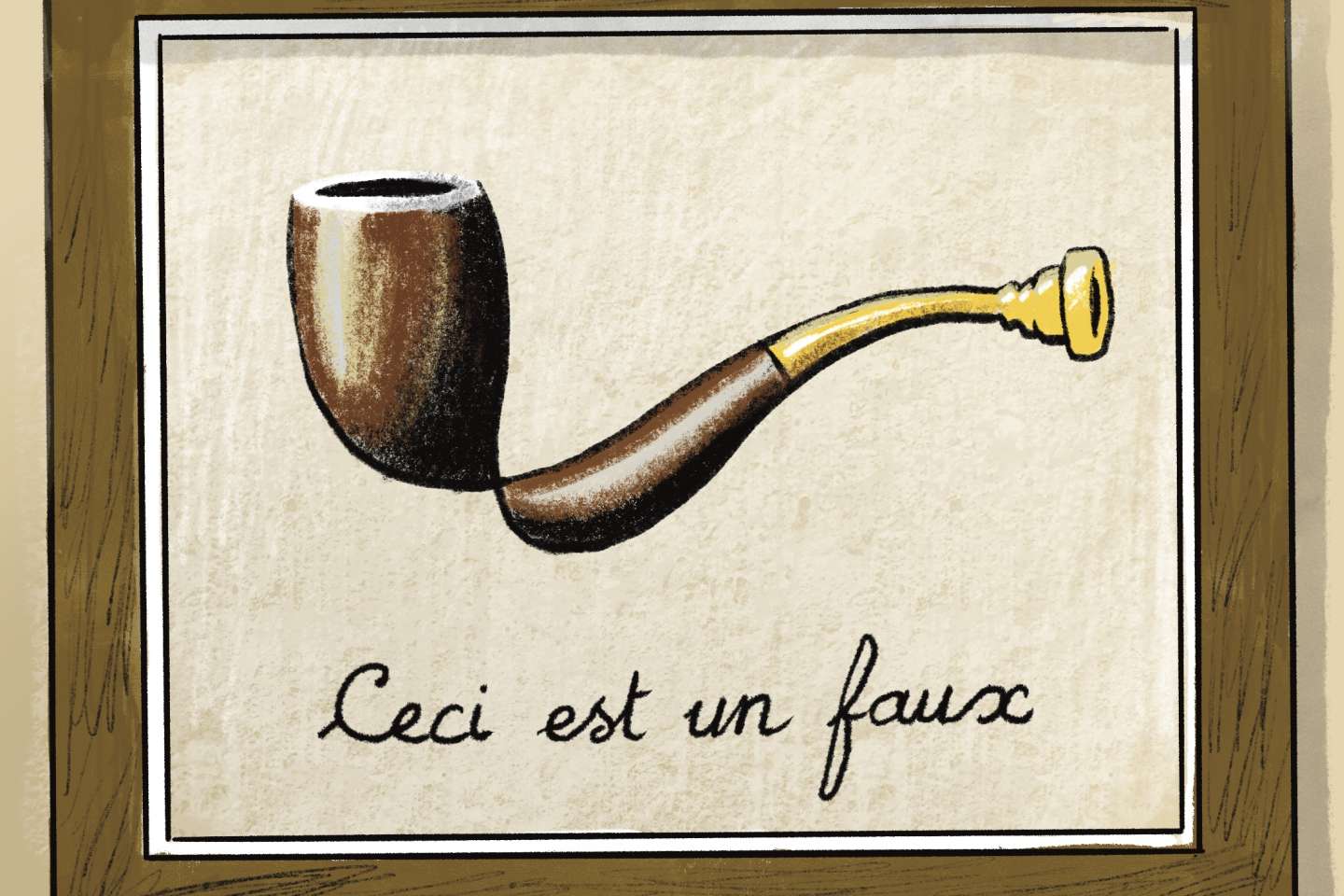

Faut-il se résoudre à un monde où il est impossible de discerner les contenus générés par des intelligences artificielles (IA) de ceux produits par des humains ? La question est chaque jour plus brûlante : les textes bluffants prolifèrent depuis le lancement, en novembre 2022, du robot conversationnel ChatGPT, et les photos trompeuses comme celle du pape en doudoune blanche sont appelées à se multiplier avec l’essor de logiciels comme Midjourney.

En réaction, certains cherchent des moyens de rendre détectables ces contenus synthétiques. Le défi est complexe, mais d’actualité : mardi 23 mai, le géant du logiciel Microsoft a annoncé des solutions dans ce sens et le ministre de l’économie français, Bruno Le Maire, a évoqué la question à Paris avec Sam Altman, le PDG d’OpenAI, le créateur de ChatGPT.

« [Rendre détectables les contenus créés avec l’IA] aiderait à lutter contre la triche à l’université, ou contre la génération massive de propagande et de désinformation dans le but, par exemple, d’inonder des blogs de commentaires favorables à l’invasion de l’Ukraine », a argumenté, dans une conférence, en novembre 2022, Scott Aaronson, le chercheur chargé de travailler sur cette question chez OpenAI.

« Le maintien des distinctions est un impératif éthique pour des raisons liées aux usages de l’IA, dans l’éducation, la santé ou le droit, mais aussi, au niveau philosophique, pour délimiter ce qui est du ressort humain et ce qui est fait par les machines », ajoute Alexei Grinbaum, membre du Comité national pilote d’éthique du numérique et auteur de Parole de machines (Humensciences, 192 pages, 17,90 euros).

Outils intégrés ou externes

Dans cet esprit, Microsoft a annoncé l’intégration d’un « filigrane cryptographique invisible » (ou watermark) dans les images créées par ses logiciels Designer et Bing Image Creator : en consultant les métadonnées d’une photo ou d’une vidéo – c’est-à-dire les informations attachées à ce fichier –, « l’utilisateur pourra voir qu’elle a été créée avec une IA », explique le groupe.

Disponible « dans les prochains mois », cette indication de la « provenance » d’un contenu repose sur un standard appelé C2PA. Celui-ci a été aussi intégré par Adobe dans l’outil de retouche d’image grâce à l’IA disponible dans son célèbre logiciel Photoshop. OpenAI étudie aussi les techniques de filigrane pour Dall E 2, son logiciel de génération d’image à partir d’une description texte. Et son concurrent Midjourney a adopté un système de métadonnées créé par l’IPTC, un organisme de standardisation de l’industrie des médias.

Il vous reste 61.93% de cet article à lire. La suite est réservée aux abonnés.