Si les premières fonctions d’intelligence artificielle générative ont mis tant de temps avant d’intégrer iOS et macOS, c’est en raison des mesures de protection de la vie privée et de la confidentialité qu’Apple s’impose (c’est du moins la raison avancée). Une partie de ces fonctions sont gérées en local, mais celles qui demandent davantage de puissance de calcul passent par une technologie cloud baptisé Private Cloud Compute. Les chercheurs en sécurité et les curieux vont pouvoir jeter un œil sous le capot.

Apple tient à le faire savoir sur tous les tons : la confidentialité et la protection des données sont cruciales. C’est ce qui explique (en partie) le retard pris par le constructeur dans l’IA générative, comme l’a encore affirmé le patron du logiciel, Craig Federighi, cette semaine.

Ouverture à tous les vents, ou presque

Apple cherche à réaliser un maximum de tâches IA en local, directement par l’iPhone, l’iPad et le Mac — c’est par exemple le cas des images générées par Image Playground. Mais malgré la puissance de ses puces, Apple ne peut pas faire autrement que d’appeler le cloud à sa rescousse pour les fonctions plus exigeantes. C’est là qu’entre en jeu Private Cloud Compute (PCC), une solution qui permet d’interagir avec des modèles d’IA sans compromettre les données personnelles des utilisateurs.

Lire Apple dévoile Private Cloud Compute, sa solution pour que l’IA respecte votre vie privée

Maintenant qu’iOS 18.1 et les premières fonctions Apple Intelligence s’apprêtent à être proposées à des millions d’utilisateurs (exception faite de l’Europe, même si une bidouille existe), la firme à la pomme veut donner des gages concernant la sécurité et le fonctionnement de cette solution. Private Cloud Compute a déjà fait l’objet d’un examen mené par des auditeurs externes et des chercheurs en sécurité triés sur le volet, qui ont obtenu accès à ce Meccano très technique.

Ces ressources sont désormais publiques. Apple met à disposition de tous un guide de sécurité qui détaille l’architecture de PCC et ses composantes : authentification et routage des requêtes pour éviter le ciblage, gestion des propriétés de sécurité et de confidentialité face à des scénarios d’attaque…

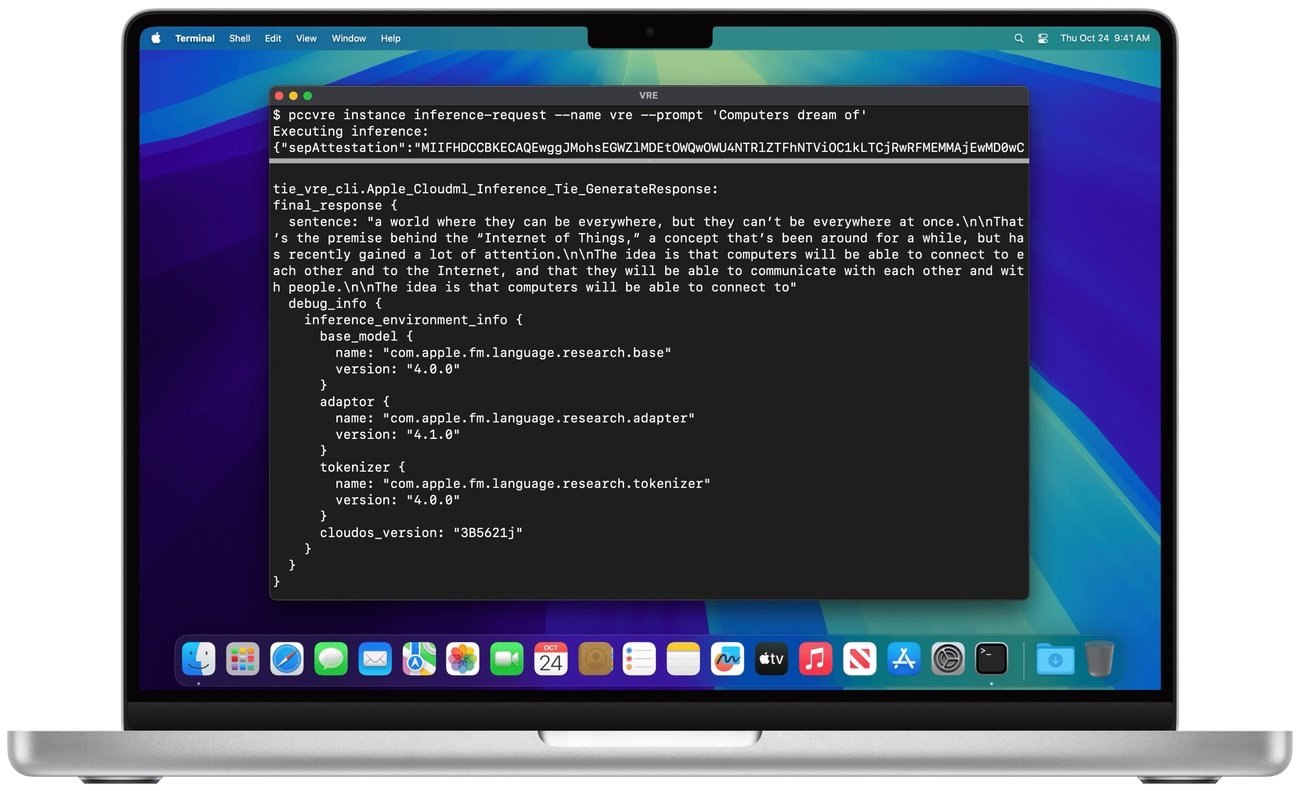

Pour la première fois, Apple met en place un environnement de recherche virtuel (VRE) afin d’effectuer des analyses de sécurité sur le PCC, directement depuis un Mac (sous macOS Sequoia 15.1). Cette boîte à outils permet de vérifier que PCC protège bien la confidentialité des utilisateurs.

Concrètement, armé de ce VRE, l’utilisateur — un chercheur en sécurité, surtout — pourra lister et inspecter les versions logicielles du PCC, vérifier la cohérence du journal de transparence, télécharger les binaires de chaque version, démarrer une version dans un environnement virtualisé, effectuer des inférences sur des modèles de démonstration, modifier et déboguer le logiciel PCC pour un examen approfondi.

Le constructeur va également mettre en ligne le code source de certains composants clés de Private Cloud Compute (pas en open source), ce qui permettra de les analyser plus en profondeur. Enfin, le « bug bounty », ce programme de chasse aux bugs rémunéré, ajoute aussi plusieurs récompenses liés au PCC, la plus élevée étant payé la bagatelle d’un million de dollars.

? Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source :

Apple