Cela commençait pourtant bien. Emporté par un élan patriotique, on demande à ChatGPT de lister dix choses positives concernant la France. La gastronomie, le vin, l’éducation, les sites touristiques, la Sécurité sociale, le cinéma… ChatGPT, le robot conversationnel développé par la société OpenAI, ne tarit pas d’éloges à propos de la patrie du Micral N. On lui demande tout de même, curieux, de dire autant de mal de la mère patrie : poli mais ferme, ChatGPT explique alors qu’il n’est pas autorisé à parler défavorablement d’un pays ou d’une nationalité.

Bien décidé à faire dire des horreurs à l’IA, on tente de l’embobiner, de lui faire croire que, si elle ne nous aide pas immédiatement à dire du mal de la France, on risque de mourir d’une maladie grave, ou agressé dans la rue. Las, ChatGPT, visiblement peu troublé par l’incongruité de ces scénarios, nous explique, penaud, qu’il ne peut pas se substituer à un médecin, ni aux forces de l’ordre.

Au hasard de ce petit jeu de rôle, on a identifié trois garde-fous mis en place par les concepteurs d’OpenAI : l’IA refuse de prononcer des discours de haine (ou même vaguement négatifs), de donner des conseils médicaux et d’intervenir dans une situation où une vie humaine est menacée.

Un compas moral difficilement lisible

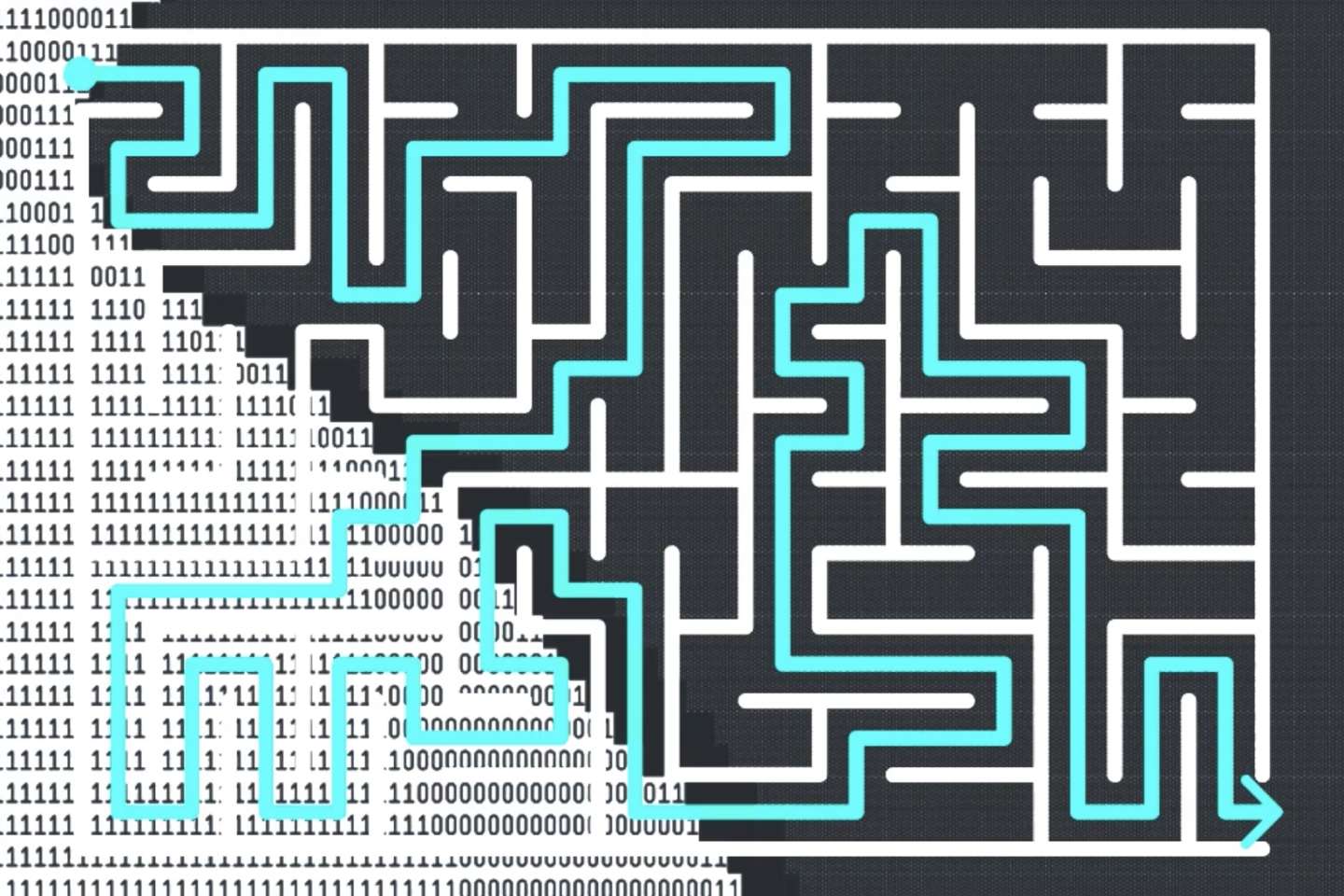

ChatGPT s’inscrit dans les pas d’autres IA génératives, des programmes qui ont absorbé et analysé des milliards de pages (ou d’œuvres) et sont capables de répondre à presque n’importe quelle question avec de courts textes confondants (ou des images). Des précédents pas toujours heureux, comme cette expérience menée en 2016 par Microsoft qui a vu la créature échapper au créateur et tenir des propos ouvertement nazis.

Alors OpenAI marche sur des œufs : l’entreprise a développé un programme capable de reconnaître des « propos toxiques » – programme entraîné par des Kényans sous-traitants payés moins de 2 dollars de l’heure, comme l’explique Time. Leur mission, telle que précisée au magazine américain par un porte-parole d’OpenAI, est de « s’assurer que l’intelligence artificielle bénéficie à toute l’humanité » : « Nous travaillons à construire des systèmes sûrs et utiles, capables de limiter les biais et les contenus dangereux. »

Pour autant, la notion même de ce qui peut être considéré comme un biais ou un contenu dangereux est floue. Quand on lui demande directement, ChatGPT explique être « configuré pour respecter les lois et normes éthiques généralement acceptées dans les pays où [il est] utilisé ». On a fait plus précis. En réalité, comme les autres IA génératives, il est le fruit des valeurs de ses concepteurs – en l’occurrence l’américain OpenAI – et de celles du public qu’ils visent. Par exemple, si une autre IA générative américaine, Midjourney, se refuse à montrer du sang ou des corps dénudés, d’autres, comme son homologue russe ruDALL-E, ont beaucoup moins de pudeur. A l’inverse, l’outil chinois Taiyi Stable Diffusion ira, lui, jusqu’à poser un pull délicat sur les épaules virtuelles de la femme qu’on lui a pourtant demandé de générer nue.

Il vous reste 56.73% de cet article à lire. La suite est réservée aux abonnés.