Selon un cadre de Microsoft, l’entreprise a dépensé « plusieurs centaines de millions de dollars » pour concevoir le supercalculateur qui motorise les projets d’OpenAI comme ChatGPT. Au cœur de la machine, les composants les plus coûteux sont les plus puissants GPU professionnels de Nvidia.

À moins d’être enfermé dans une cave, vous n’avez pas pu échapper au tsunami de nouvelles autour d’OpenAI et de son bijou, ChatGPT. Une IA capable de répondre aux questions, d’écrire des devoirs (ou des cours), de simuler des genres littéraires… et de faire aussi quelques horreurs. Mais le fait est que ChatGPT et les outils d’OpenAI sont le séisme informationnel qui révèle au grand public la puissante future de l’IA. Or, les IA, ça ne sort pas du chapeau des ingénieurs et chercheurs. Les modèles se pensent, certes, mais surtout, ils doivent être entraînés. Une opération qui consomme beaucoup de ressources : temps, énergie et un matériel de pointe. Car pour entraîner et faire fonctionner ChatGPT, OpenAI et son financier, qu’est Microsoft, n’ont pas lésiné sur les dépenses. Selon Scott Guthrie, le vice-président de Microsoft en charge du cloud et de l’IA, l’entreprise a dépensé plusieurs centaines de millions de dollars dans le projet. Notamment dans les puces en charge des calculs.

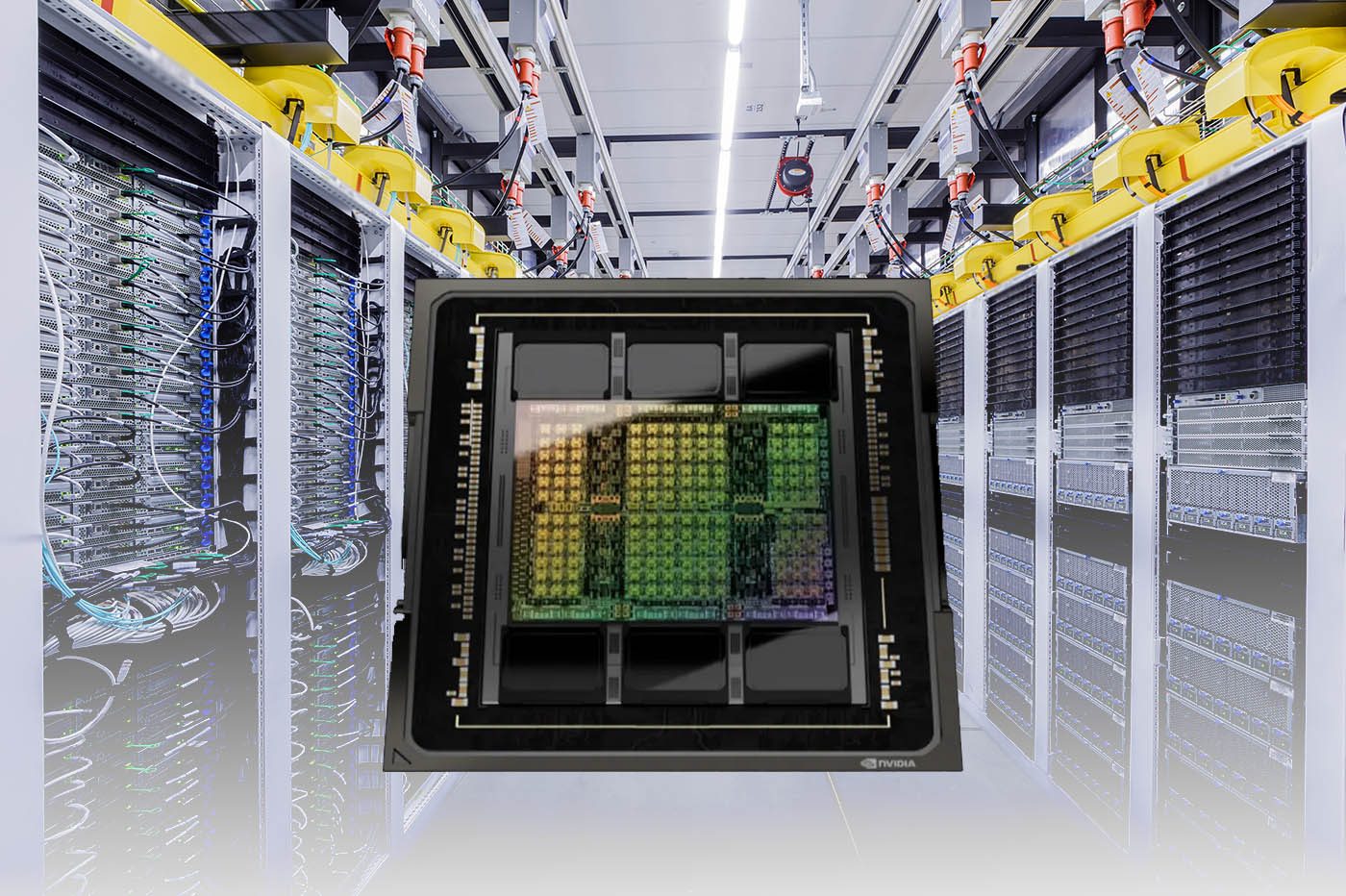

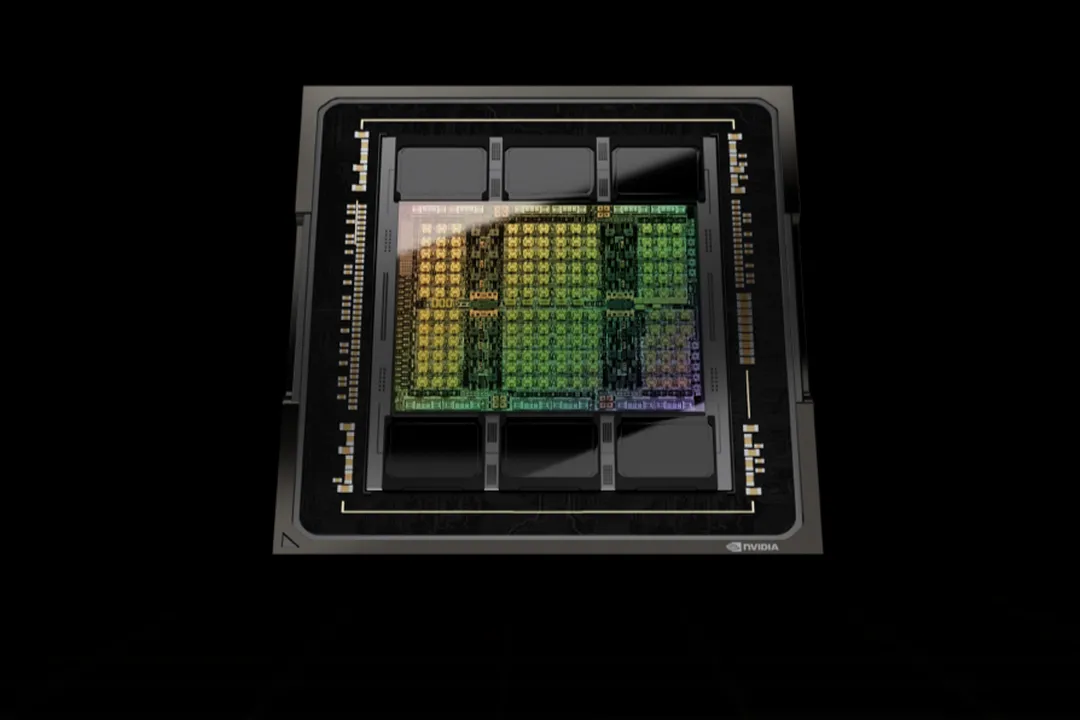

Au cœur de la technologie d’OpenAI, il y a le cloud Azure de Microsoft et des milliers de machines appelées « ND H100 v5 ». Sous ce nom technique, se cache un module matériel surpuissant. Un serveur équipé de processeurs Intel Xeon Scalable de 4e génération (dite « Sapphire Rapids »), des processeurs qui gèrent la fougue des « chevaux » responsable de l’essentiel des calculs, à savoir des GPU de Nvidia. Pas votre bonne vieille GeForce, ni même une super RTX 4090. Non, il s’agit de puces professionnelles appelées H100 spécialement optimisées pour les tâches liées à l’IA. Si Microsoft ne communique pas le nombre ni la nature des CPU d’Intel, (le « s » laisse à penser qu’il y en a au moins deux), on sait que chaque serveur intègre pas moins de huit H100 de Nvidia (à 30 000 $ par carte, l’addition doit être salée !). Soit 640 milliards de transistors (80 milliards par GPU) interconnectés par les technologies NVSwitch et NVlink pour diviser les temps de calcul jusqu’à neuf fois par rapport aux GPU A100, de 2020. Ou comment transformer des mois de calculs en quelques semaines. Et surtout, rapporter un maximum d’argent à Nvidia qui se taille la part du lion de la valeur de ces super machines.

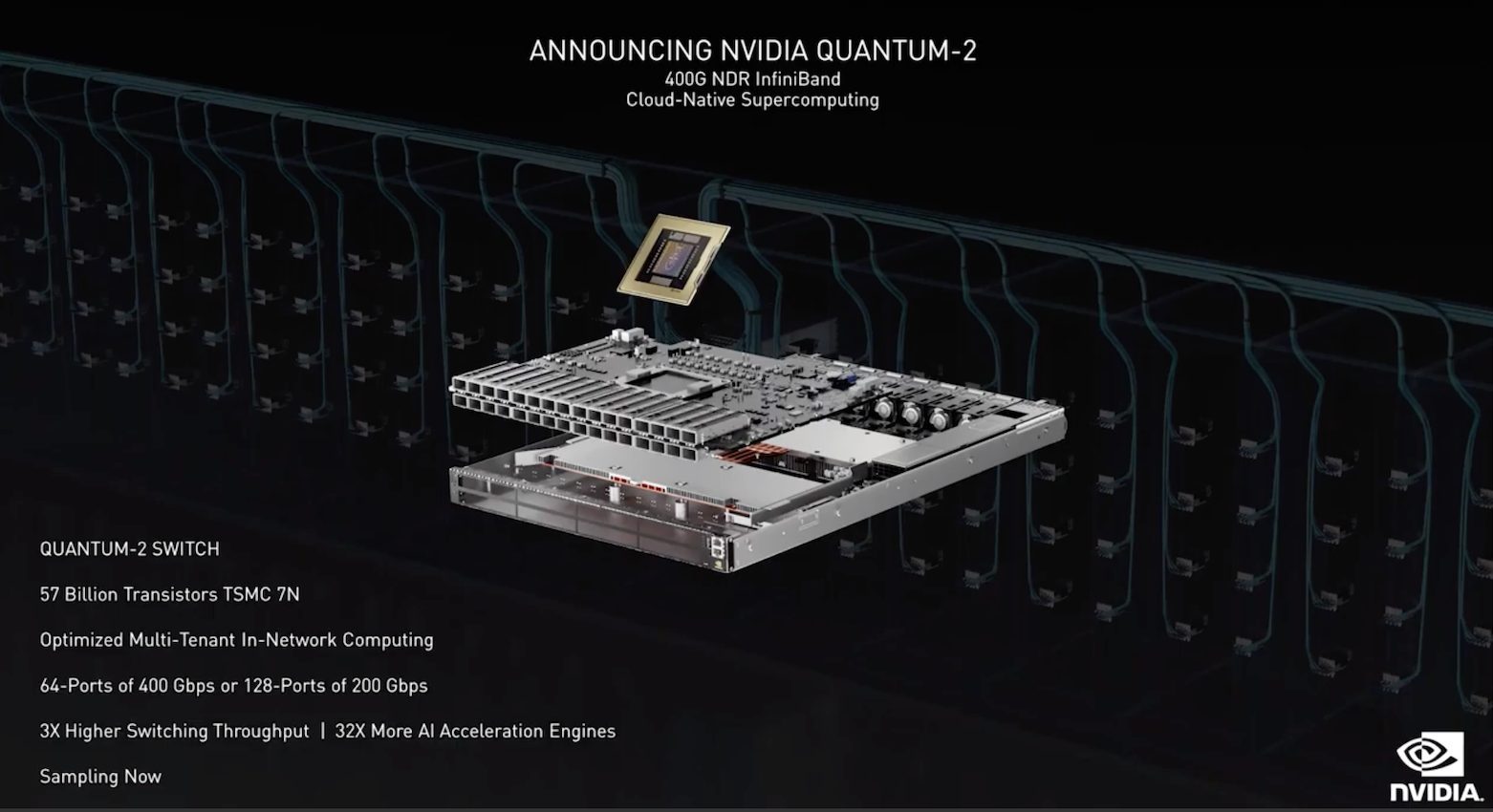

Car la puissance de ces serveurs est au double avantage de Nvidia. Outre sa réussite en matière de puissance brute de ses GPU – qu’il vend par paquet de huit pour chaque rack de serveur ! –, la firme au logo vert a aussi été sélectionnée pour relier les serveurs entre eux avec ses puces Quantum-2 InfiniBand. Car, dans le calcul intensif, la puissance brute ne suffit pas : il faut savoir bien distribuer les tâches.

Nvidia domine le calcul… et le réseau

Si AMD se targue d’avoir un GPU plus puissant que Nvidia – qui prétend l’inverse, évidemment –, cette puissance n’est qu’une donnée parmi beaucoup d’autres. À moins d’avoir un supercalculateur chez vous pour faire des mesures de performances professionnelles – ce que nous n’avons pas ! – il faut regarder le scope complet de ces puces pour voir l’arme fatale de sa solution de calcul : le réseau. Un réseau qui est, avec la mémoire, le véritable goulet d’étranglement de l’augmentation des performances de calcul des supercalculateurs.

À lire aussi : Supercalculateur Frontier : AMD au cœur du plus puissant ordinateur au monde (mai 2022)

Nvidia l’a joué fine. Si l’entreprise a continué sans relâche de développer des puces de plus en plus performantes – en 2023, elle a toujours un net avantage dans le monde des GPU gaming et professionnels –, l’entreprise a racheté en 2020 une entreprise inconnue du grand public : Mellanox. Un spécialiste du réseau que Nvidia a absorbé et dont il a « greffé » les produits à ses GPU professionnels. Vendant à la fois des super puces réseaux, mais aussi des switches (qui distribuent les informations) et ses logiciels, Nvidia a optimisé ses GPU et ses équipements réseaux pour donner le meilleur d’eux-mêmes quand ils fonctionnent de concert.

Ainsi, la solution Quantum-2 InfiniBand de Nvidia est à même de faire transiter 400 Gbit de données par serveur – ça vous change du routeur 1 Gbit de votre box ! Et surtout, les équipements et logiciels réseaux sont capables de distribuer intelligemment les calculs sur des milliers de GPUs répartis dans des milliers de serveurs. Une « intelligence » nécessaire aux millions de requêtes auxquelles les services non seulement de ChatGPT, mais désormais aussi de Bing, doivent faire désormais faire face. Aussi, la prochaine fois que vous utiliserez ChatGPT, vous pourrez imaginer le déluge de puissance de calcul et les vitesses de transfert de compétition qui se déchaînent pour calculer et acheminer les résultats en une fraction de seconde. Tout ça pour rédiger une chanson à la gloire des termites dans le style de NTM !

Source :

Bloomberg