Consommant moins de 1W, la nouvelle plate-forme Snapdragon AR2 Gen 1 profite d’une nouvelle structure. Au lieu de réunir toutes les fonctions en une seule puce, Qualcomm a éclaté son SoC en trois puces. Répartissant ainsi la chaleur dégagée et facilitant les designs plus compacts. De quoi faire exploser le nombre de modèles… Et le succès commercial ?

Une pour toutes et toutes pour une ! Ce n’est pas une mais trois puces qui pourraient faire donner le vrai premier élan significatif aux lunettes de réalité augmentée. Espérant ressembler à des lunettes classiques, ces appareils de réalité augmentée vont prochainement profiter de la nouvelle plate-forme de Qualcomm, appelée Snapdragon AR2 Gen 1. Le mot plate-forme est plus important que jamais puisque Qualcomm a changé son approche pour cette nouvelle génération.

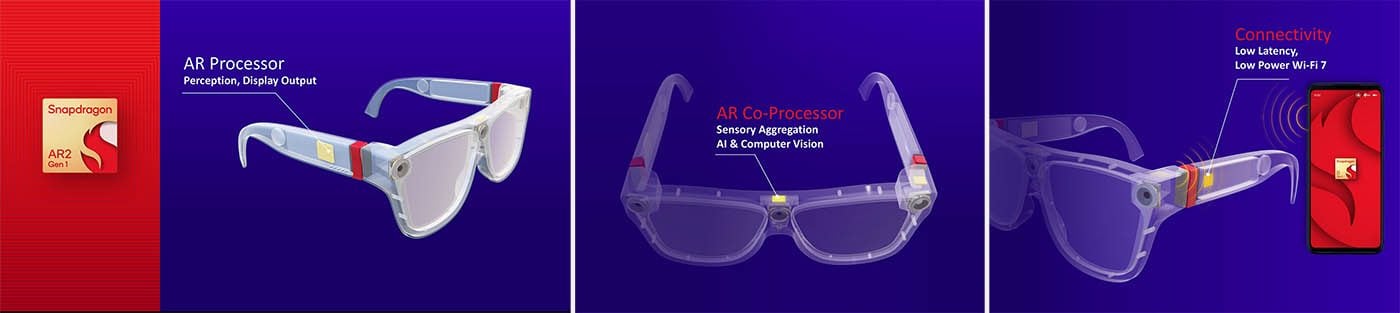

Contre une tendance générale qui veut que l’on intègre toutes les fonctions dans une seule puce appelée SoC (system on a chip), Qualcomm a « éclaté » son processeur, jadis unique, en trois minuscules puces. Une puce principale qui se loge dans une branche, un module réseau qui s’intègre dans la branche opposée et un coprocesseur qui loge dans le cadre frontal. Une approche qui, de manière peut être contrintuitive, va faciliter les design. Mais qui permet surtout de répartir la chauffe sur toute la surface des lunettes. Et ainsi donner plus de latitude pour augmenter les performances de la partie computing.

Moins d’un Watt et chaque composant à sa place

« Il faut se rendre compte que notre plateforme dissipe moins d’un Watt ! », se félicitent Said Bakadir et Hugo Swart, responsable du développement du Snapdragon AR2 Gen 1. Un exploit qui était presque un passage obligé, puisque « la conception de lunettes de réalité augmentée est un triple défi de performances, de taille de produit et d’énergie », continuent les ingénieurs. Ajoutant que « la taille et le design sont des éléments encore plus critiques que pour le développement des casques VR ».

Pour produire une plateforme qui soit plus facile à intégrer, les ingénieurs ont découpé la puce en trois composants qui se distribuent les tâches. Le processeur principal, un petit bijou gravé en 4 nm basé sur les puces Snapdragon classiques, regroupe de nombreuses sous-unités spécialisées (CPU, GPU, mémoire, ISP Spectra, etc.). C’est lui qui effectue les calculs liés à la perception de l’environnement et qui gère l’affichage, grâce à une sous-puce développée spécialement pour ce type de puce.

Ce Reprojection Engine est celui qui gère la position (et les déplacements) dans l’espace des objets à afficher. Pour l’aider dans sa tâche, le coprocesseur agrège les informations des capteurs et aide dans les calculs IA et liés à la vision. La puce réseau, un Fastconnect 7800 que l’on retrouve (là encore !) dans les puces Snapdragon, gère la connexion au téléphone. Et ce, en Wi-Fi 7, s’il vous plaît.

Car au-delà de la distribution des tâches sur l’appareil en lui-même, les concepteurs de cette plate-forme ont aussi dû s’interroger sur la distribution des tâches entre le téléphone et les lunettes. « Le passage par le téléphone est obligatoire pour ne pas trop charger les lunettes en équipement et les maintenir légères », explique MM. Bakadir et Swart. « Il faut faire attention à ne pas intégrer plus de puissance que ce dont nous avons vraiment besoin ». Pour les calculs nécessitant une latence plus faible, pour la position géographique (GPS), etc. le smartphone est nécessaire au bon fonctionnement de l’ensemble.

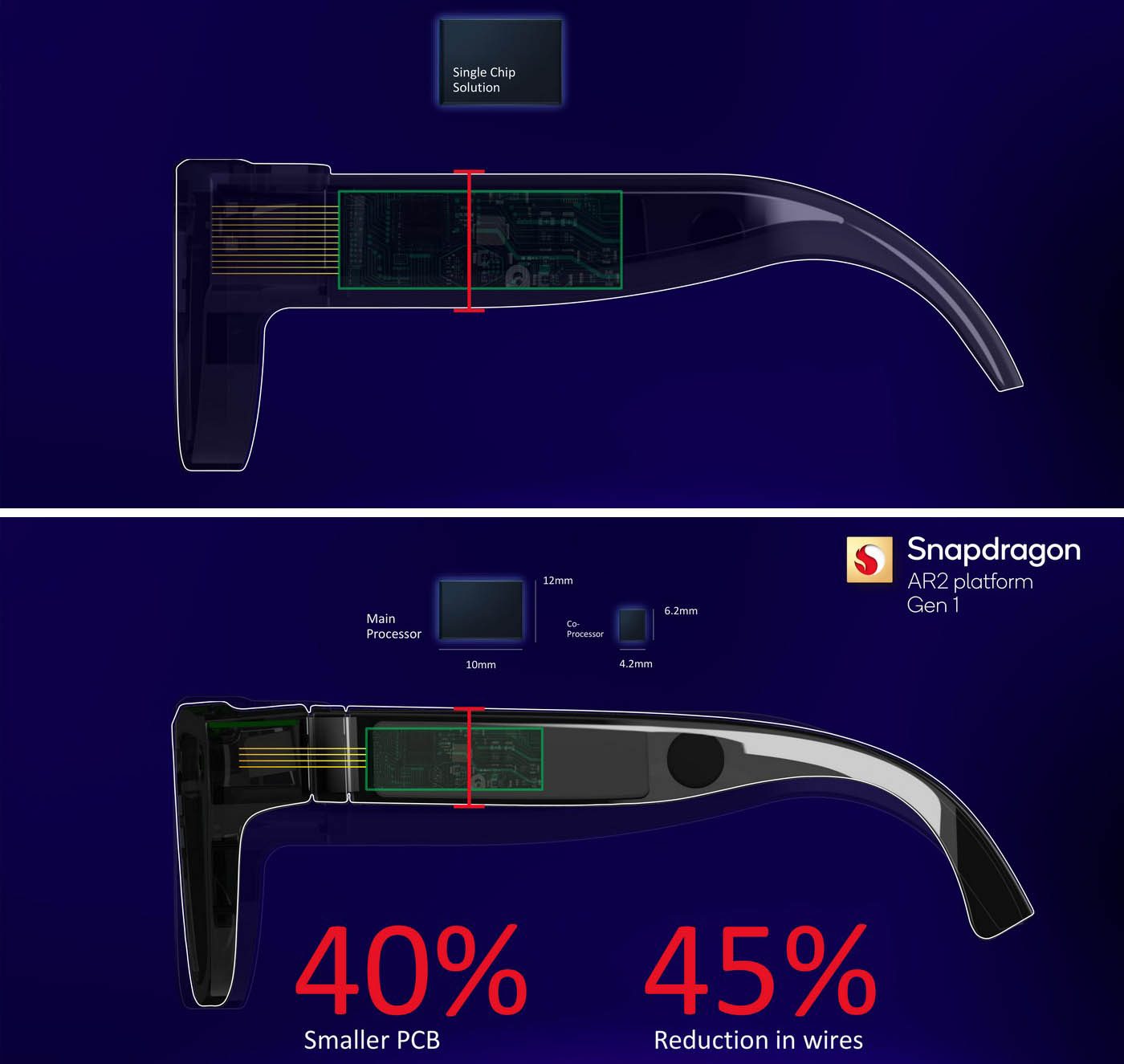

Fragmenter la puce pour simplifier le passage des câbles

L’un des avantages clé de cette conception en trois puces est la simplification du passage des câbles. Car des caméras en passant par les mini écrans intégrés, jusqu’aux différents capteurs (distance, luminosité, accélération, etc.), le fait d’avoir deux points d’accès permet d’éviter de déployer un large ruban de câbles vers un seul point. La découpe du SoC en trois puces (et la gravure en 4 nm de la puce principale) permet de réduire la taille du PCB (la carte qui supporte les circuits imprimés) de 40%. Et leur agencement permet de réduire de 45% le volume de câbles à faire circuler.

Ce qui devrait permettre de produire des designs plus fins et donc plus attrayants. Sans rien perdre au change. Bien au contraire, puisque la plateforme consomme 50% d’énergie en moins que la génération précédente et reste toujours en dessous du petit Watt à dissiper. Avec des gains de performances très importants rendus possibles par la finesse de gravure et l’évolution de la génération des différentes briques. Le moteur IA serait ainsi jusqu’à x2,5 plus performant que par le passé.

La résultante devrait être des lunettes plus fines, plus jolies tout en étant plus puissantes et aussi plus endurantes. De quoi stimuler les fabricants qui se sont jetés sur cette génération de plate-forme : entre Honor, Motorolla, Oppo, ZTE ou encore Sharp, ce sont pas moins de dix constructeurs qui ont annoncé développer leurs produits basés sur Snapdragon AR2 Gen 1.

Des cas d’usage à créer

Les lunettes AR, Said Bakadir en est convaincu, « sont la prochaine révolution technologique ». Mais pour l’heure, il reconnaît que les « cas d’usages restent à inventer ». Sans se démonter : « Chez Qualcomm nous avons l’habitude de créer les marchés. Nous avons déjà des idées d’applications comme des lunettes qui vous affichent une version textuelle en temps réel de quelqu’un qui parle pour un sourd ou malentendant. Ou encore, pour vous les journalistes, une application où la caméra vidéo enregistre une séquence et notre processeur IA vous traduit en direct ce que raconte votre interviewé étranger », décrit-il.

Interrogé sur la manière de convaincre des non porteurs de lunette de s’équiper d’un tel accessoire, il ajoute : « Nous croyons aux succès des lunettes en tant qu’outil qui vous apporte quelque chose, qui a de la valeur ajoutée aux tâches que vous devez réaliser. » Et pour cela, il faut des cas d’usages clairs et de bonnes applications.

Qualcomm a retenu ici la leçon du départ tout en lenteur de son écosystème PC et fait directement appel à des développeurs logiciels connus pour préparer les applications de demain. Le titan Adobe est ainsi de la partie, et compte non seulement développer des produits pour profiter d’expériences AR, mais aussi des outils de création en réalité augmentée.

A lire aussi : Snapdragon 8 Gen 2 : Qualcomm vient de dévoiler le processeur phare des smartphones haut de gamme de 2023 (nov 2022)

Et pour attirer Adobe et les autres, Qualcomm a développé une plate-forme de développement logicielle gratuite appelée Snapdragon Spaces. Une suite logicielle qui permet d’accéder facilement à tous les capteurs et de s’adresser directement aux composants. Ceux des lunettes, d’une part, mais aussi ceux du smartphone – pour l’heure, seul le fraîchement annoncé Snapdragon 8 Gen 2 est compatible. Sans doute, en partie, grâce à sa compatibilité Wi-Fi 7 qui permet d’offrir des débits allant jusqu’à 5,8 Gbit/s.

L’affichage, le dernier point de friction

Quand bien même la plate-forme semble avoir un grand potentiel, que ses outils de développement soient à la hauteur et que de nombreuses apps soient développées pour des usages pertinents, une brique est un peu à la traîne : les écrans. « Comme la VR, l’AR repose sur quatre piliers : un écosystème logiciel, une puissance de calcul suffisante, une connectivité adaptée et des écrans de qualité », explique Said Bakadir.

« Nous ne promettons pas que les lunettes de 2023 seront parfaites, mais on voit tout de même des progrès d’année en année. Nous ne concevons pas d’écran, mais nous aidons nos partenaires qui les développent, les technologies arrivent. Et il est vrai qu’il reste des progrès à faire », concède l’ingénieur. Avant d’ajouter que « comme pour les ‘’killer apps’’ la route des technologies d’affichage est encore longue. Mais si les écrans parfaits ne sont pas encore là, au moins notre puce est déjà prête pour piloter les écrans du futur »