Selon Nikkei Asia, le capteur intégré dans le module caméra principal de l’iPhone 15 (2023) sera un nouveau composant « à la pointe ». Ce qui tranche avec la stratégie des précédents terminaux où Apple est clairement suiveur depuis des années.

Après avoir embrassé le 48 Mpix pour son iPhone 14, voilà qu’Apple pourrait aller bien plus loin pour ses prochains iPhone 15. L’information est parcellaire et vague, mais elle montre un changement de mentalité chez Apple : selon Nikkei Asia, l’entreprise américaine profiterait d’un tout nouveau capteur fraîchement développé par Sony et qui n’arrivera dans des terminaux qu’à partir de l’an prochain. Ce qui fait deux points d’exception pour les iPhone. Primo, il y a bien sûr ce côté « à la pointe » qui change radicalement par rapport à la démarche classique d’Apple. Quand on regarde la définition ou les spécifications des capteurs des iPhone, la marque est restée ultra conservatrice pendant des années. Si elle s’est convertie au capteur Exmor RS en 2014 avec l’iPhone 7 (technologie annoncée en 2012), elle est ensuite restée « bloqué » à cette définition durant cinq autres générations, en se contentant de faire grandir un peu son capteur.

Deuxio, il y a ici l’adoption d’un capteur de pointe. Généralement, c’est toujours un constructeur chinois qui annonce l’intégration des capteurs Sony dès leur sortie. Voire, comme Oppo, qui participe activement à son développement – et conserve des exclusivités dessus, quand bien même ce capteur est ensuite vendu à d’autres. En adoptant le 48 Mpix, Apple a certes évolué, mais dans un tempérament de suiveur : le supersampling (suréchantillonage) à partir d’un capteur de 48 Mpix existe chez la concurrence depuis plusieurs années puisque Sony a annoncé un tel capteur pour la première fois en… 2018 !

Le capteur, nerfs de la guerre de la qualité d’image

La qualité d’une photo repose sur trois piliers : le capteur d’image, l’optique et le couple processeur d’image/algorithmes. Tous sont importants dans le cadre de la production d’une bonne image finale. Le capteur est souvent le plus discuté car c’est celui qui se révèle le plus facilement – à côté de lui, les formules optiques et les traitements de surface sont abstraits et la partie traitement d’image une véritable boîte noire.

Lire aussi : Sony, le grand empereur des capteurs (sept. 2017)

Mais le capteur conditionne aussi beaucoup de chose par les lois de la physique : outre la définition (native et exploitée, dans le cadre du suréchantillonage), sa taille et sa structure préfigurent de la qualité d’image finale. D’un côté, ses dimensions conditionnent non seulement la définition ou la collecte de lumière (fréquemment mise en rapport en donnant les dimensions des photodiodes, exprimées en microns). Mais elle donne aussi une information du « look » des images. En effet, plus un capteur est grand, plus la zone de netteté à focale donnée est faible. Ce qui explique pourquoi les « vrais » appareils à grand capteur permettent de faire des portraits avec un bel arrière-plan flou naturellement – alors qu’il faut des algorithmes pour tenter de reproduire l’effet (de manière imparfaite) sur les petits capteurs des smartphones.

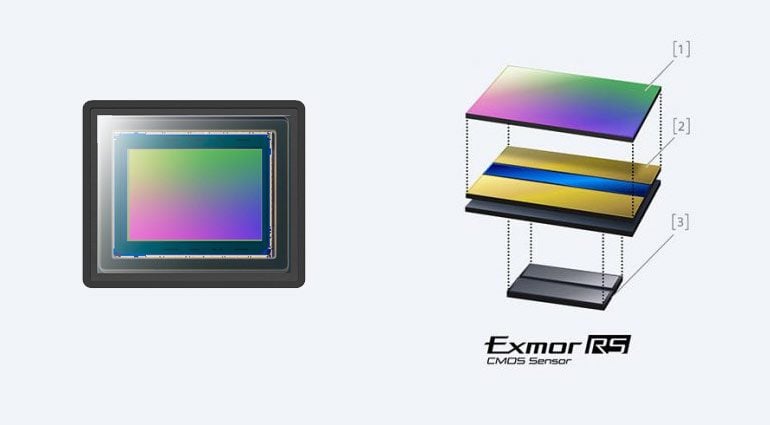

Il y a ensuite les technologies de fabrication du capteur qui sont devenues des éléments cruciaux pour les smartphones. On peut citer la technologie dite « rétroéclairée » Exmor R (back-side illuminated ou BSI) qui consiste à placer les circuits non pas devant la grille des photodiodes, mais à l’arrière. Ou l’ISOCELL ou isolation des photodiodes par des substrats qui empêchent le « rebond » des photons dans les puits de lumière. Ou encore le capteur dit « empilé » Exmor RS (stacked) qui consiste à « souder » de la mémoire vive au dos du capteur pour lui permettre d’atteindre sa vitesse de lecture séquentielle maximale et ainsi proposer des rafales inédites.

Autant de technologies qui sont importantes pour les appareils photo normaux… et tout bonnement cruciales pour les smartphones. Car alors que les boîtiers classiques ont de gros capteurs et de grosses optiques, les smartphones doivent composer avec de tout petits composants. Récupérer plus de lumière (BSI), subir moins de rebonds parasites appelé « crosstalk » (ISOCELL) ou pouvoir combiner plus d’images pour produire un bon cliché (stacked) sont bien plus importants que pour les vrais appareils photo. La preuve : ces technologies sont bien souvent d’abord intégrées aux smartphones avant d’être déployées dans les boîtiers (mais cela s’explique aussi par une plus grande facilité d’industrialisation sur les petits capteurs).

Apple (enfin) au front ?

Nikkei Asia n’a pas confié de détails quant à ce que signifie pour Apple profiter d’un capteur « de pointe ». Si on se base sur le portfolio de technologies déjà existant chez Sony, on peut affirmer qu’il sera au moins BSI et stacked. Avec l’équivalent maison de l’ISOCELL de Samsung, qui est en fait déjà déployé chez Sony (les entreprises ne mettent pas des noms commerciaux sur toutes leurs technologies). On sait juste que ce capteur sortira de l’usine de Nagasaki qui est la seconde plus importante avec celle de Kumamoto (que nous avons visitée en 2017).

Lire aussi : On a rencontré les ingénieurs de Sony qui veulent renverser Canon et Nikon (sept. 2017)

On peut aussi imaginer Apple partir à la course à la taille en faisant grandir son capteur de manière significative. Car même si le capteur au format 1/2.8’’ de l’iPhone 14 Pro est le plus grand de l’histoire d’Apple, le monde Android a déjà des capteurs 1/1.2’’ voire 1 pouce ! Finalement, et parce qu’Apple a les poches plus grandes que toute l’industrie, on pourrait aussi imaginer un déploiement d’une nouvelle technologie Sony exclusif aux iPhone, comme le font déjà de nombreux acteurs Android. Si cela était le cas, cela marquerait un vrai changement de stratégie pour Apple et un comportement plus agressif de la marque dans le domaine. Rendez-vous en septembre 2023 pour voir si Apple est allé au bout des choses dans le domaine.

Source :

Nikkei Asia