L’entreprise qui a bousculé le petit monde de la tech avec ChatGPT annonce son nouveau modèle d’intelligence artificielle, qui prend désormais en compte les images en entrée, et promet de nombreuses améliorations.

Plus performant, plus créatif, moins prompt aux « hallucinations » qui plombent les IA génératives : OpenAI vient de dévoiler GPT-4, la nouvelle version du modèle qui anime ChatGPT. GPT-4 est d’ores et déjà accessible aux abonnés ChatGPT+ (une offre payante à 20 dollars par mois) et par le biais d’une liste d’attente pour les développeurs, afin d’en bénéficier au travers d’une API.

Announcing GPT-4, a large multimodal model, with our best-ever results on capabilities and alignment: https://t.co/TwLFssyALF pic.twitter.com/lYWwPjZbSg

— OpenAI (@OpenAI) March 14, 2023

Première énorme différence avec GPT-3.5 : GPT-4 est un modèle dit « multimodal ». Comprenez une IA capable non seulement d’accepter du texte en entrée, comme ChatGPT, mais aussi des images combinées à du texte. Autrement dit, il lui est possible d’analyser une image que vous lui soumettez aux côtés de votre « prompt ». Et d’en dégager une réponse, comme le montre la capture d’écran ci-dessous. « Que se passerait-il si on coupait les cordes ? » peut-on lire. Ce à quoi l’IA répond : « les ballons s’envoleraient ».

GPT-4 peut avaler 25 000 mots en une requête

Cela ouvre de nombreuses (et vertigineuses) nouvelles possibilités. GPT-4 pourrait ainsi analyser des graphiques, diagrammes, captures d’écran… Attention toutefois, GPT-4 n’est pas DALL-E : il n’offre que du texte en sortie, et ne peut générer de nouvelles images.

Seconde différence évidente : GPT-4 est en mesure d’avaler des requêtes bien plus importantes qu’avant. GPT-3 ne pouvait pas digérer des entrées de plus ou moins 1 024 mots, GPT-4 place cette limite à 25 000 mots. C’est beaucoup, en tout cas de quoi pouvoir digérer plusieurs pages Web entières pour en tirer une réponse.

OpenAI le reconnaît au détour d’un billet de blog : « Dans une conversation informelle, la distinction entre GPT-3.5 et GPT-4 peut être subtile. La différence apparaît lorsque la complexité de la tâche atteint un seuil suffisant – GPT-4 est plus fiable, créatif et capable de gérer des instructions beaucoup plus nuancées que GPT-3.5. »

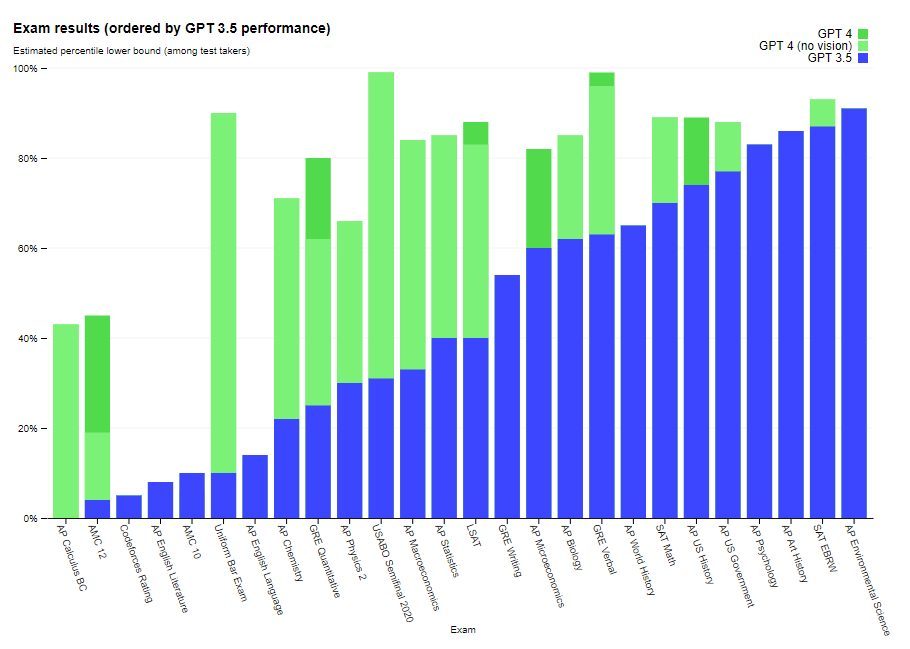

Le modèle serait donc bien plus à même de résoudre des problèmes complexes. OpenAI a testé sa nouvelle IA en la soumettant à dizaines d’examens conçus pour des humains dans diverses matières, desquels il se tire bien mieux que son grand frère, comme le montre le graphique ci-dessous. Il largue aussi GPT-3.5 dans la plupart des benchmarks de modèles d’apprentissage automatique.

Sam Altman, cofondateur et patron d’OpenAI, rappelle que si ce modèle devrait être « plus créatif et moins biaisé », il est encore loin d’être sans défaut. Sa tendance à « halluciner » – autrement dit à inventer des choses fausses – aurait été sérieusement diminuée, mais pas complètement supprimée.

Les ingénieurs d’OpenAI ont en tout cas poussé avec ce modèle la personnalisation de son comportement, qui pourra être modifié par les utilisateurs, tout en restant dans les limites éthiques fixées par l’entreprise : « nous prenons désormais en charge un message “système” dans l’API qui permet aux développeurs (et bientôt aux utilisateurs de ChatGPT) d’avoir une personnalisation significative du comportement. Si vous voulez une IA qui vous répond toujours dans le style de Shakespeare, ou en json, maintenant, vous pouvez l’avoir », écrit Sam Altman sur Twitter.

OpenAI a profité de cette annonce pour introduire une salve de nouveaux partenariats avec des entreprises qui ont bâti de nouvelles fonctions grâce à ce modèle. Duolingo ou Stripe ont par exemple profité de GPT-4 dans leurs applications respectives. Microsoft, qui organise jeudi une conférence sur l’intégration de l’intelligence artificielle générative dans ses logiciels de bureautique, devrait également annoncer de nouvelles fonctions liées à GPT-4. Le géant du logiciel est le principal partenaire d’OpenAI, qui rappelle que ce modèle a d’ailleurs été entraîné grâce au supercalculateur conçu par l’entreprise de Redmond.

Source :

OpenAI