Pendant qu’elle bataille pour maintenir ses liens avec le marché chinois malgré les restrictions commerciales US en lançant des composants aux performances adaptées, Nvidia annonce une suite à son accélérateur graphique IA de référence, le composant Nvidia H100, en lui donnant une suite.

L’événement Supercomputing 23 (ou SC23) est l’occasion de présenter le nouvel accélérateur graphique Nvidia H200 qui prolonge la course à l’armement en puissance GPU pour les intelligences artificielles.

Utilisant toujours l’architecture grapique Hopper, le GPU H200 est présenté comme l’agent qui animera de futurs supercalculateurs de l’ère exascale, avec la capacité de générer jusqu’à 200 exaflops de calculs combinés.

H200, encore plus fort sur la mémoire HBM3

Du peu qu’en révèle la firme, le composant H200 n’est pas très différent du H100 sinon qu’il embarque beaucoup plus de mémoire : 141 Go de mémoire rapide HBM3, contre 80 Go pour le module H100.

Cette grosse progression sur cette caractéristique lui permet d’atteindre une bande passante de 4,8 To/s, contre 3,35 To/s précédemment. Le GPU n’est pas beaucoup plus puissant en soi que le H100 mais la mémoire supplémentaire est décisive pour gérer les gros modèles de langage (LLM) des intelligences artificielles.

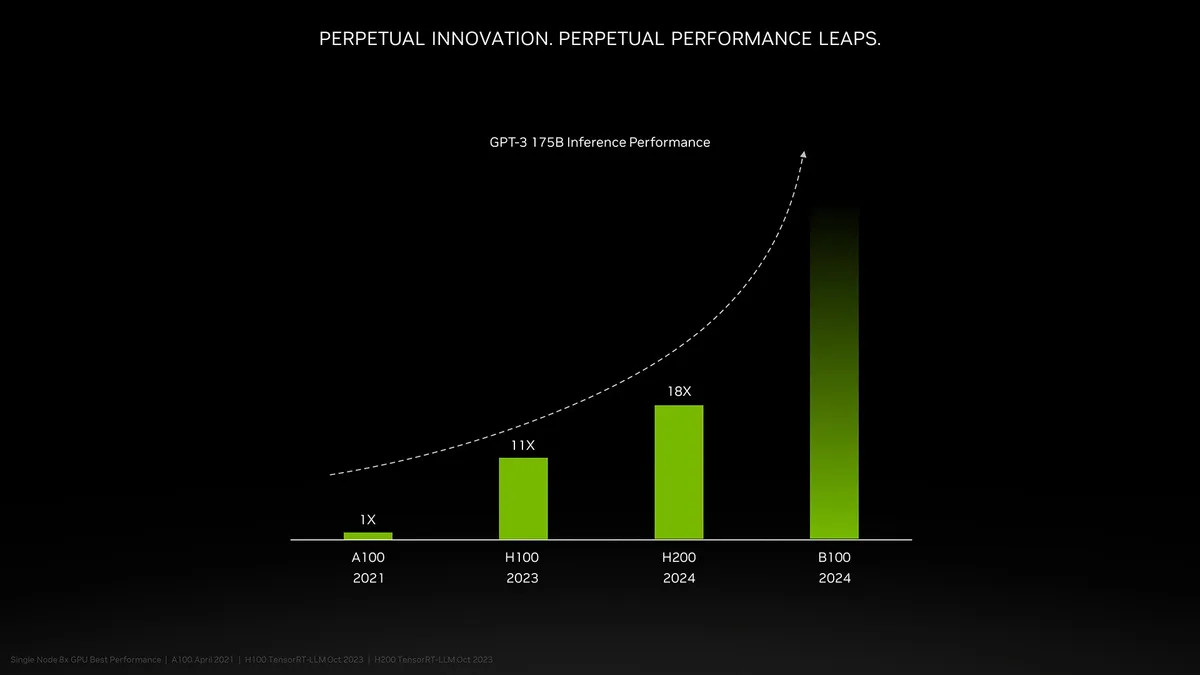

Nvidia affirme ainsi que son module H200 est 18 fois plus performant que son composant A100 (sous architecture Ampere) avec GPT-3, quand le module H100 était déjà 11 fois plus rapide.

Nvidia, incontournable pour l’exascale

Et déjà, la firme évoque un GPU Nvidia B100 exploitant une nouvelle architecture Blackwell dont les performances iront bien au-delà du GPU H200. Mais il est encore trop tôt pour en savoir plus et il faudra attendre l’an prochain pour découvrir ce nouveau GPU.

En attendant, Nvidia proposera le GPU H200 dans un nouveau système GH200 embarquant un processeur ARM Grace et un GPU H200, avec 624 Go de mémoire et qui sera au coeur des grands supercalculateurs, que ce soit dans le système exascale européen JUPITER ou dans plusieurs supercalculateurs au Japon comme aux Etats-Unis.

Le composant GH200 est déjà fourni sous forme d’échantillon partenaires de Nvidia pour évaluation et il sera officiellement disponible à partir du premier trimestre 2024. Par cette manoeuvre, Nvidia compte bien couper l’herbe sous le pied d’AMD, son nouveau concurrent dans le domaine avec son propre composant Instinct MI300X qui veut jouer sur le même terrain mais arrive bien tard.