Si la réalité virtuelle et sa cousine, la réalité augmentée, n’ont pas réussi à enflammer le monde, c’est sans doute en grande partie à cause de ce que l’on pourrait appeler techniquement le « facteur ringard ». Les lunettes intelligentes utilisées pour voir dans un monde virtuel ont une apparence terrible pour tout le monde, sauf pour les nerds les plus endurcis.

Les lunettes de l’unité Oculus de Facebook se sont améliorées au fil des ans, mais la dernière-née, le modèle Meta Quest 2, n’est toujours pas quelque chose que la plupart des gens veulent porter en ville. Les lunettes de Vuzix sont peut-être plus proches d’une déclaration de mode, mais leur capacité d’affichage est primitive et n’est pas quelque chose qu’une personne souhaite regarder pendant de longues périodes.

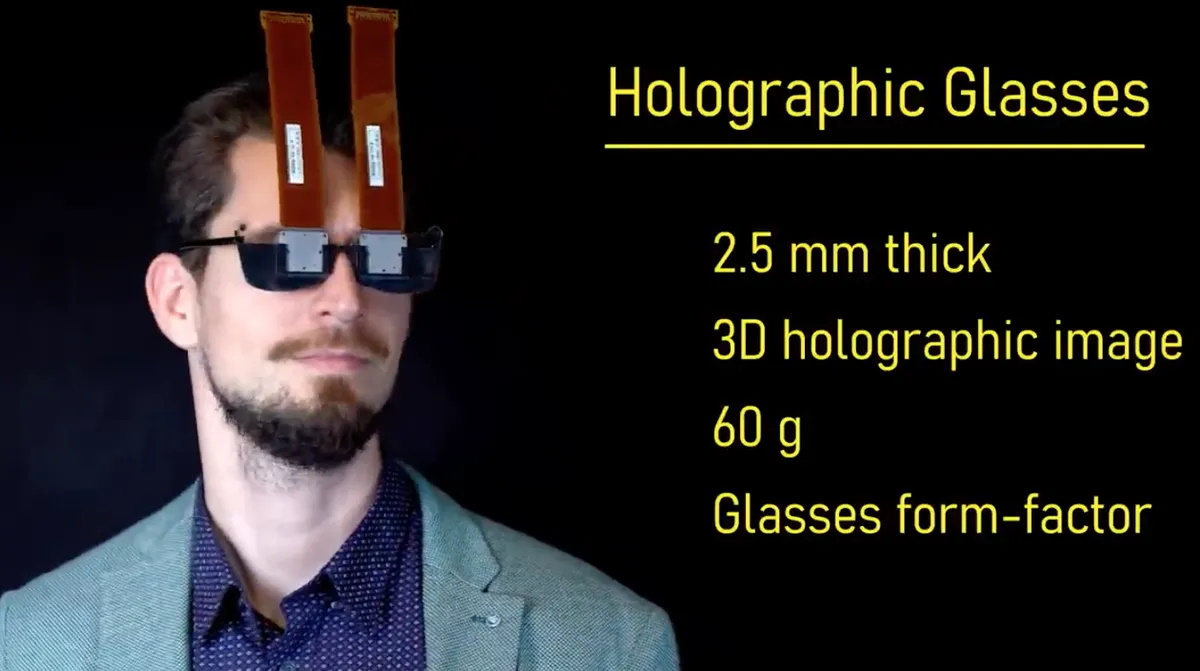

Mais n’ayez crainte, l’aide est peut-être en route. Nvidia, avec l’aide de l’université de Stanford, a proposé le mois dernier ce qu’elle appelle des lunettes holographiques, dont le prototype ne fait que quelques millimètres d’épaisseur et pèse soixante grammes, et qui peuvent s’adapter à des montures normales de type lunettes. Elles vont au-delà des graphiques 2D classiques et produisent des images 3D qui permettent de se concentrer sur certaines zones d’une scène et qui s’adaptent aux mouvements de la personne qui les porte.

Lunettes holographiques

Comme décrit dans un billet de blog, dans un document d’accompagnement et dans une vidéo par les auteurs Jonghyun Kim de Nvidia et de Stanford, ainsi que Manu Gopakumar, Suyeon Choi, Yifan Peng et Gordon Wetzstein de Stanford, et Ward Lopes de Nvidia, les lunettes holographiques sont « un système d’affichage holographique à proximité de l’œil qui offre une présentation d’images 2D ou 3D à chaque œil avec une épaisseur de dispositif de quelques millimètres seulement ».

« Un véritable facteur de forme de lunettes holographiques VR a été présenté pour la première fois », écrivent-ils.

Le matériel, qui a été construit par Jonghyun Kim et son équipe, se concentre avant tout sur la manière de réduire l’épaisseur des casques. La clé est de réduire le grand espace entre l’œil de l’utilisateur et l’écran qui se trouve devant ses yeux. La raison de cet espace est qu’une certaine « distance focale » est nécessaire entre l’écran et la lentille qui se trouve entre la lentille et l’œil.

« Les écrans VR commerciaux sont basés sur le principe de la loupe », écrivent-ils, « où une lentille agrandit l’image d’un micro-écran pour créer une image virtuelle que l’utilisateur perçoit à une certaine distance. » Cela crée un compromis : « Les loupes réussissent à offrir de larges champs de vision avec une grande boîte à yeux, mais la grande distance entre la lentille et l’affichage entraîne des facteurs de forme de dispositifs encombrants. »

Au lieu de cela, les auteurs ont réuni trois composants essentiels : un guide d’ondes, qui prend un faisceau de lumière laser et diffracte la lumière à l’intérieur d’un espace restreint, un modulateur spatial de lumière, qui projette l’image à partir du faisceau de lumière sortant du guide d’ondes et un type spécial de lentille appelé lentille de phase géométrique qui focalise la lumière provenant du modulateur pour l’adapter à l’œil humain.

Réduire l’épaisseur

Grâce à l’utilisation d’un guide d’ondes étroit en sandwich avec le modulateur et la lentille de phase géométrique, les composants sont tous plus fins que ceux utilisés dans des appareils tels que Quest, et ne nécessitent pas non plus un grand espace d’air entre la lentille et l’image.

Les composants sont tous assez standard. Par exemple, le modulateur spatial de lumière provient d’une société appelée Holoeye, qui fabrique de nombreux dispositifs optiques. Le principe du modulateur est de contrôler une série de cristaux liquides afin qu’ils tournent dans l’espace. Lorsque les cristaux tournent, ils modulent la phase d’un faisceau de lumière sortant du guide d’ondes. La lumière forme alors une image holographique sur la surface de l’écran.

Ce nouveau concept permet non seulement de réduire l’épaisseur de l’écran, mais il présente également « deux caractéristiques distinctes qui ne sont pas observées dans les écrans VR classiques ».

Ces deux aspects sont une « boîte à yeux dynamique » et une optimisation logicielle appelée « ordres de diffraction élevés », qui peuvent tous deux améliorer ce que la personne voit de manière inédite.

La boîte à yeux dynamique permet d’orienter la direction de l’image holographique projetée. En modifiant l’angle de la lumière lorsqu’elle pénètre dans le guide d’ondes, l’angle sous lequel l’image holographique frappe l’œil peut également être modifié, afin de simuler la forme d’un objet dans l’espace pour obtenir un effet tridimensionnel.

Optimiser l’image

Les ordres de diffraction élevés permettent d’optimiser l’image que la personne voit. La qualité peut être affectée par la taille de la pupille d’une personne par rapport aux intervalles entre les ordres de diffraction, une fonction de l’angle auquel la lumière atteint la pupille. Si ces intervalles sont trop petits, ils entraînent toutes sortes de considérations supplémentaires sur la distance entre l’objectif et l’image, ce qui pose à nouveau le problème de l’encombrement de l’appareil.

Pour éviter ce problème, les auteurs ont cherché à optimiser les intervalles entre les ordres de haute diffraction pour qu’ils soient plus larges que le diamètre de la pupille, c’est-à-dire supérieurs à 8 millimètres, en les façonnant à l’aide d’un algorithme.

Les auteurs ont modifié un algorithme existant, introduit l’année dernière par un collègue de Nvidia, Manu Gopakumar, et d’autres, connu sous le nom de descente de gradient d’ordre élevé, ou « HOGD », qui « optimise de manière unique les modèles de phase ».

À l’algorithme HOGD de Manu Gopakumar et son équipe, Jonghyun Kim et son équipe ont ajouté une variable pour représenter la taille de la pupille, créant ainsi « Pupil-HOGD ». Selon Jonghyun Kim et ses collègues, « le nouvel algorithme Pupil-HOGD, qui modélise l’ouverture de la pupille, produit la meilleure qualité d’image pour toutes les tailles de pupilles. »

Le défi de la consommation d’énergie

Bien que les spécifications de l’échantillon semblent intéressantes, il y a de nombreuses réserves à faire. L’une d’elles est la question de la consommation d’énergie, qui n’est pas du tout abordée. Les wearables ont toujours été limités. Ils doivent être branchés sur le secteur ou l’autonomie de la batterie est insuffisante.

Comme l’écrivent les auteurs, leur prototype pourrait sérieusement bénéficier de composants conçus sur mesure. Par exemple, le guide d’ondes « fournit un éclairage non uniforme ainsi qu’une phase quelque peu brouillée, ce qui dégrade la qualité des résultats du prototype portable », écrivent-ils. « Avec un guide d’ondes conçu pour les lunettes holographiques, la qualité de l’image du prototype portable pourrait être améliorée », écrivent-ils.

En outre, le champ de vision du prototype, de 22,8 degrés seulement, est très étroit, « bien plus petit que les écrans VR/AR disponibles dans le commerce ». Ce champ de vision étroit est une limitation des modulateurs de phase disponibles dans le commerce chez Holoeye, et de la longueur focale de la lentille de phase géométrique. Les auteurs pensent que certaines solutions améliorées, comme l’empilement de deux lentilles de phase géométrique l’une sur l’autre, pourraient porter le champ de vision à 120 degrés sans trop augmenter l’encombrement.

Et, bien sûr, on veut savoir comment ces connecteurs en ruban qui émergent au sommet de l’appareil comme des oreilles de lapin seront intégrés de manière discrète.

Source : ZDNet.com