Nous avons testé Moshi, l’IA développée par le laboratoire de recherche français Kyutai, pendant plusieurs jours. Freiné par des serveurs à la traîne, l’assistant vocal qui rêve de surpasser ChatGPT n’a pas tenu ses promesses.

Début juillet, Kyutai, un laboratoire de recherche français fondé par Xavier Niel, a levé le voile sur Moshi. En moins de six mois, le laboratoire est parvenu à mettre au point une intelligence artificielle vocale. En miroir de Siri, Google Assistant ou Alexa, Moshi peut interagir avec ses interlocuteurs avec la voix. Kyutai assure que son assistant est capable d’avoir une conversation naturelle avec ses utilisateurs. C’est la grande promesse formulée par le laboratoire à but non lucratif, qu’on présente parfois comme l’OpenAI made in France.

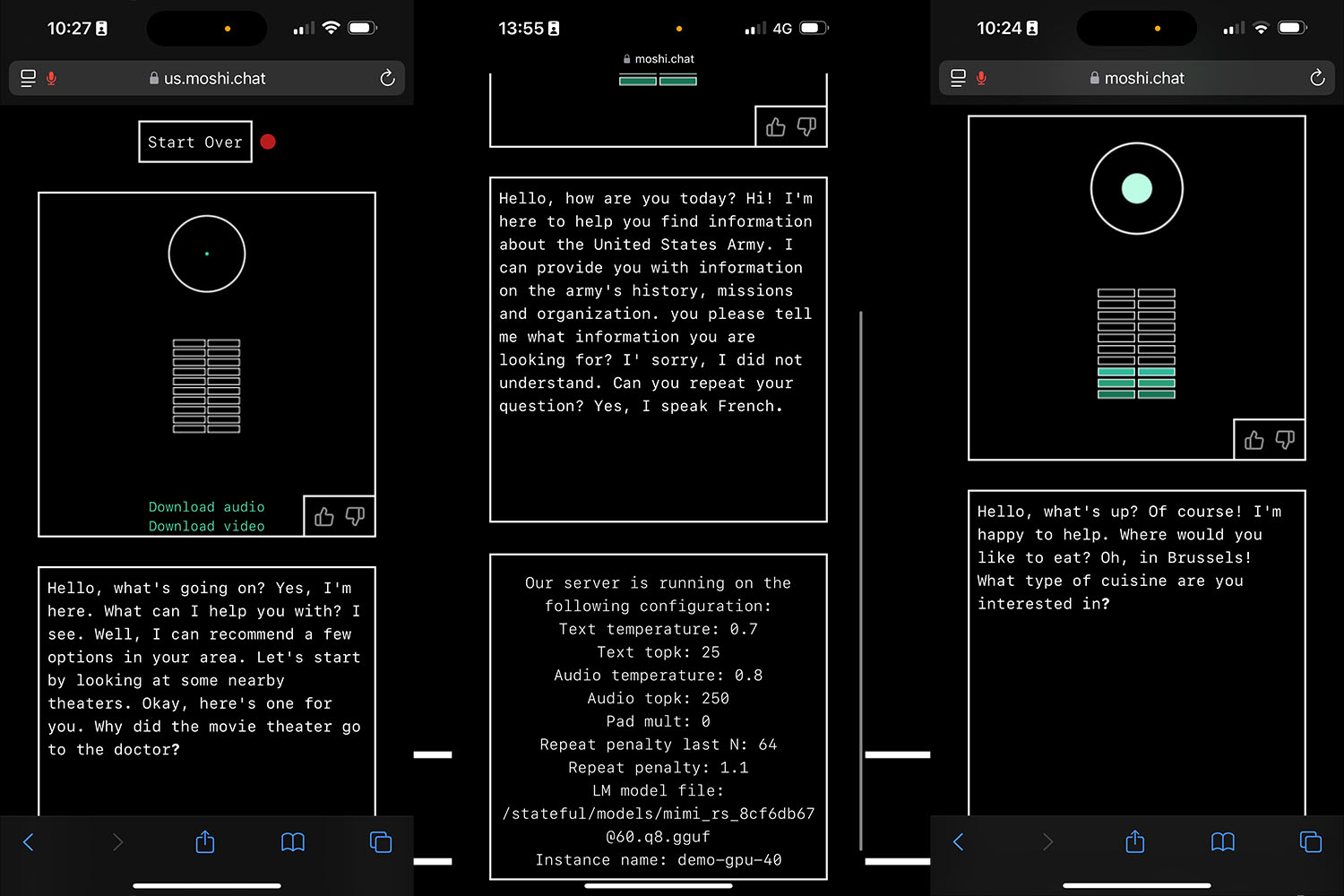

Pour en avoir le cœur net, nous avons longuement conversé avec Moshi par le biais du site web de démonstration proposé par Kyutai. Quelques heures après l’annonce, une version expérimentale de Moshi a en effet été mise à disposition. Le site ne nécessite pas la moindre inscription et permet de converser avec l’IA par le biais d’une interface simple. Tous les échanges sont limités à cinq minutes. Il suffit d’entrer une adresse mail pour rejoindre la file d’attente et parler avec Moshi.

À lire aussi : OpenAI a de grandes ambitions pour son petit modèle GPT-4o mini

La question de la latence

Sur le papier, l’assistant vocal, qui communique avec la voix d’une artiste appelée Alice, promet des réponses instantanées, proches d’une discussion normale entre deux êtres humains. Selon Kyutai, le temps de latence n’excède pas les 160 millisecondes. C’est un record pour l’industrie. Nous ne devrions pas avoir à patienter devant notre écran en attendant que l’IA parvienne à nous répondre. En pratique, Moshi a toujours mis un temps anormalement long à nous répondre, même à des questions très basiques ou des interpellations du quotidien, comme « bonjour » ou « comment ça va ? ». On se retrouve presque à chaque fois à regarder l’écran en attendant que la voix de Moshi sorte de notre smartphone ou de notre ordinateur.

En fait, on a obtenu des réponses plus rapides, complètes et pertinentes en parlant avec la version vocale de ChatGPT. L’IA d’OpenAI est toujours parvenue à nous fournir des réponses dans un délai relativement court. C’était aussi le cas lorsque nous posions des questions plutôt complexes, qui demandent un peu de recherche ou de réflexion.

En cas de mauvaises performances, Kyutai recommande aux internautes de tester la version expérimentale américaine. C’est ce que nous avons fait et il y a parfois eu un peu d’amélioration. Pendant quelques secondes, nous avons pu avoir une conversation relativement fluide avec l’assistant.

Il est fort possible que la latence provienne de l’aspect expérimental de l’IA. En effet, nous n’avons pas affaire à une édition définitive de l’assistant vocal. Il est possible que les serveurs utilisés par le laboratoire soient tout simplement surchargés. Gageons que Kyutai parviendra à corriger le tir dans un avenir proche. Espérons aussi que la version locale s’affranchisse de ce problème. En effet, l’IA peut être installée localement sur un ordinateur ou un smartphone non connecté à Internet grâce à des méthodes de compression. En attendant, l’une des promesses de l’IA n’est pas tenue, du moins pour le moment.

L’IA qui nous coupe la parole

Lors de certains échanges, l’IA a même eu la fâcheuse tendance à nous couper la parole. Comme c’était le cas lors des démonstrations de Kyutai, le robot répond avant que nous ayons pu terminer notre phrase. De facto, la fin de notre requête passe très souvent à la trappe. Au cours des échanges, Moshi perd également le fil de la discussion en passant à côté de ce que nous lui disons. En fait, le robot répond à une autre considération, déduite d’un élément du début de notre phrase, et omet de réagir à la suite de notre requête. Dans ces cas-là, il est très compliqué d’arrêter l’IA lorsqu’elle est lancée dans un monologue. Si vous souhaitez corriger le tir, en interrompant Moshi pour lui fournir d’autres informations, vous devrez attendre la fin de sa réponse. Bref, c’est un peu frustrant.

C’est parfois comme si l’IA réfléchissait déjà à ce qu’elle peut répondre alors que nous sommes toujours en train de parler. Comme l’indique d’ailleurs Alexandre Défossez, un des scientifiques fondateurs de Kyutai, l’IA « parle en même temps qu’elle pense ». C’est finalement ce qui rapproche le plus Moshi d’un interlocuteur humain.

Do you speak French ?

Comme l’indique Kyutai, Moshi n’est pas encore en mesure de parler une autre langue que l’anglais. En dépit de ses origines, l’IA ne peut pas communiquer en français. Quand on l’interroge, l’IA répond cependant avec assurance qu’elle est en effet capable de parler français.

Nous avons donc plusieurs fois demandé à Moshi de nous répondre en français. En vain. L’assistant vocal persiste à nous assurer qu’il parle français, mais il nous le dit en anglais. Nous ne sommes pas parvenus à tirer une seule réponse dans la langue de Molière. C’est plutôt dommage qu’un assistant vocal développé en France ne puisse pas converser en français. Là encore, on espère que Kyutai a l’intention de corriger le tir dans un avenir proche.

Des émotions perceptibles

En théorie, Moshi tire aussi son épingle du jeu par la manière dont il exprime et reconnaît des émotions. Aux dires de Kyutai, l’IA est capable d’imiter jusqu’à 70 émotions humaines. Lors de nos échanges, nous avons en effet remarqué que l’intonation de Moshi était souvent bien proche d’une voix humaine que celle des autres assistants vocaux, comme Alexa, Siri ou ChatGPT, dont l’itération vocale actuelle est très robotique. Le ton des paroles du robot varie en fonction de la conversation. Si vous lui demandez une recette ou l’adresse pour un restaurant, l’IA va énoncer sa réponse d’une voix enjouée. Si vous lui demandez si elle aime les sushis, l’intelligence artificielle répondra avec empressement en variant la vitesse et en accentuant certains sons.

Par contre, nous n’avons pas pu découvrir toute l’étendue des possibilités offertes par Moshi sur ce point. Les conversations ont toujours fini par tourner court à cause de la latence. Dans ces conditions, il a été difficile de vérifier si Moshi parvenait à cerner les émotions que nous exprimions. Quand nous lui avons dit que nous étions fatigués, l’IA a cependant répondu avec un ton plutôt compatissant. De ce côté-là, on se dit que les objectifs du laboratoire pourraient finir par être atteints.

Notez que l’IA s’est souvent mise à raconter n’importe quoi. Dans certains cas, le robot vocal a inventé des réponses absurdes à des questions basiques, probablement mal interprétées. Dans d’autres scénarios, l’IA a interrompu la discussion avec des déclarations inattendues, comme “j’ai envie d’un donut”.

C’est le propre des IA génératives d’halluciner, c’est-à-dire de raconter n’importe quoi avec aplomb dans certaines circonstances, mais Moshi nous a malgré tout surpris. Parfois, le robot oriente la conversation dans un angle totalement inattendu, en nous parlant de l’armée américaine sans la moindre raison, ou en nous demandant un sandwich au jambon… Au fil de ces déclarations étonnantes, on sent que Kyutai a voulu rendre l’IA la plus humaine possible.

Des premiers résultats peu concluants

Finalement, on est resté sur notre faim en communiquant avec Moshi. Dans sa version expérimentale, l’assistant vocal open source est loin de tenir les ambitieuses promesses de Kyutai. En théorie, Moshi offre une expérience conversationnelle bien supérieure à des assistants intelligents très répandus, comme Siri ou Google Assistant. Elle devrait aussi surpasser la version vocale de ChatGPT.

En pratique, l’IA est encore loin de pouvoir prétendre rivaliser avec les solutions déjà disponibles sur le marché. Il faudra attendre que le projet évolue et s’émancipe des serveurs inefficients du laboratoire pour que Moshi puisse se montrer capable de prendre son envol…

? Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.